1 | public class Parent { |

输出结果:parentB childB parentC parentA childC childA

官方解析:考察父类、子类的加载顺序:

父类的静态代码块 > 子类的静态代码块 > 父类的动态代码块 > 父类的构造方法 > 子类的动态代码块 > 子类的构造方法。

2、

3、

1 | public class Parent { |

输出结果:parentB childB parentC parentA childC childA

官方解析:考察父类、子类的加载顺序:

父类的静态代码块 > 子类的静态代码块 > 父类的动态代码块 > 父类的构造方法 > 子类的动态代码块 > 子类的构造方法。

**聚合(aggregations)**可以让我们极其方便的实现对数据的统计、分析、运算。例如:

实现这些统计功能的比数据库的sql要方便的多,而且查询速度非常快,可以实现近实时搜索效果。

聚合常见的有三类:

**桶(Bucket)**聚合:用来对文档做分组

**度量(Metric)**聚合:用以计算一些值,比如:最大值、最小值、平均值等

**管道(pipeline)**聚合:其它聚合的结果为基础做聚合

**注意:**参加聚合的字段必须是keyword、日期、数值、布尔类型

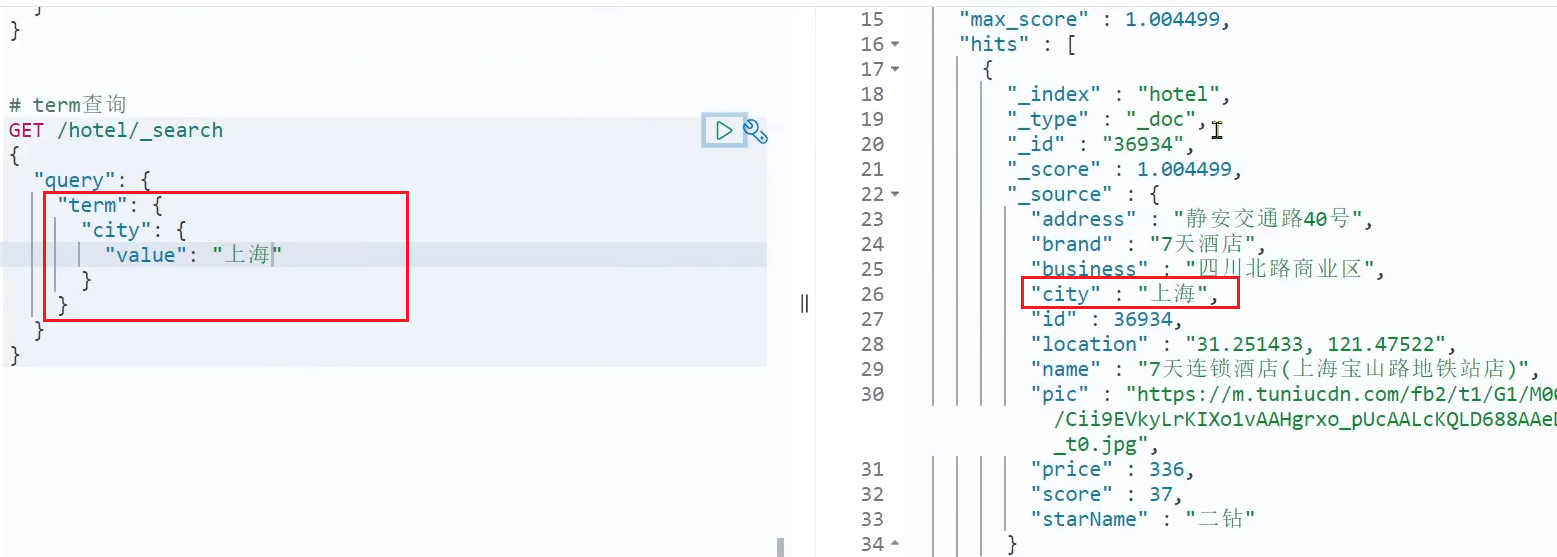

现在,我们要统计所有数据中的酒店品牌有几种,其实就是按照品牌对数据分组。此时可以根据酒店品牌的名称做聚合,也就是Bucket聚合。

语法如下:

1 | GET /hotel/_search |

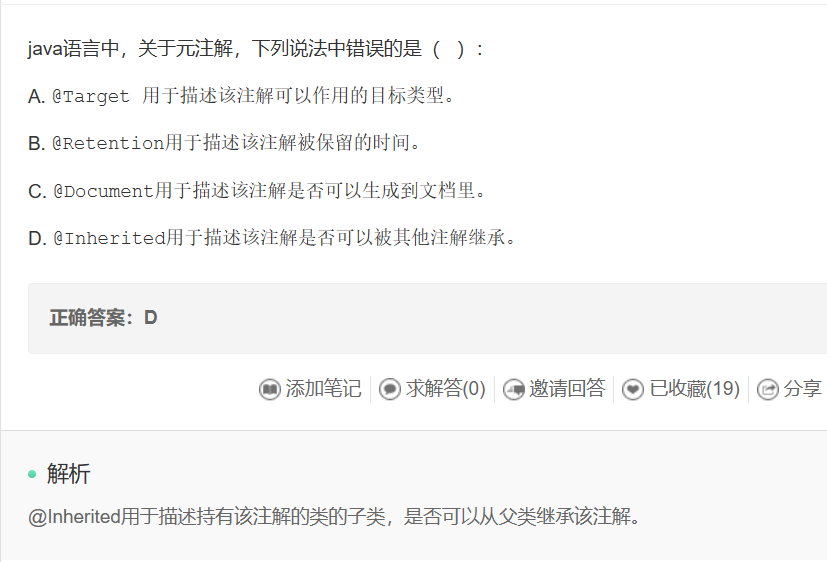

结果如图:

默认情况下,Bucket聚合会统计Bucket内的文档数量,记为_count,并且按照_count降序排序。

我们可以指定order属性,自定义聚合的排序方式:

1 | GET /hotel/_search |

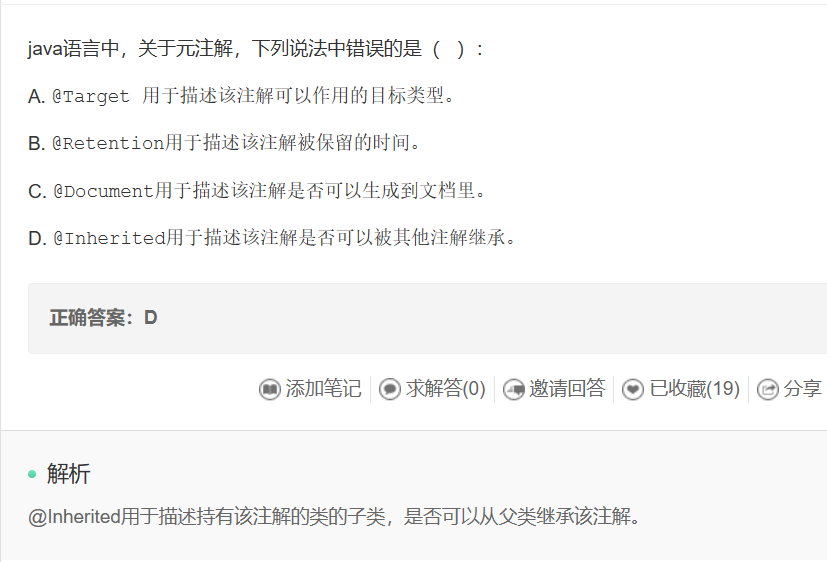

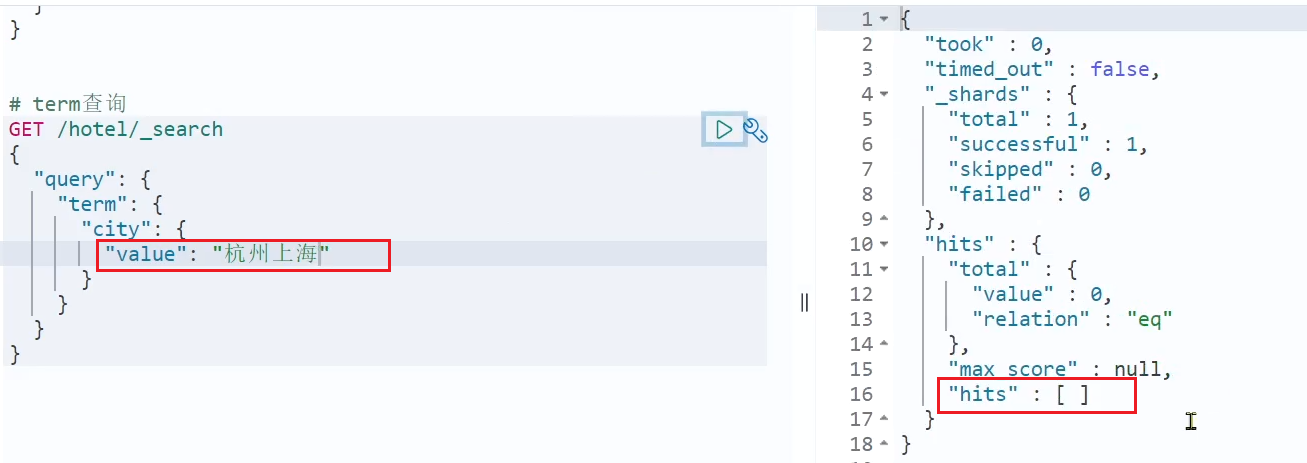

默认情况下,Bucket聚合是对索引库的所有文档做聚合,但真实场景下,用户会输入搜索条件,因此聚合必须是对搜索结果聚合。那么聚合必须添加限定条件。

我们可以限定要聚合的文档范围,只要添加query条件即可:

1 | GET /hotel/_search |

这次,聚合得到的品牌明显变少了:

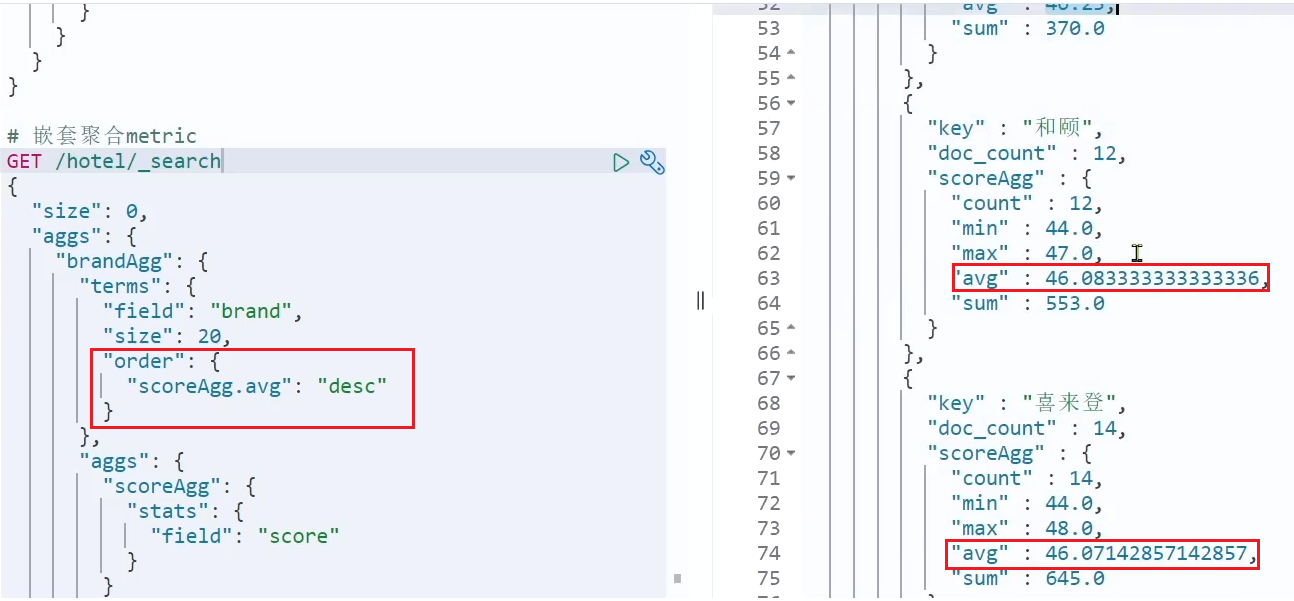

上节课,我们对酒店按照品牌分组,形成了一个个桶。现在我们需要对桶内的酒店做运算,获取每个品牌的用户评分的min、max、avg等值。

这就要用到Metric聚合了,例如stat聚合:就可以获取min、max、avg等结果。

语法如下:

1 | GET /hotel/_search |

这次的score_stats聚合是在brandAgg的聚合内部嵌套的子聚合。因为我们需要在每个桶分别计算。

另外,我们还可以给聚合结果做个排序,例如按照每个桶的酒店平均分做排序:

aggs代表聚合,与query同级,此时query的作用是?

聚合必须的三要素:

聚合可配置属性有:

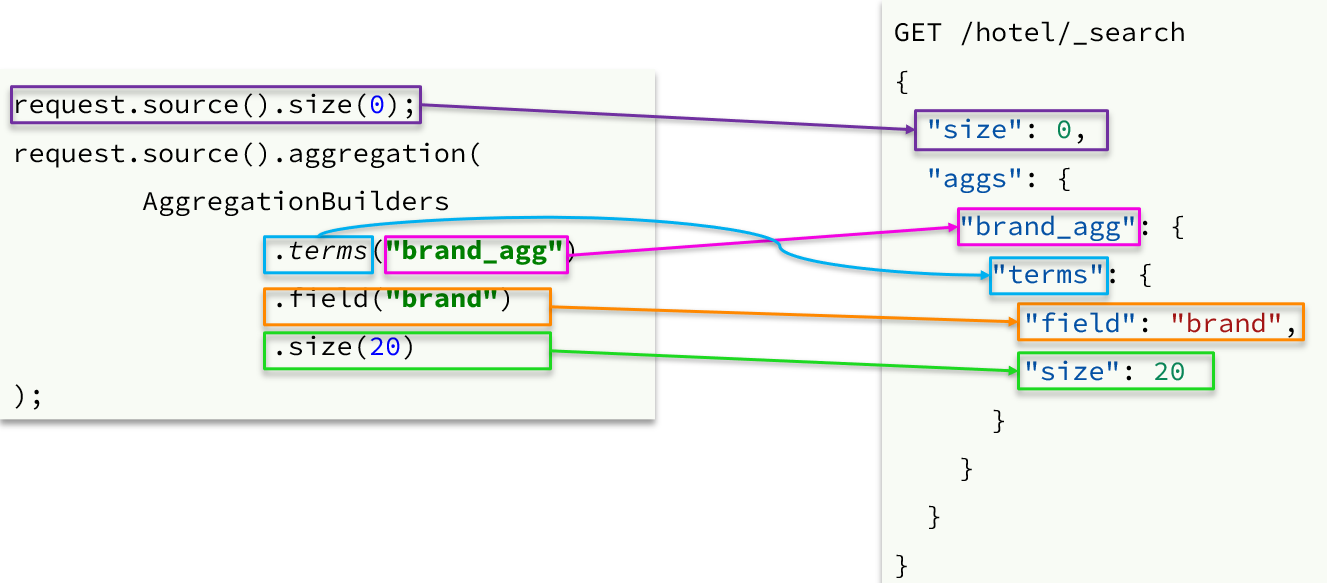

聚合条件与query条件同级别,因此需要使用request.source()来指定聚合条件。

聚合条件的语法:

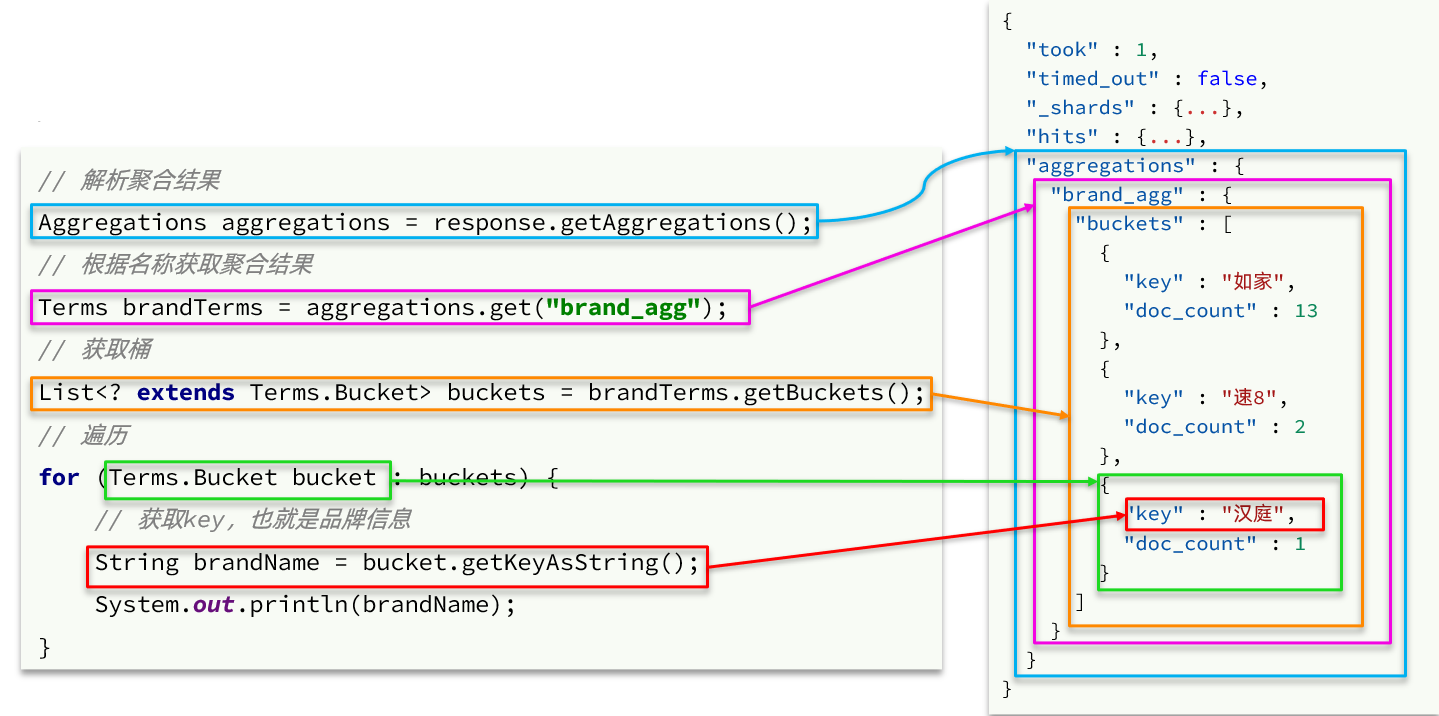

聚合的结果也与查询结果不同,API也比较特殊。不过同样是JSON逐层解析:

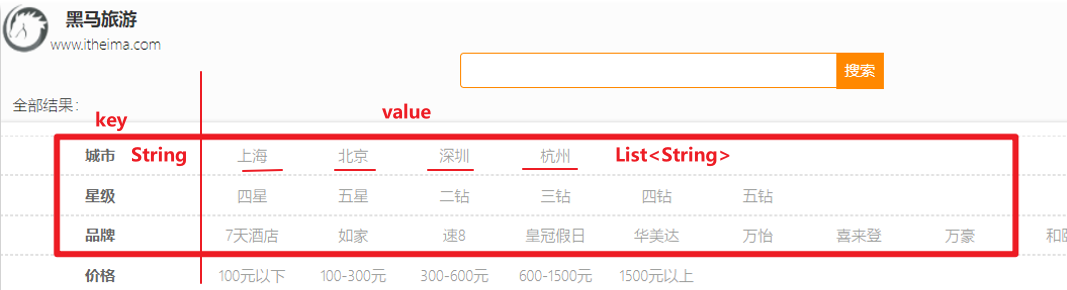

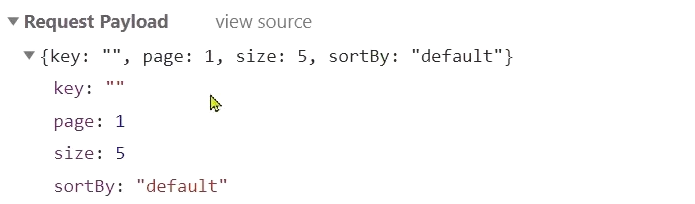

需求:搜索页面的品牌、城市等信息不应该是在页面写死,而是通过聚合索引库中的酒店数据得来的:

分析:

目前,页面的城市列表、星级列表、品牌列表都是写死的,并不会随着搜索结果的变化而变化。但是用户搜索条件改变时,搜索结果会跟着变化。

例如:用户搜索“东方明珠”,那搜索的酒店肯定是在上海东方明珠附近,因此,城市只能是上海,此时城市列表中就不应该显示北京、深圳、杭州这些信息了。

也就是说,搜索结果中包含哪些城市,页面就应该列出哪些城市;搜索结果中包含哪些品牌,页面就应该列出哪些品牌。

如何得知搜索结果中包含哪些品牌?如何得知搜索结果中包含哪些城市?

使用聚合功能,利用Bucket聚合,对搜索结果中的文档基于品牌分组、基于城市分组,就能得知包含哪些品牌、哪些城市了。

因为是对搜索结果聚合,因此聚合是限定范围的聚合,也就是说聚合的限定条件跟搜索文档的条件一致。

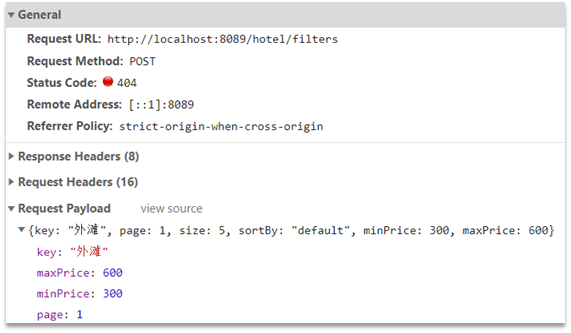

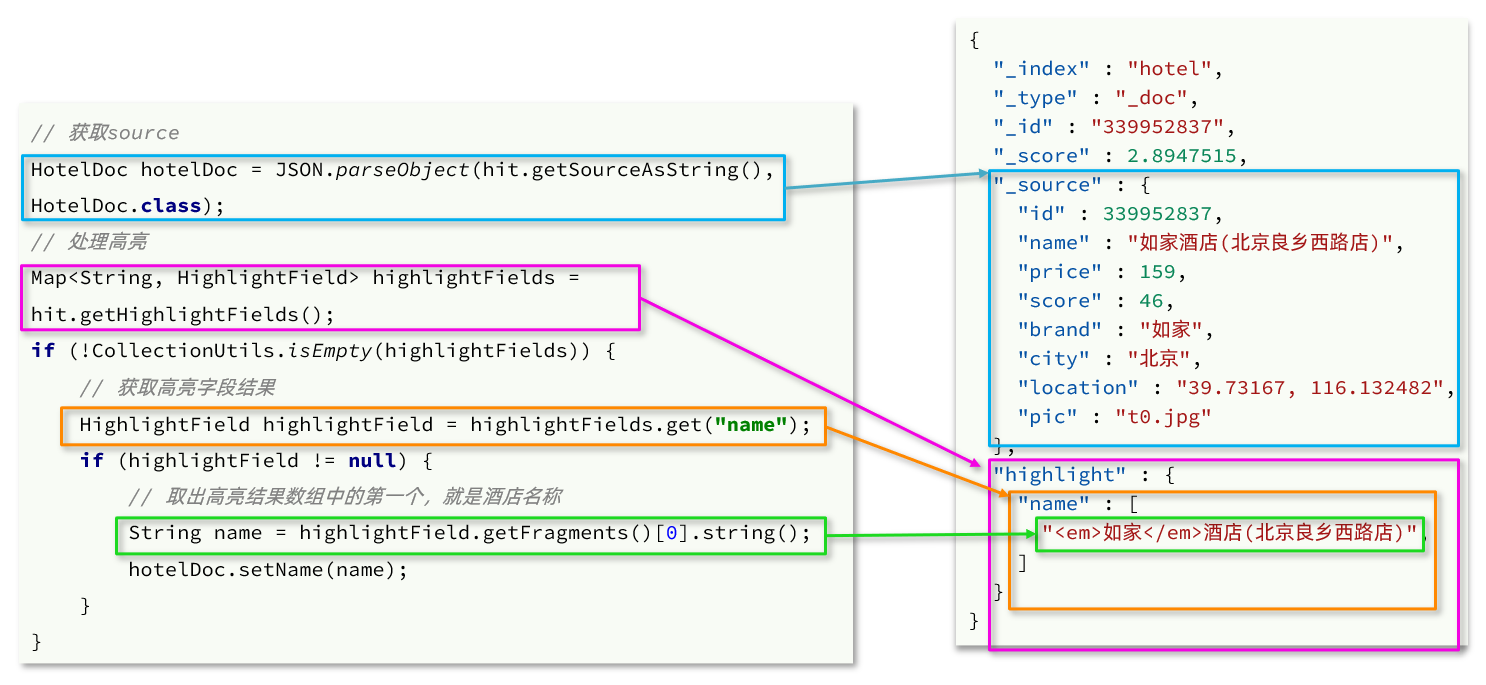

查看浏览器可以发现,前端其实已经发出了这样的一个请求:

请求参数与搜索文档的参数完全一致。

返回值类型就是页面要展示的最终结果:

结果是一个Map结构:

在cn.itcast.hotel.web包的HotelController中添加一个方法,遵循下面的要求:

POST/hotel/filtersRequestParams,与搜索文档的参数一致Map<String, List<String>>代码:

1 |

|

这里调用了IHotelService中的getFilters方法,尚未实现。

在cn.itcast.hotel.service.IHotelService中定义新方法:

1 | Map<String, List<String>> filters(RequestParams params); |

在cn.itcast.hotel.service.impl.HotelService中实现该方法:

1 |

|

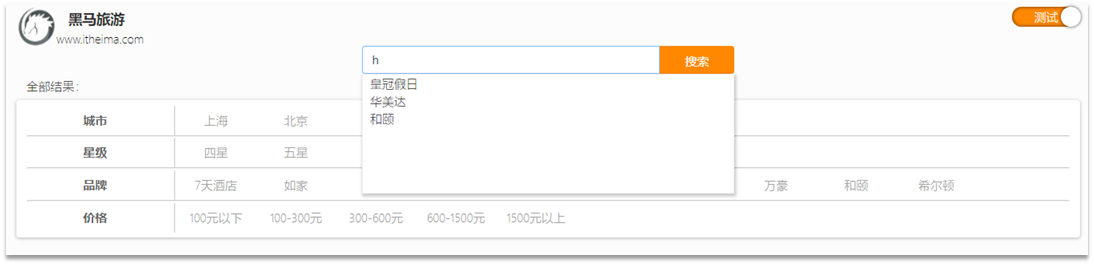

当用户在搜索框输入字符时,我们应该提示出与该字符有关的搜索项,如图:

这种根据用户输入的字母,提示完整词条的功能,就是自动补全了。

因为需要根据拼音字母来推断,因此要用到拼音分词功能。

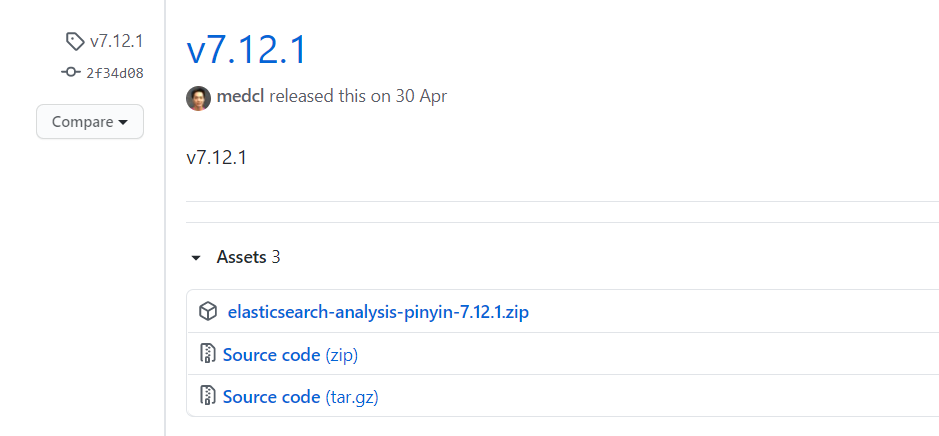

要实现根据字母做补全,就必须对文档按照拼音分词。在GitHub上恰好有elasticsearch的拼音分词插件。地址:https://github.com/medcl/elasticsearch-analysis-pinyin

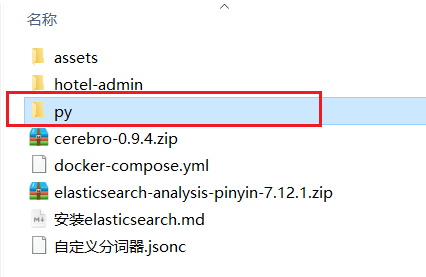

课前资料中也提供了拼音分词器的安装包:

安装方式与IK分词器一样,分三步:

①解压

②上传到虚拟机中,elasticsearch的plugin目录

③重启elasticsearch

④测试

详细安装步骤可以参考IK分词器的安装过程。

测试用法如下:

1 | POST /_analyze |

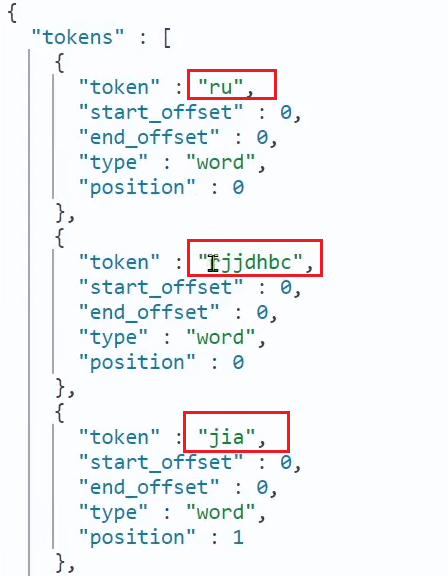

结果:

默认的拼音分词器会将每个汉字单独分为拼音,而我们希望的是每个词条形成一组拼音,需要对拼音分词器做个性化定制,形成自定义分词器。

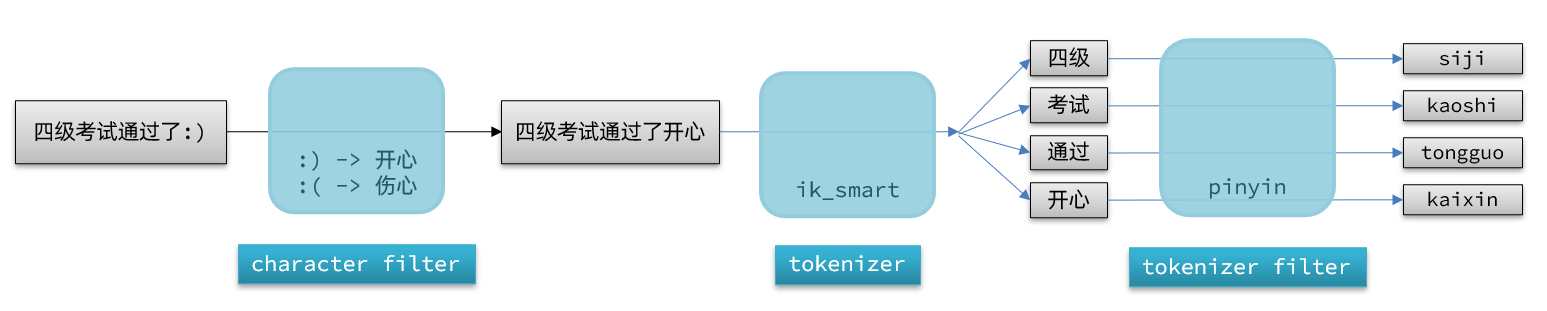

elasticsearch中分词器(analyzer)的组成包含三部分:

文档分词时会依次由这三部分来处理文档:

声明自定义分词器的语法如下:

1 | PUT /test |

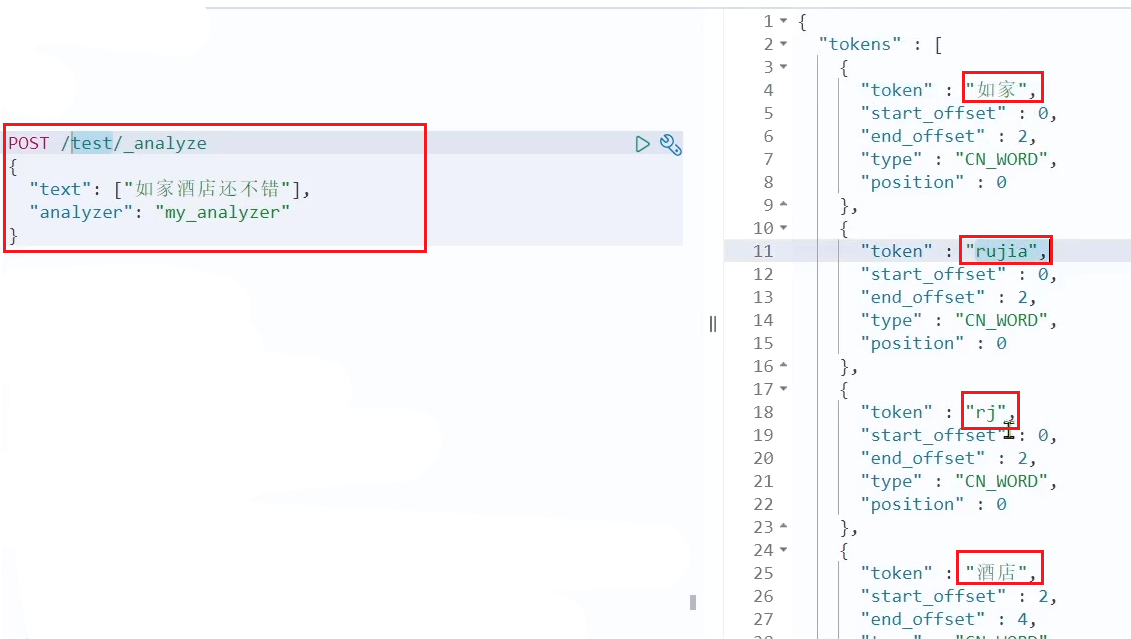

测试:

如何使用拼音分词器?

①下载pinyin分词器

②解压并放到elasticsearch的plugin目录

③重启即可

如何自定义分词器?

①创建索引库时,在settings中配置,可以包含三部分

②character filter

③tokenizer

④filter

拼音分词器注意事项?

elasticsearch提供了Completion Suggester查询来实现自动补全功能。这个查询会匹配以用户输入内容开头的词条并返回。为了提高补全查询的效率,对于文档中字段的类型有一些约束:

参与补全查询的字段必须是completion类型。

字段的内容一般是用来补全的多个词条形成的数组。

比如,一个这样的索引库:

1 | // 创建索引库 |

然后插入下面的数据:

1 | // 示例数据 |

查询的DSL语句如下:

1 | // 自动补全查询 |

现在,我们的hotel索引库还没有设置拼音分词器,需要修改索引库中的配置。但是我们知道索引库是无法修改的,只能删除然后重新创建。

另外,我们需要添加一个字段,用来做自动补全,将brand、suggestion、city等都放进去,作为自动补全的提示。

因此,总结一下,我们需要做的事情包括:

修改hotel索引库结构,设置自定义拼音分词器

修改索引库的name、all字段,使用自定义分词器

索引库添加一个新字段suggestion,类型为completion类型,使用自定义的分词器

给HotelDoc类添加suggestion字段,内容包含brand、business

重新导入数据到hotel库

代码如下:

1 | // 酒店数据索引库 |

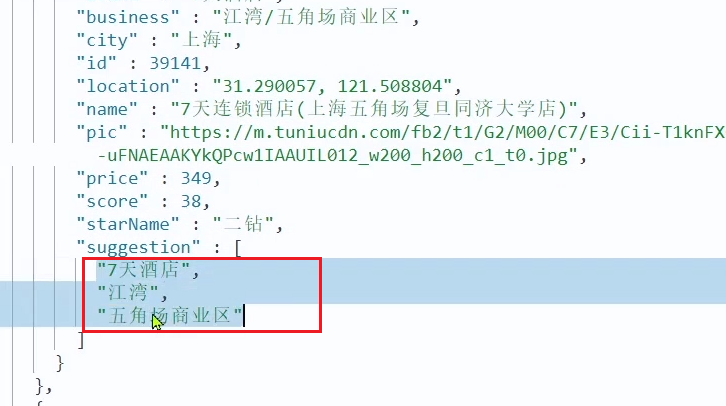

HotelDoc中要添加一个字段,用来做自动补全,内容可以是酒店品牌、城市、商圈等信息。按照自动补全字段的要求,最好是这些字段的数组。

因此我们在HotelDoc中添加一个suggestion字段,类型为List<String>,然后将brand、city、business等信息放到里面。

代码如下:

1 | package cn.itcast.hotel.pojo; |

重新执行之前编写的导入数据功能,可以看到新的酒店数据中包含了suggestion:

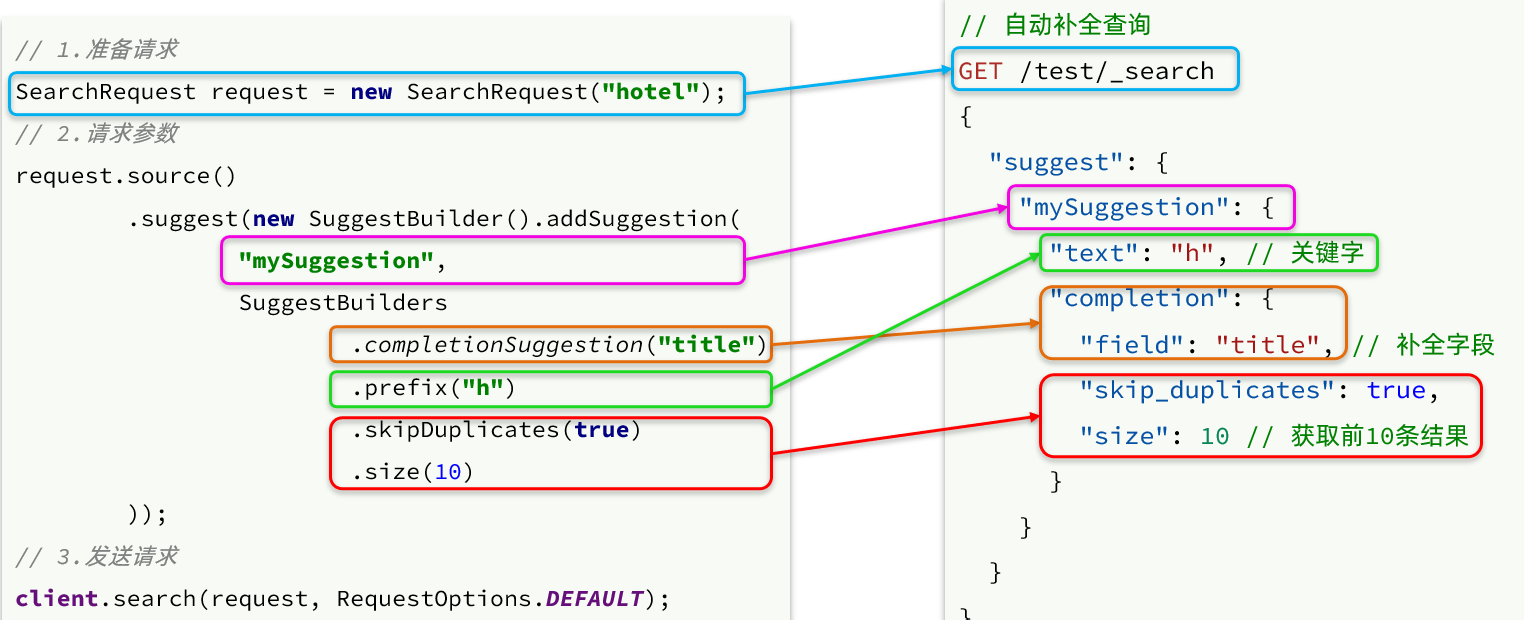

之前我们学习了自动补全查询的DSL,而没有学习对应的JavaAPI,这里给出一个示例:

而自动补全的结果也比较特殊,解析的代码如下:

查看前端页面,可以发现当我们在输入框键入时,前端会发起ajax请求:

返回值是补全词条的集合,类型为List<String>

1)在cn.itcast.hotel.web包下的HotelController中添加新接口,接收新的请求:

1 |

|

2)在cn.itcast.hotel.service包下的IhotelService中添加方法:

1 | List<String> getSuggestions(String prefix); |

3)在cn.itcast.hotel.service.impl.HotelService中实现该方法:

1 |

|

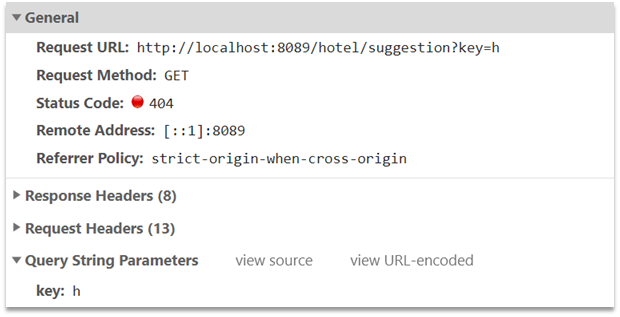

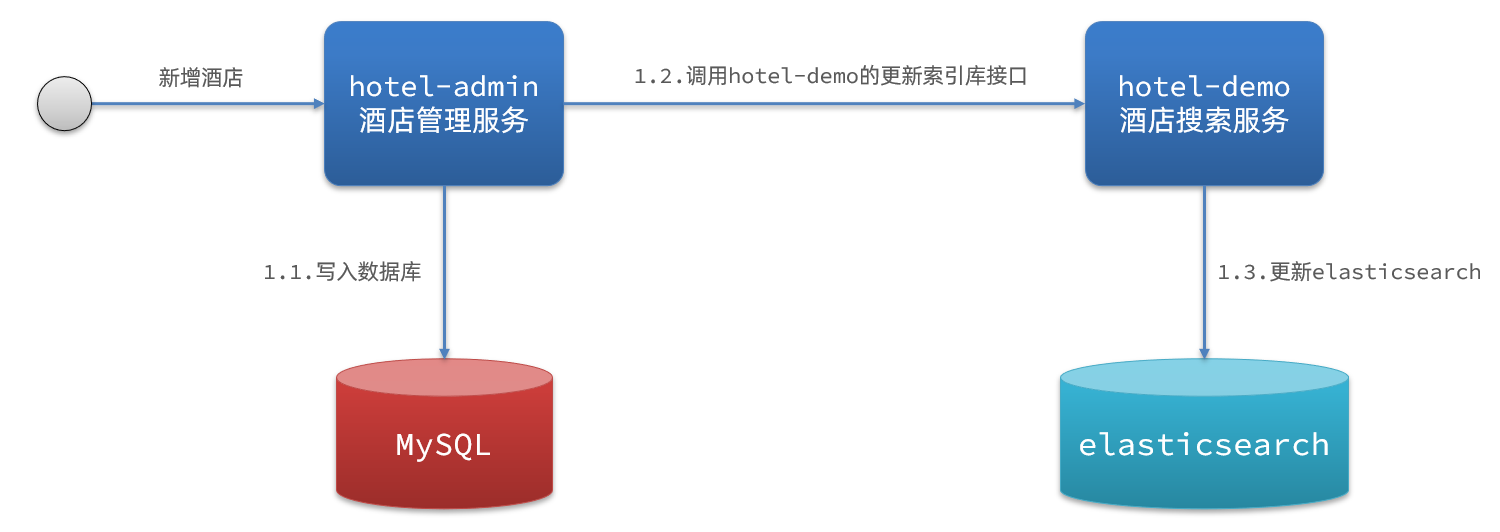

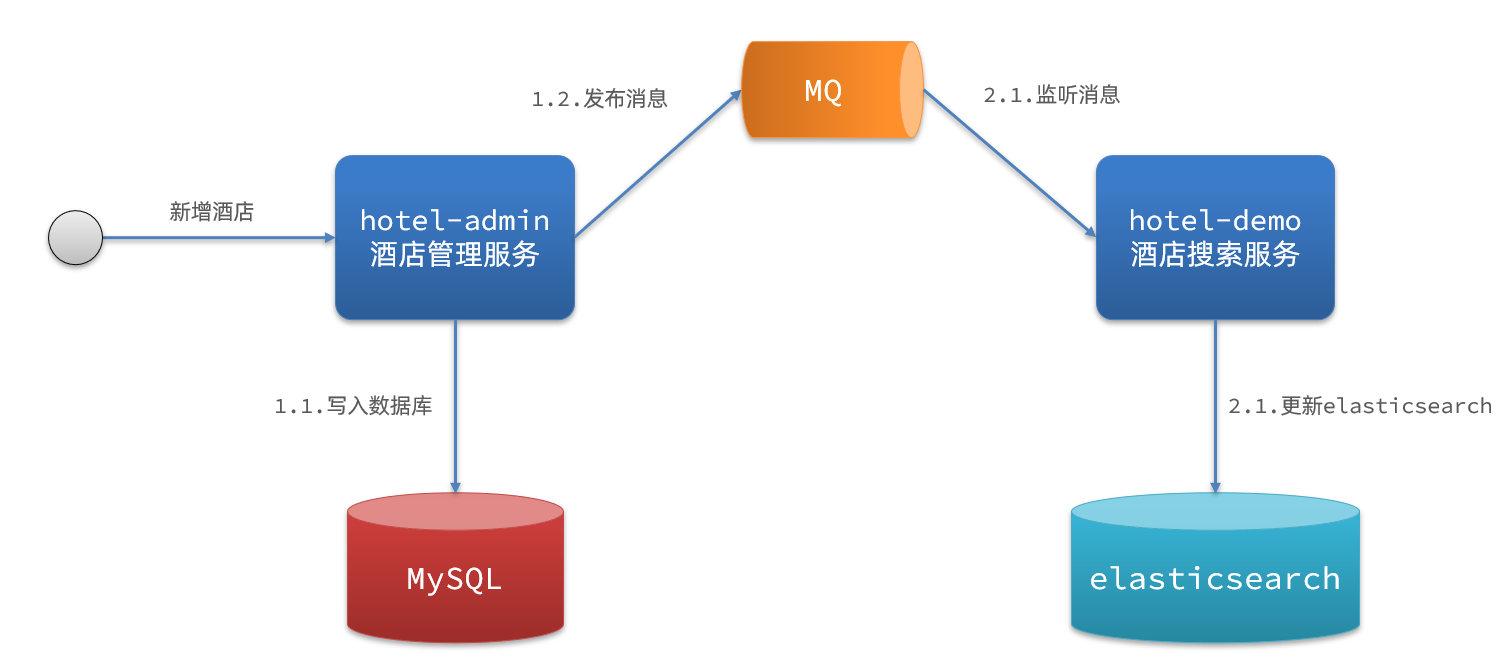

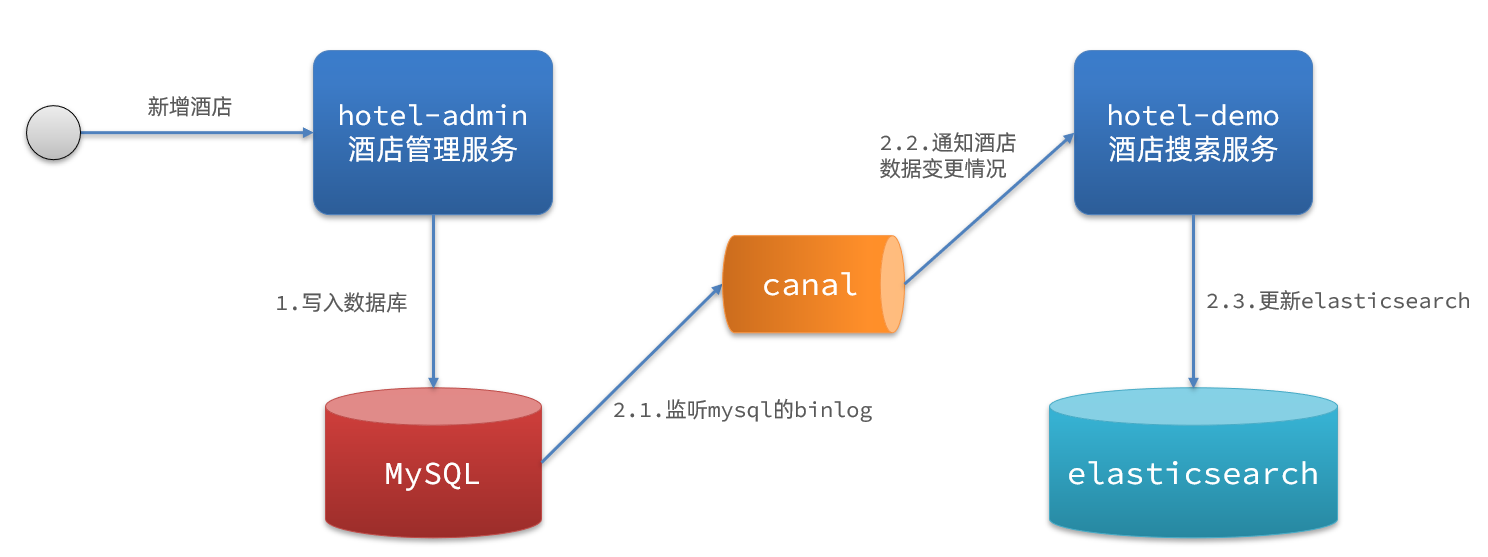

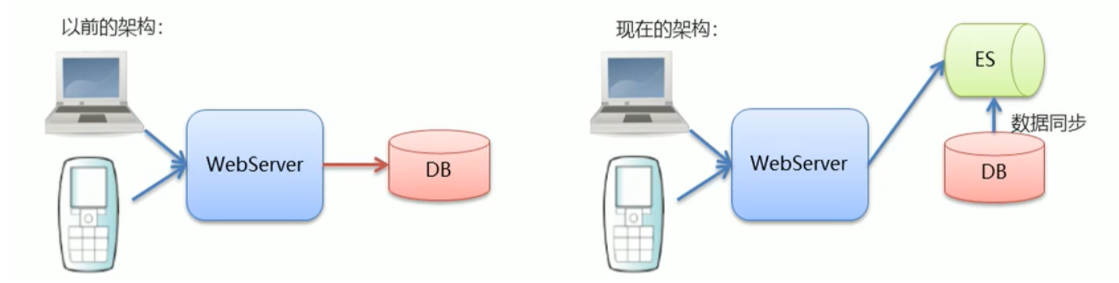

elasticsearch中的酒店数据来自于mysql数据库,因此mysql数据发生改变时,elasticsearch也必须跟着改变,这个就是elasticsearch与mysql之间的数据同步。

常见的数据同步方案有三种:

方案一:同步调用

基本步骤如下:

方案二:异步通知

流程如下:

方案三:监听binlog

流程如下:

方式一:同步调用

方式二:异步通知

方式三:监听binlog

利用课前资料提供的hotel-admin项目作为酒店管理的微服务。当酒店数据发生增、删、改时,要求对elasticsearch中数据也要完成相同操作。

步骤:

导入课前资料提供的hotel-admin项目,启动并测试酒店数据的CRUD

声明exchange、queue、RoutingKey

在hotel-admin中的增、删、改业务中完成消息发送

在hotel-demo中完成消息监听,并更新elasticsearch中数据

启动并测试数据同步功能

导入课前资料提供的hotel-admin项目:

运行后,访问 http://localhost:8099

其中包含了酒店的CRUD功能:

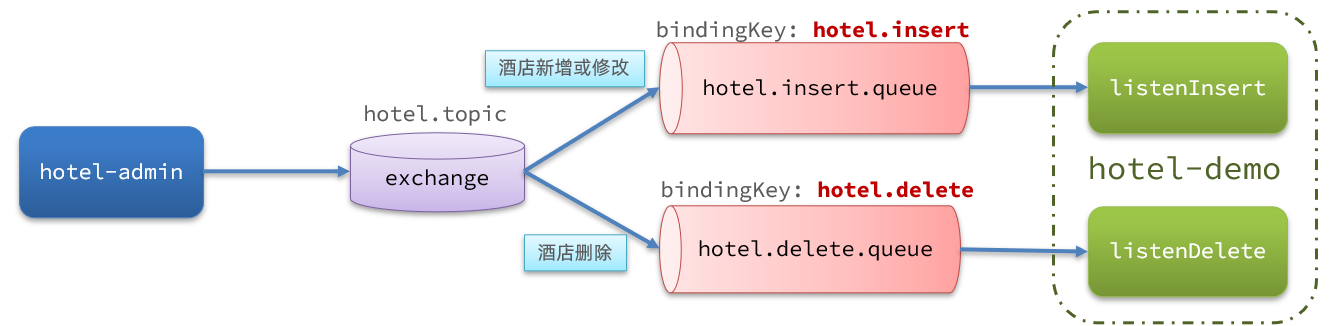

MQ结构如图:

在hotel-admin、hotel-demo中引入rabbitmq的依赖:

1 | <!--amqp--> |

在hotel-admin和hotel-demo中的cn.itcast.hotel.constatnts包下新建一个类MqConstants:

1 | package cn.itcast.hotel.constatnts; |

在hotel-demo中,定义配置类,声明队列、交换机:

1 | package cn.itcast.hotel.config; |

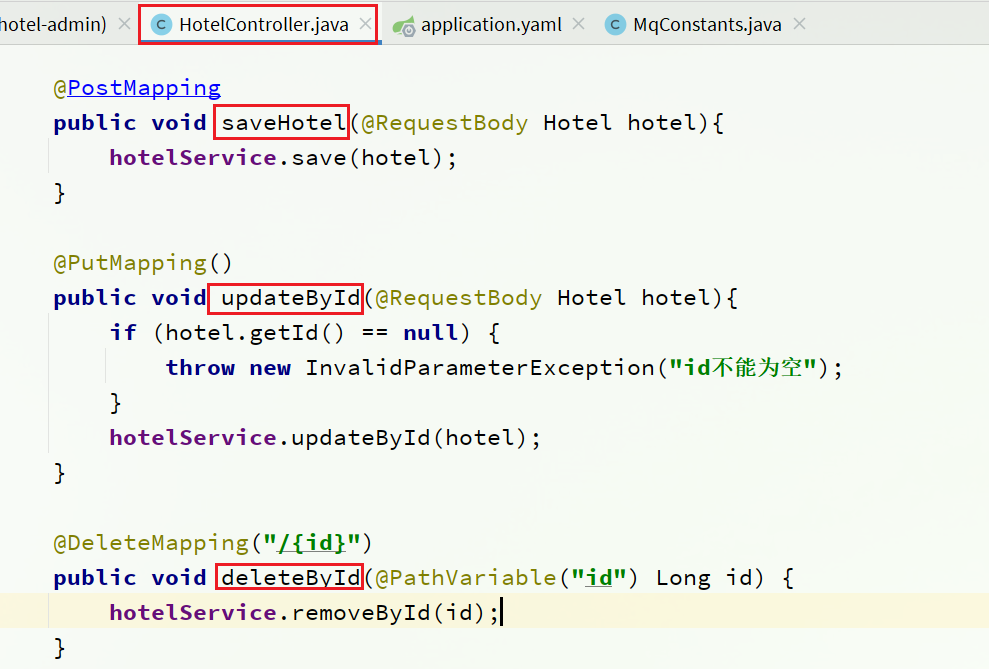

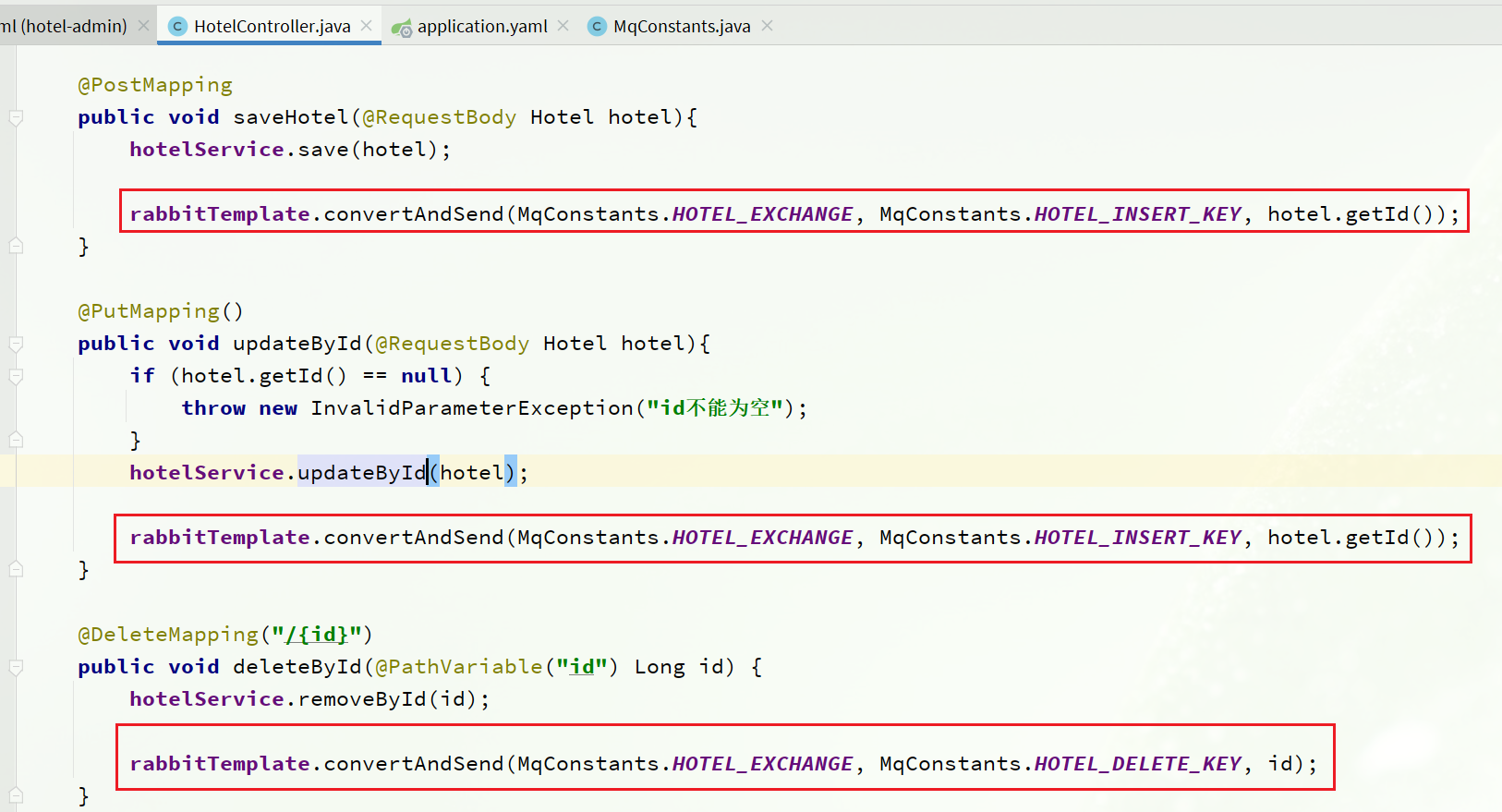

在hotel-admin中的增、删、改业务中分别发送MQ消息:

hotel-demo接收到MQ消息要做的事情包括:

1)首先在hotel-demo的cn.itcast.hotel.service包下的IHotelService中新增新增、删除业务

1 | void deleteById(Long id); |

2)给hotel-demo中的cn.itcast.hotel.service.impl包下的HotelService中实现业务:

1 |

|

3)编写监听器

在hotel-demo中的cn.itcast.hotel.mq包新增一个类:

1 | package cn.itcast.hotel.mq; |

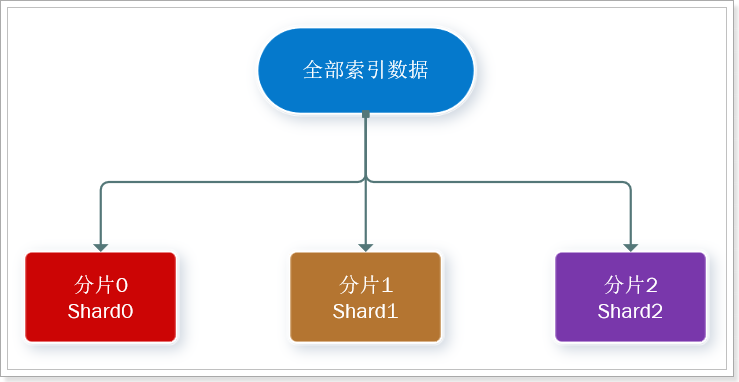

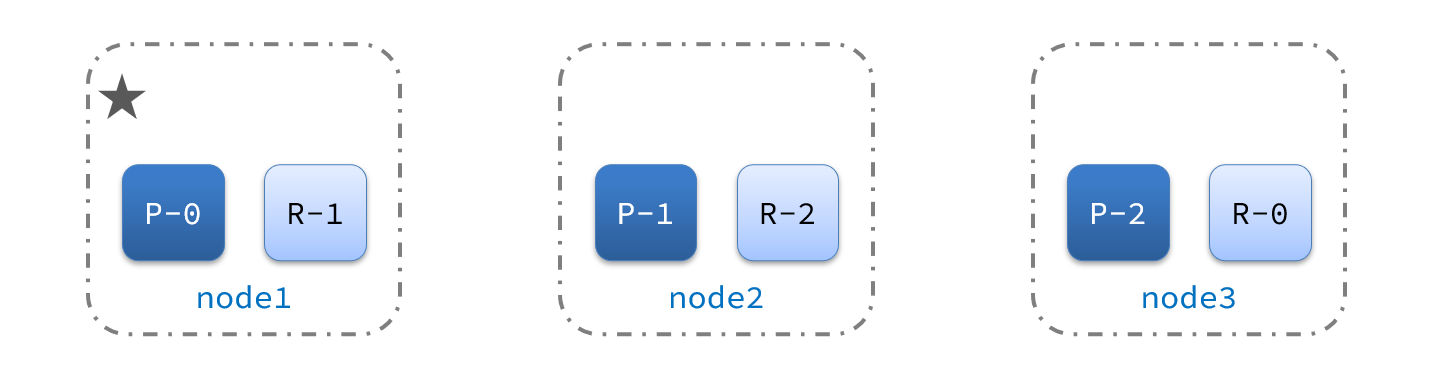

单机的elasticsearch做数据存储,必然面临两个问题:海量数据存储问题、单点故障问题。

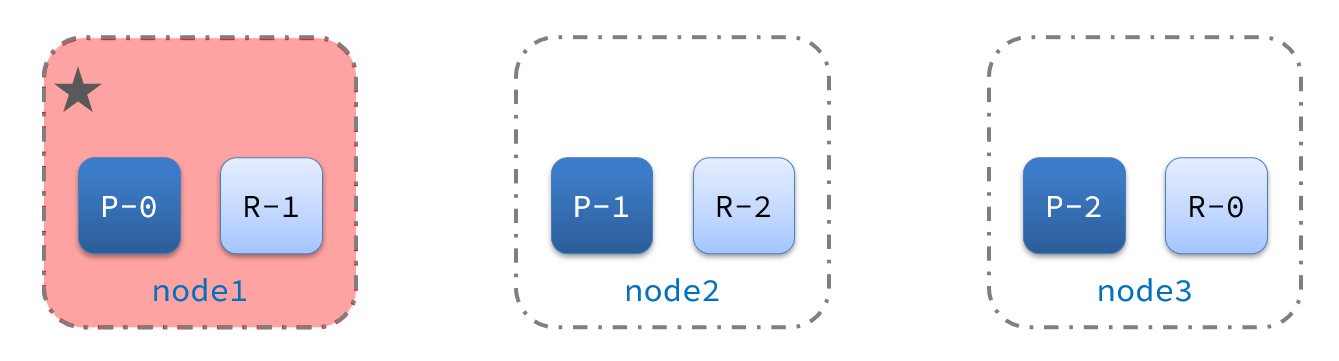

ES集群相关概念:

集群(cluster):一组拥有共同的 cluster name 的 节点。

节点(node) :集群中的一个 Elasticearch 实例

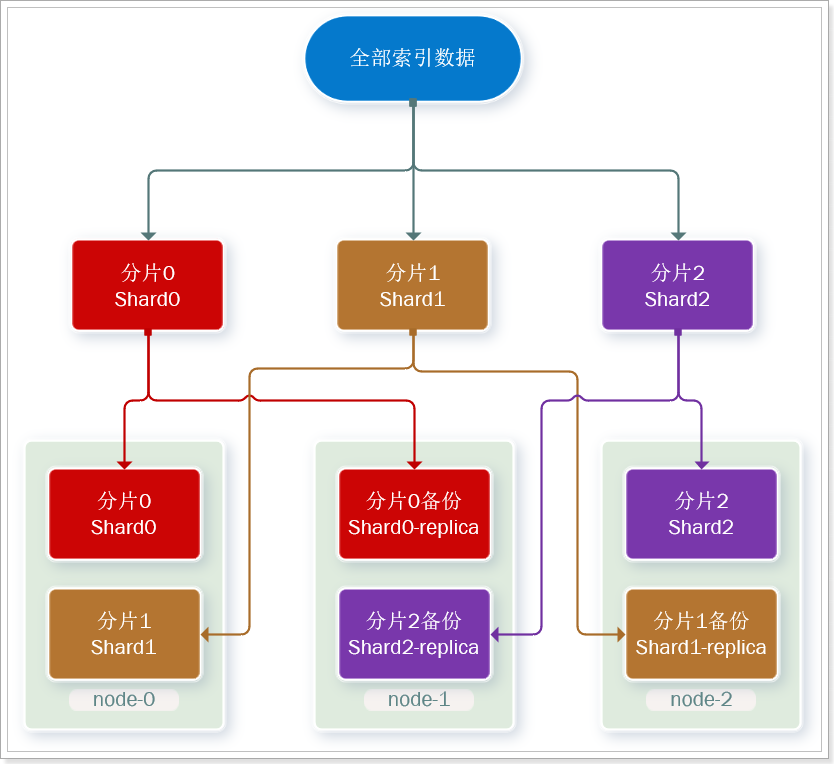

分片(shard):索引可以被拆分为不同的部分进行存储,称为分片。在集群环境下,一个索引的不同分片可以拆分到不同的节点中

解决问题:数据量太大,单点存储量有限的问题。

此处,我们把数据分成3片:shard0、shard1、shard2

主分片(Primary shard):相对于副本分片的定义。

副本分片(Replica shard)每个主分片可以有一个或者多个副本,数据和主分片一样。

数据备份可以保证高可用,但是每个分片备份一份,所需要的节点数量就会翻一倍,成本实在是太高了!

为了在高可用和成本间寻求平衡,我们可以这样做:

这样可以大大减少所需要的服务节点数量,如图,我们以3分片,每个分片备份一份为例:

现在,每个分片都有1个备份,存储在3个节点:

参考课前资料的文档:

其中的第四章节:

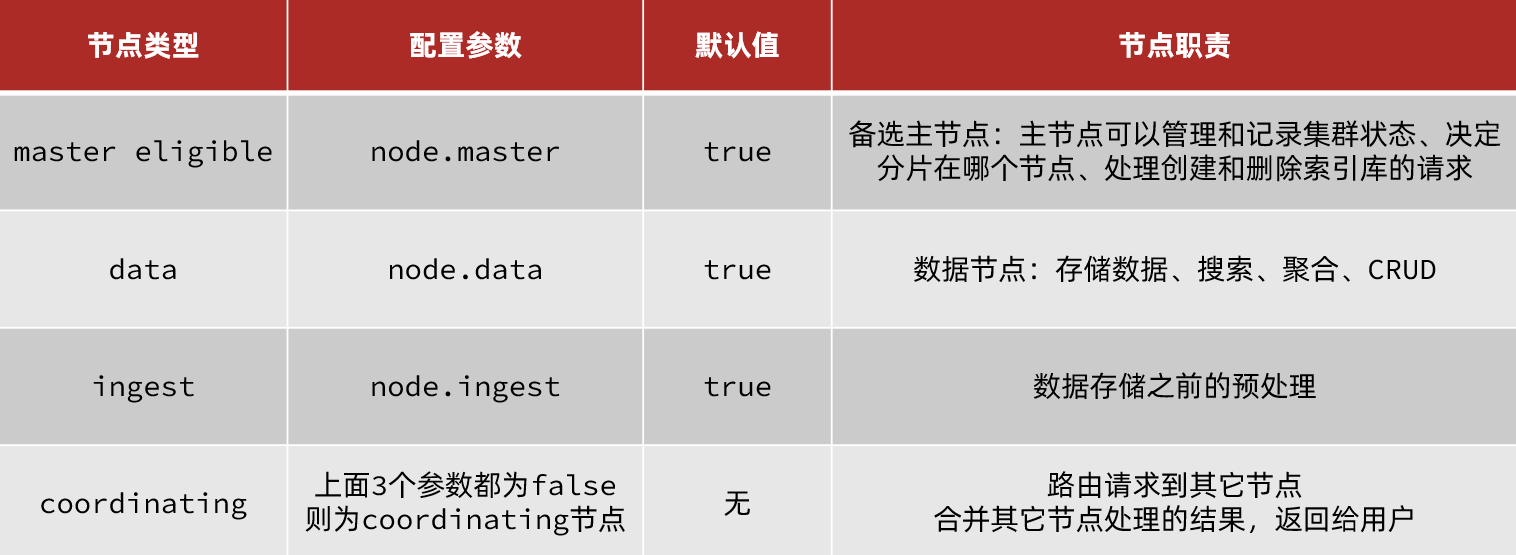

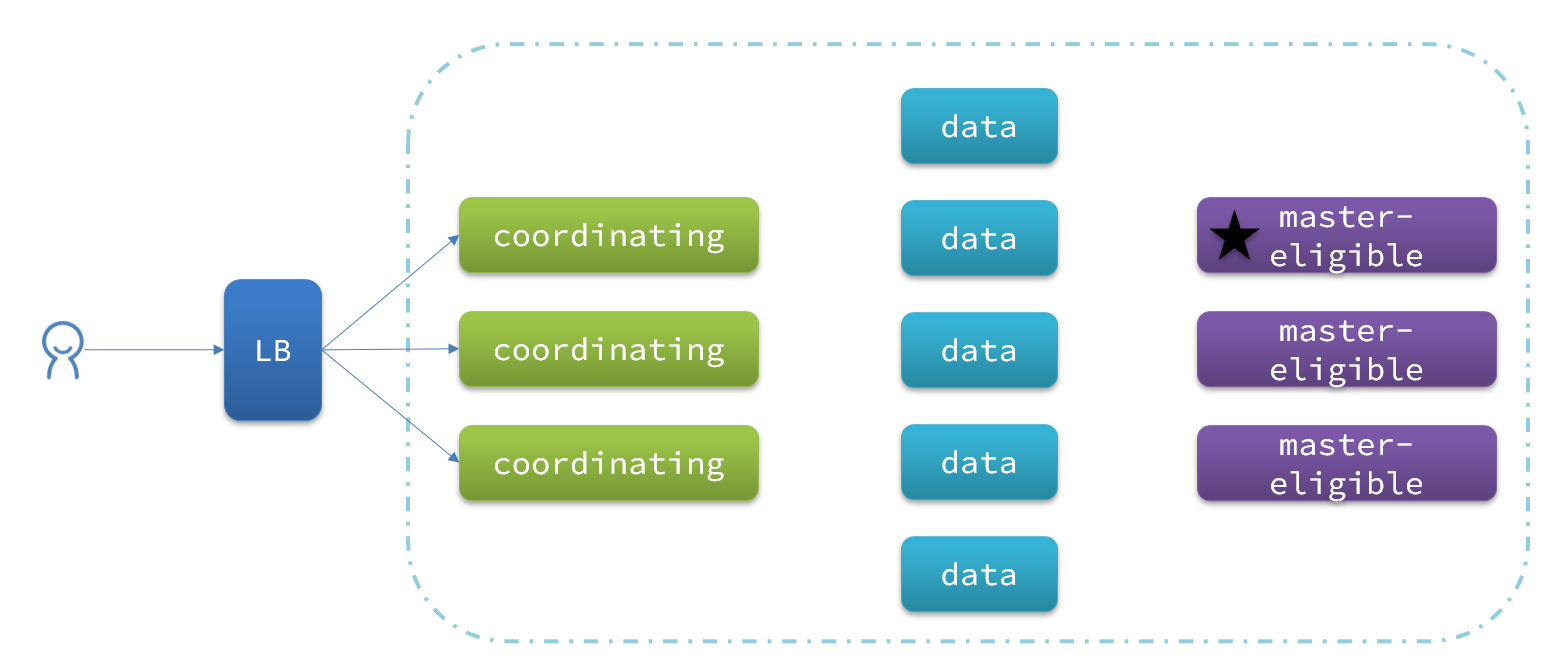

elasticsearch中集群节点有不同的职责划分:

默认情况下,集群中的任何一个节点都同时具备上述四种角色。

但是真实的集群一定要将集群职责分离:

职责分离可以让我们根据不同节点的需求分配不同的硬件去部署。而且避免业务之间的互相干扰。

一个典型的es集群职责划分如图:

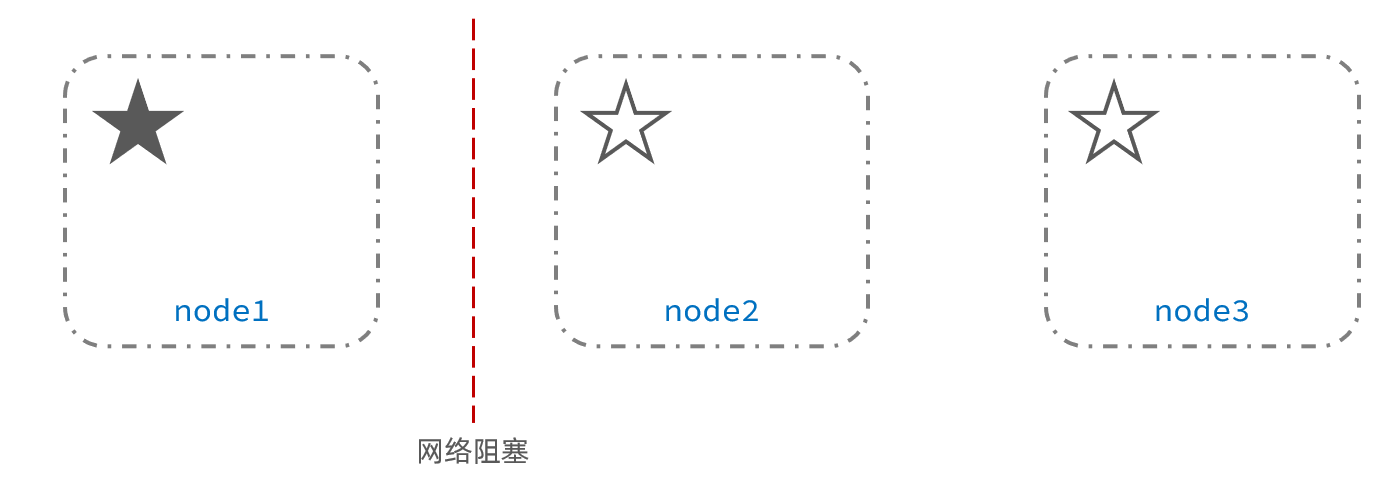

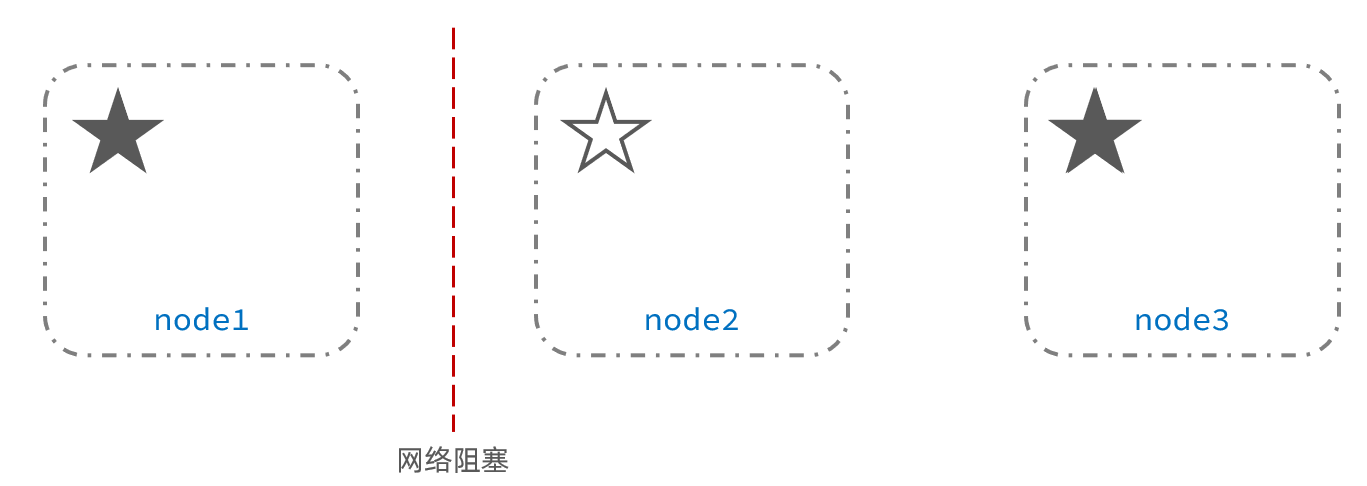

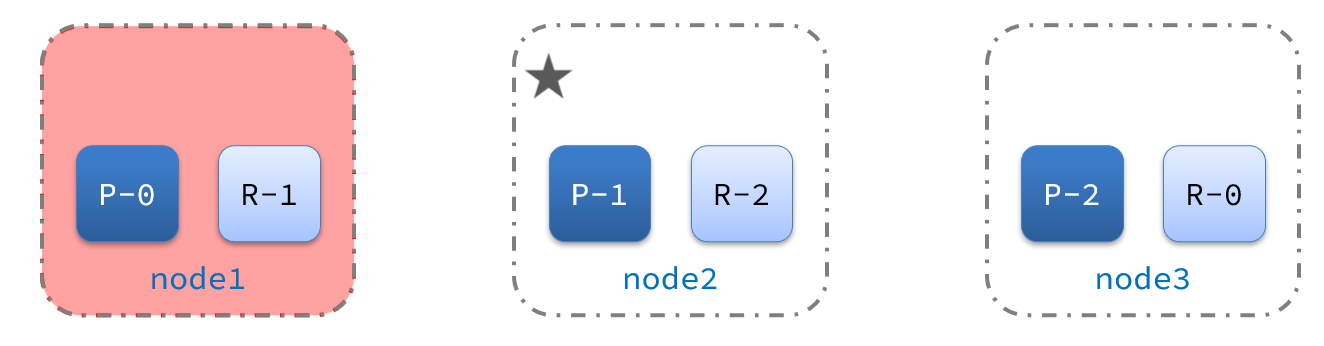

脑裂是因为集群中的节点失联导致的。

例如一个集群中,主节点与其它节点失联:

此时,node2和node3认为node1宕机,就会重新选主:

当node3当选后,集群继续对外提供服务,node2和node3自成集群,node1自成集群,两个集群数据不同步,出现数据差异。

当网络恢复后,因为集群中有两个master节点,集群状态的不一致,出现脑裂的情况:

解决脑裂的方案是,要求选票超过 ( eligible节点数量 + 1 )/ 2 才能当选为主,因此eligible节点数量最好是奇数。对应配置项是discovery.zen.minimum_master_nodes,在es7.0以后,已经成为默认配置,因此一般不会发生脑裂问题

例如:3个节点形成的集群,选票必须超过 (3 + 1) / 2 ,也就是2票。node3得到node2和node3的选票,当选为主。node1只有自己1票,没有当选。集群中依然只有1个主节点,没有出现脑裂。

master eligible节点的作用是什么?

data节点的作用是什么?

coordinator节点的作用是什么?

路由请求到其它节点

合并查询到的结果,返回给用户

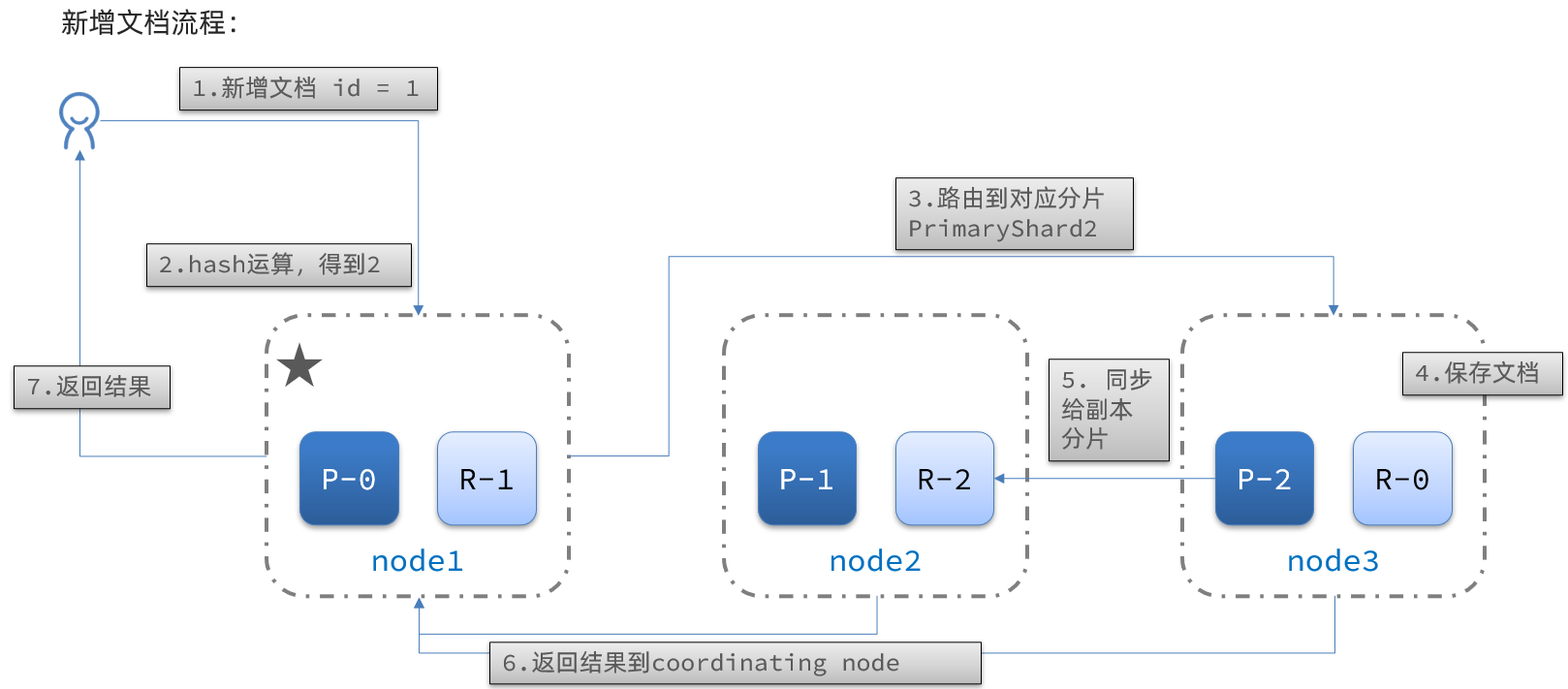

当新增文档时,应该保存到不同分片,保证数据均衡,那么coordinating node如何确定数据该存储到哪个分片呢?

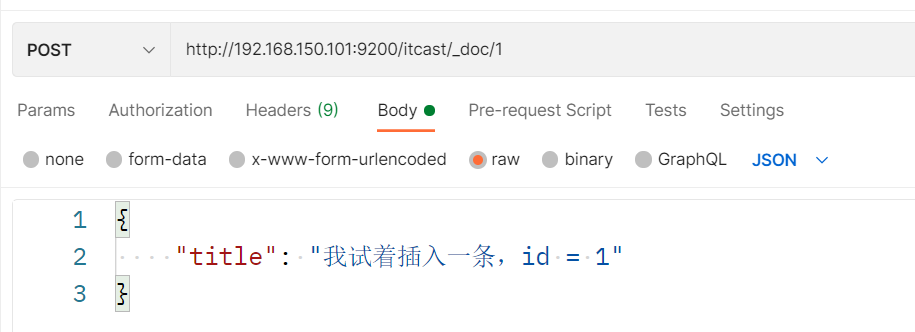

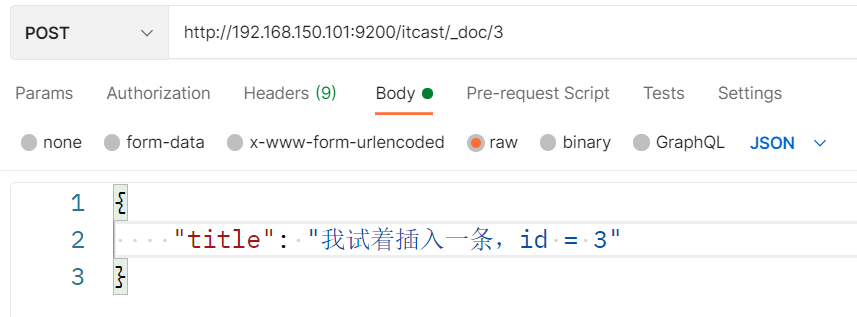

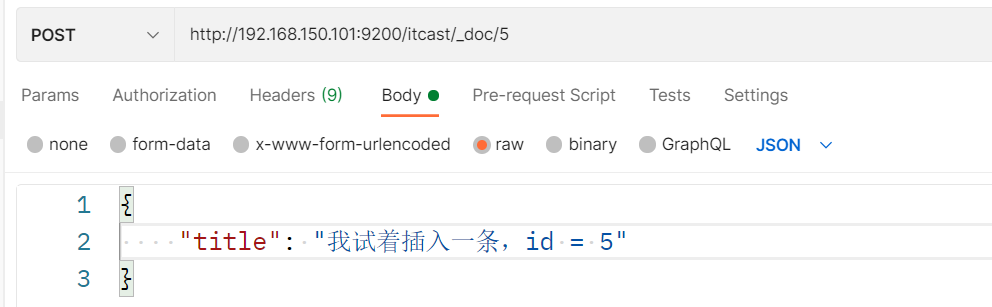

插入三条数据:

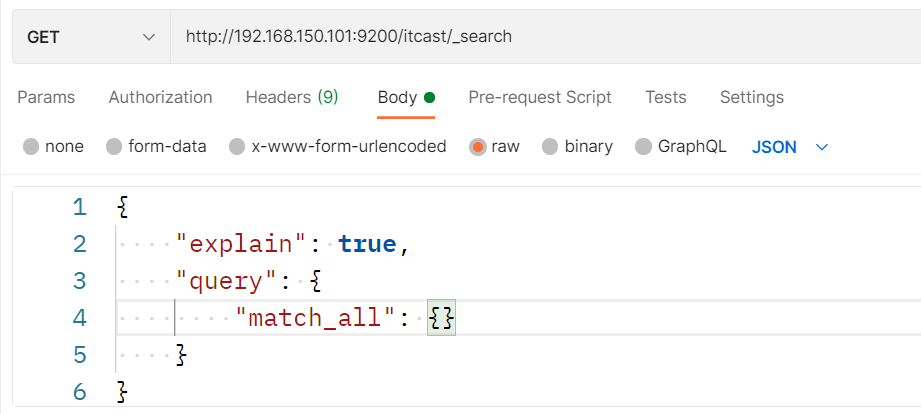

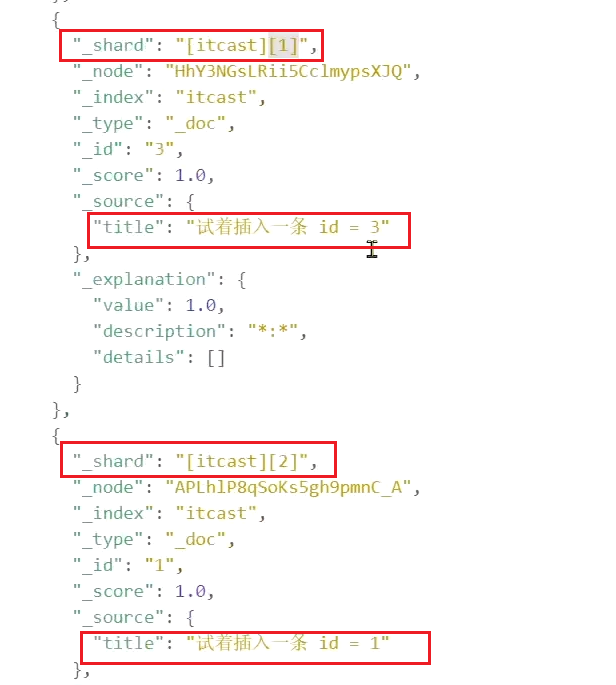

测试可以看到,三条数据分别在不同分片:

结果:

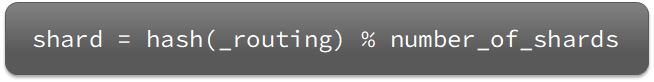

elasticsearch会通过hash算法来计算文档应该存储到哪个分片:

说明:

新增文档的流程如下:

解读:

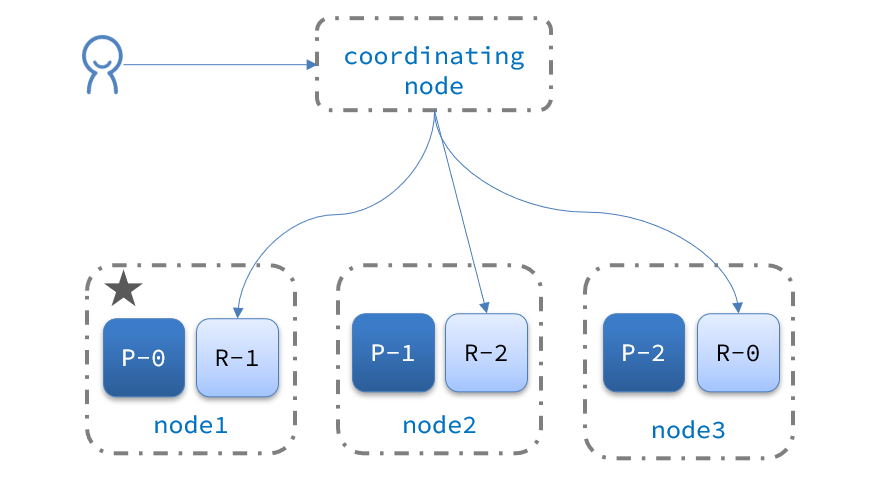

elasticsearch的查询分成两个阶段:

scatter phase:分散阶段,coordinating node会把请求分发到每一个分片

gather phase:聚集阶段,coordinating node汇总data node的搜索结果,并处理为最终结果集返回给用户

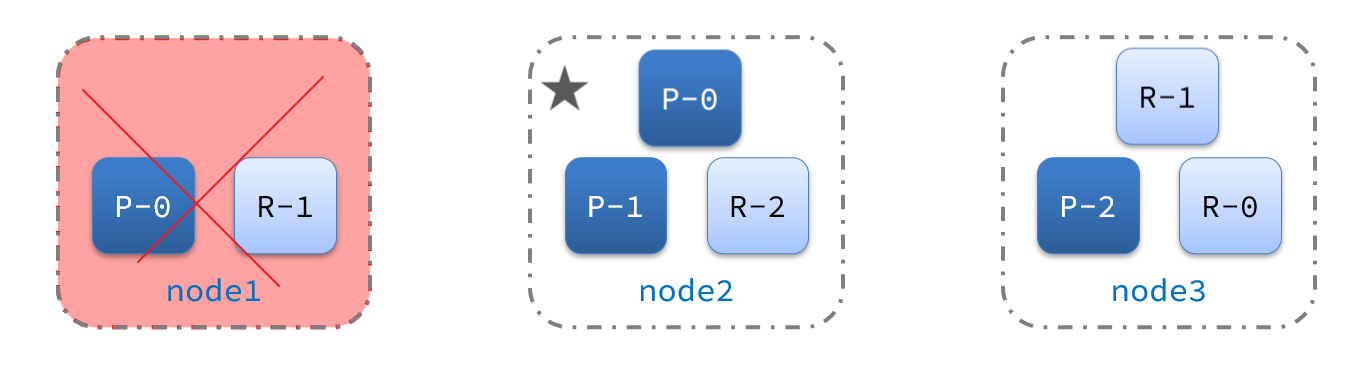

集群的master节点会监控集群中的节点状态,如果发现有节点宕机,会立即将宕机节点的分片数据迁移到其它节点,确保数据安全,这个叫做故障转移。

1)例如一个集群结构如图:

现在,node1是主节点,其它两个节点是从节点。

2)突然,node1发生了故障:

宕机后的第一件事,需要重新选主,例如选中了node2:

node2成为主节点后,会检测集群监控状态,发现:shard-1、shard-0没有副本节点。因此需要将node1上的数据迁移到node2、node3:

在昨天的学习中,我们已经导入了大量数据到elasticsearch中,实现了elasticsearch的数据存储功能。但elasticsearch最擅长的还是搜索和数据分析。

所以今天,我们研究下elasticsearch的数据搜索功能。我们会分别使用DSL和RestClient实现搜索。

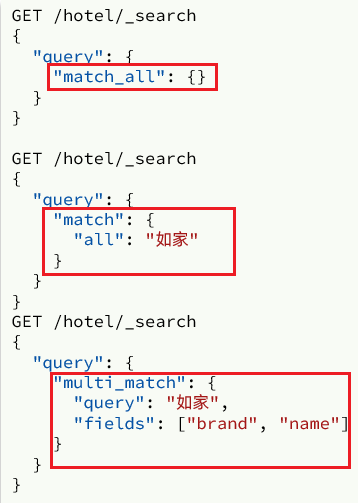

elasticsearch的查询依然是基于JSON风格的DSL来实现的。

Elasticsearch提供了基于JSON的DSL(Domain Specific Language)来定义查询。常见的查询类型包括:

查询所有:查询出所有数据,一般测试用。例如:match_all

全文检索(full text)查询:利用分词器对用户输入内容分词,然后去倒排索引库中匹配。例如:

精确查询:根据精确词条值查找数据,一般是查找keyword、数值、日期、boolean等类型字段。例如:

地理(geo)查询:根据经纬度查询。例如:

复合(compound)查询:复合查询可以将上述各种查询条件组合起来,合并查询条件。例如:

查询的语法基本一致:

1 | GET /indexName/_search |

我们以查询所有为例,其中:

1 | // 查询所有 |

其它查询无非就是查询类型、查询条件的变化。

全文检索查询的基本流程如下:

比较常用的场景包括:

例如京东:

因为是拿着词条去匹配,因此参与搜索的字段也必须是可分词的text类型的字段。

常见的全文检索查询包括:

match查询语法如下:

1 | GET /indexName/_search |

mulit_match语法如下:

1 | GET /indexName/_search |

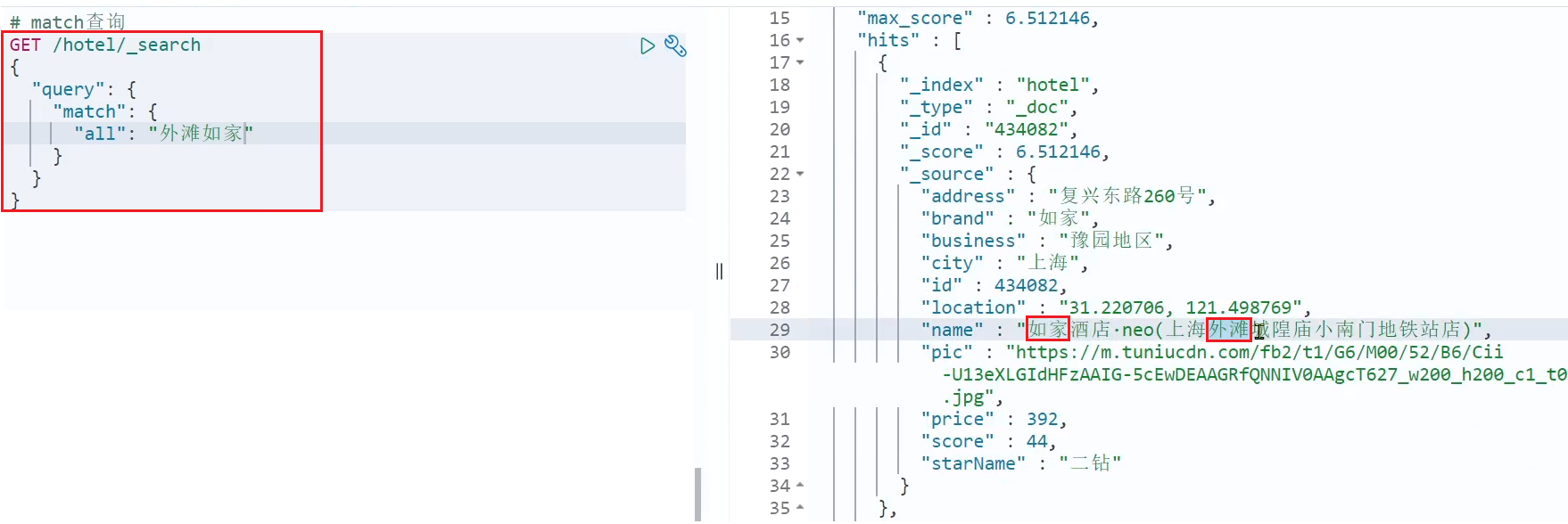

match查询示例:

multi_match查询示例:

可以看到,两种查询结果是一样的,为什么?

因为我们将brand、name、business值都利用copy_to复制到了all字段中。因此你根据三个字段搜索,和根据all字段搜索效果当然一样了。

但是,搜索字段越多,对查询性能影响越大,因此建议采用copy_to,然后单字段查询的方式。

match和multi_match的区别是什么?

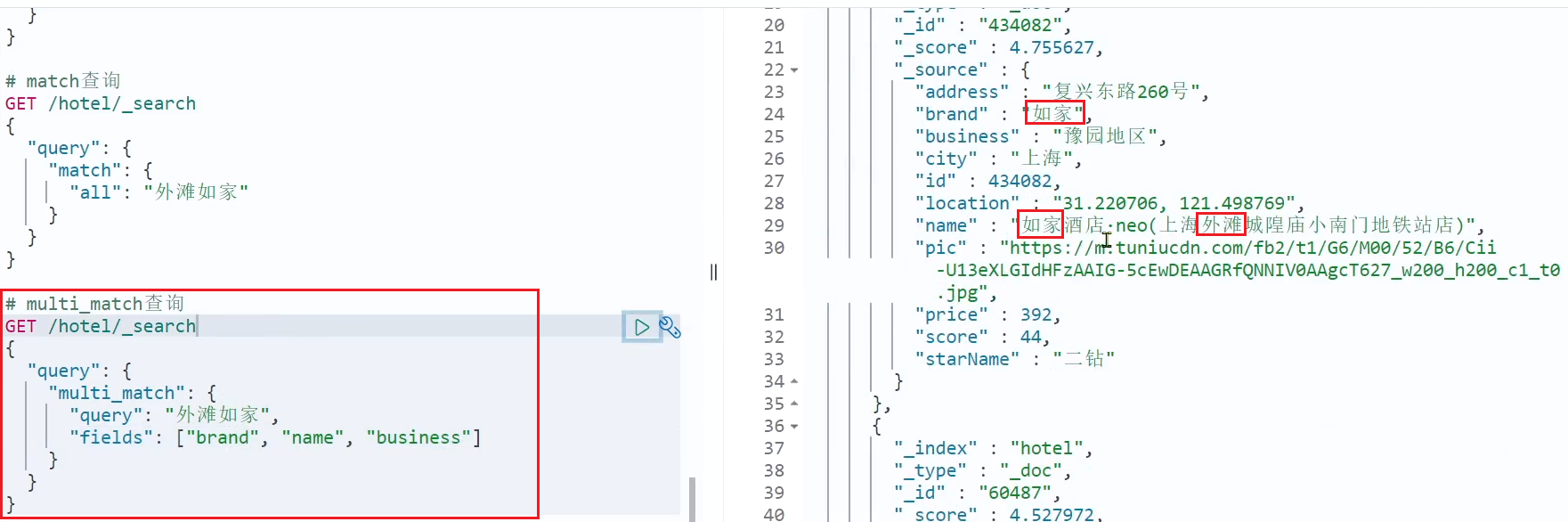

精确查询一般是查找keyword、数值、日期、boolean等类型字段。所以不会对搜索条件分词。常见的有:

因为精确查询的字段搜是不分词的字段,因此查询的条件也必须是不分词的词条。查询时,用户输入的内容跟自动值完全匹配时才认为符合条件。如果用户输入的内容过多,反而搜索不到数据。

语法说明:

1 | // term查询 |

示例:

当我搜索的是精确词条时,能正确查询出结果:

但是,当我搜索的内容不是词条,而是多个词语形成的短语时,反而搜索不到:

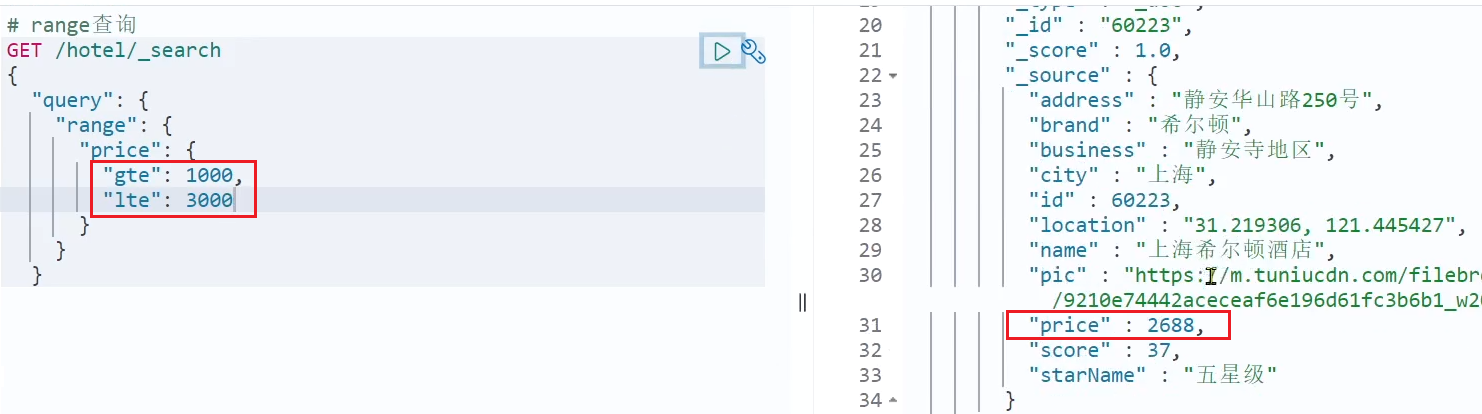

范围查询,一般应用在对数值类型做范围过滤的时候。比如做价格范围过滤。

基本语法:

1 | // range查询 |

示例:

精确查询常见的有哪些?

所谓的地理坐标查询,其实就是根据经纬度查询,官方文档:https://www.elastic.co/guide/en/elasticsearch/reference/current/geo-queries.html

常见的使用场景包括:

附近的酒店:

附近的车:

矩形范围查询,也就是geo_bounding_box查询,查询坐标落在某个矩形范围的所有文档:

查询时,需要指定矩形的左上、右下两个点的坐标,然后画出一个矩形,落在该矩形内的都是符合条件的点。

语法如下:

1 | // geo_bounding_box查询 |

这种并不符合“附近的人”这样的需求,所以我们就不做了。

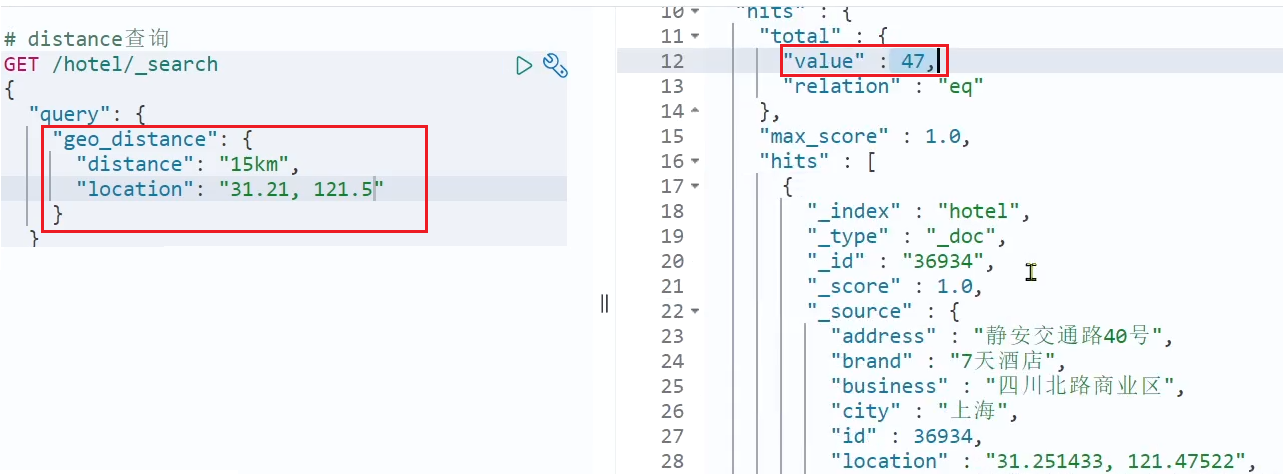

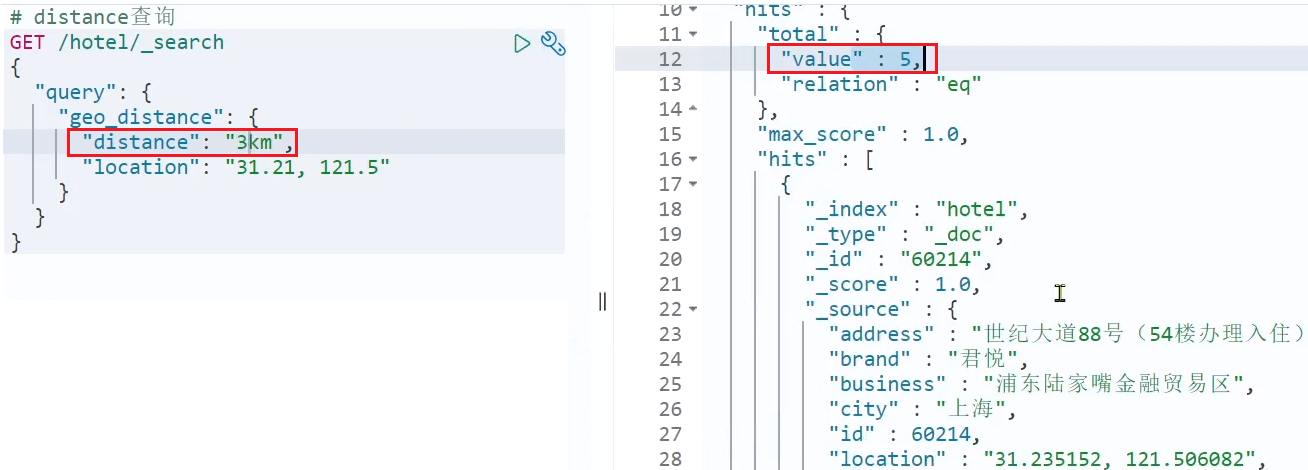

附近查询,也叫做距离查询(geo_distance):查询到指定中心点小于某个距离值的所有文档。

换句话来说,在地图上找一个点作为圆心,以指定距离为半径,画一个圆,落在圆内的坐标都算符合条件:

语法说明:

1 | // geo_distance 查询 |

示例:

我们先搜索陆家嘴附近15km的酒店:

发现共有47家酒店。

然后把半径缩短到3公里:

可以发现,搜索到的酒店数量减少到了5家。

复合(compound)查询:复合查询可以将其它简单查询组合起来,实现更复杂的搜索逻辑。常见的有两种:

当我们利用match查询时,文档结果会根据与搜索词条的关联度打分(_score),返回结果时按照分值降序排列。

例如,我们搜索 “虹桥如家”,结果如下:

1 | [ |

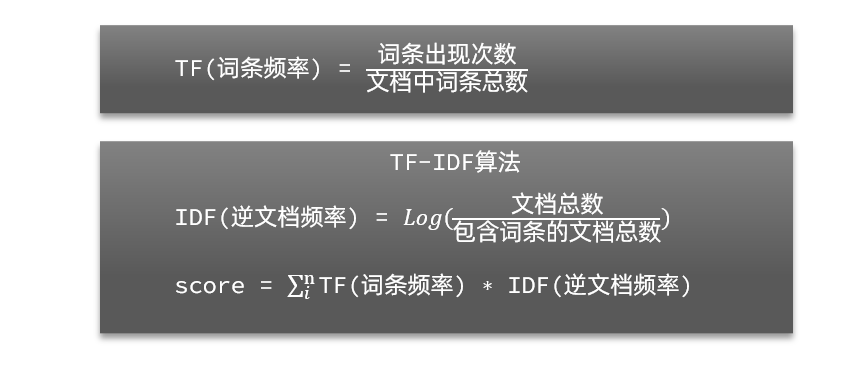

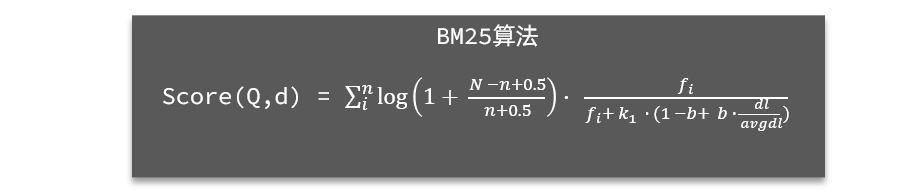

在elasticsearch中,早期使用的打分算法是TF-IDF算法,公式如下:

在后来的5.1版本升级中,elasticsearch将算法改进为BM25算法,公式如下:

TF-IDF算法有一各缺陷,就是词条频率越高,文档得分也会越高,单个词条对文档影响较大。而BM25则会让单个词条的算分有一个上限,曲线更加平滑:

小结:elasticsearch会根据词条和文档的相关度做打分,算法由两种:

根据相关度打分是比较合理的需求,但合理的不一定是产品经理需要的。

以百度为例,你搜索的结果中,并不是相关度越高排名越靠前,而是谁掏的钱多排名就越靠前。如图:

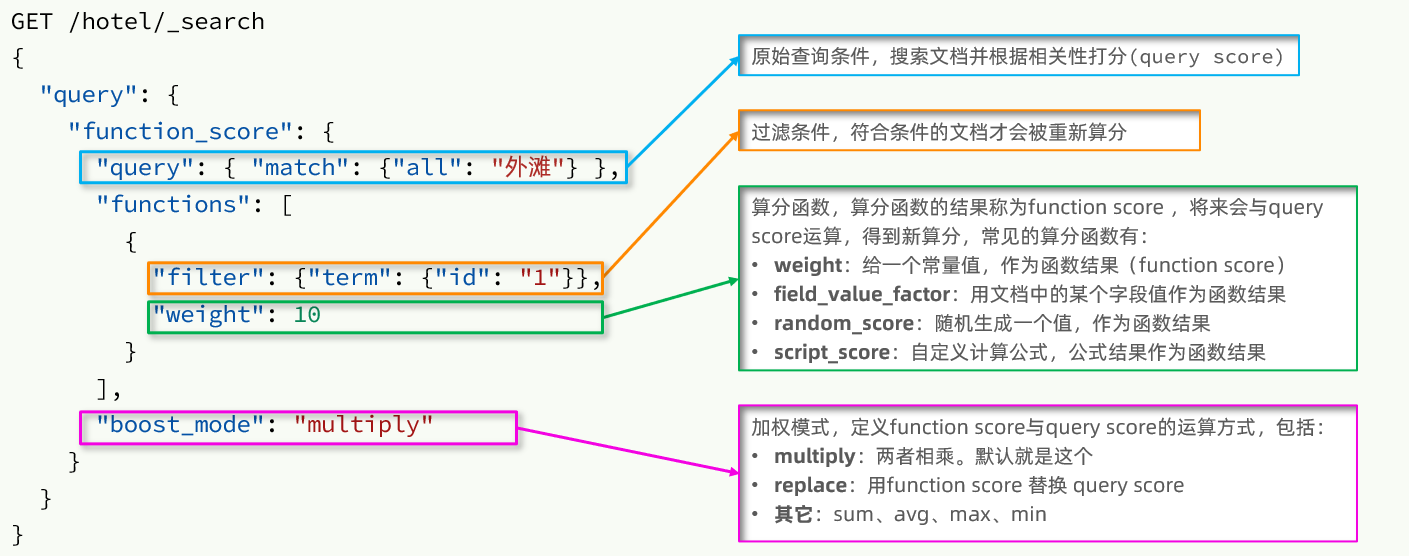

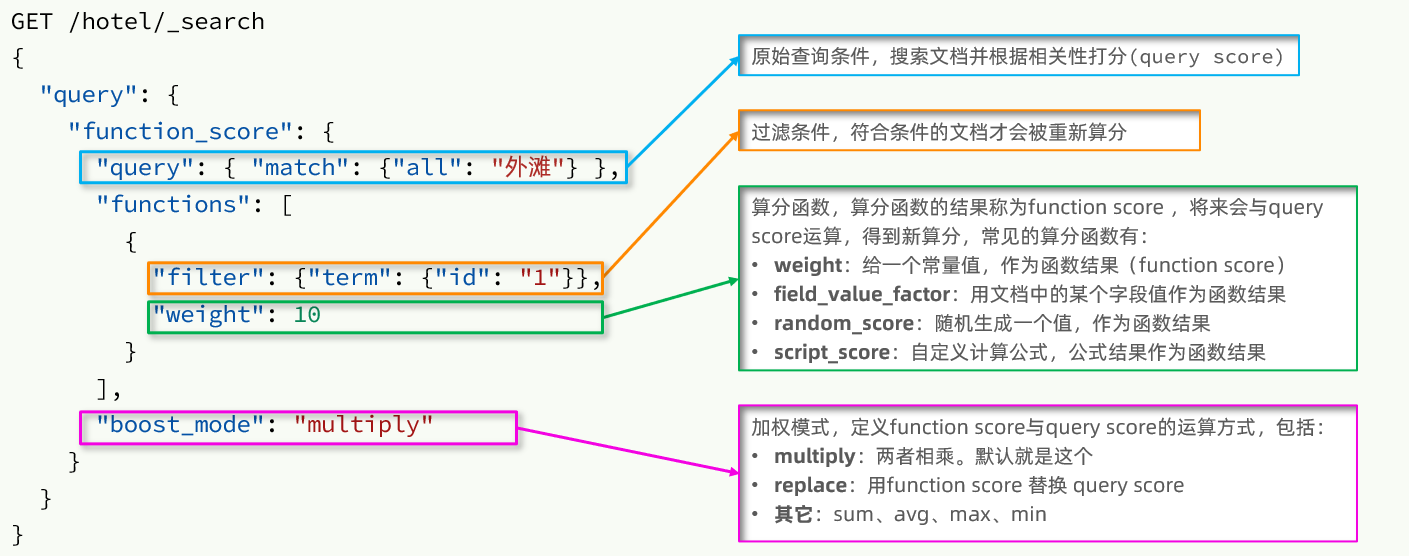

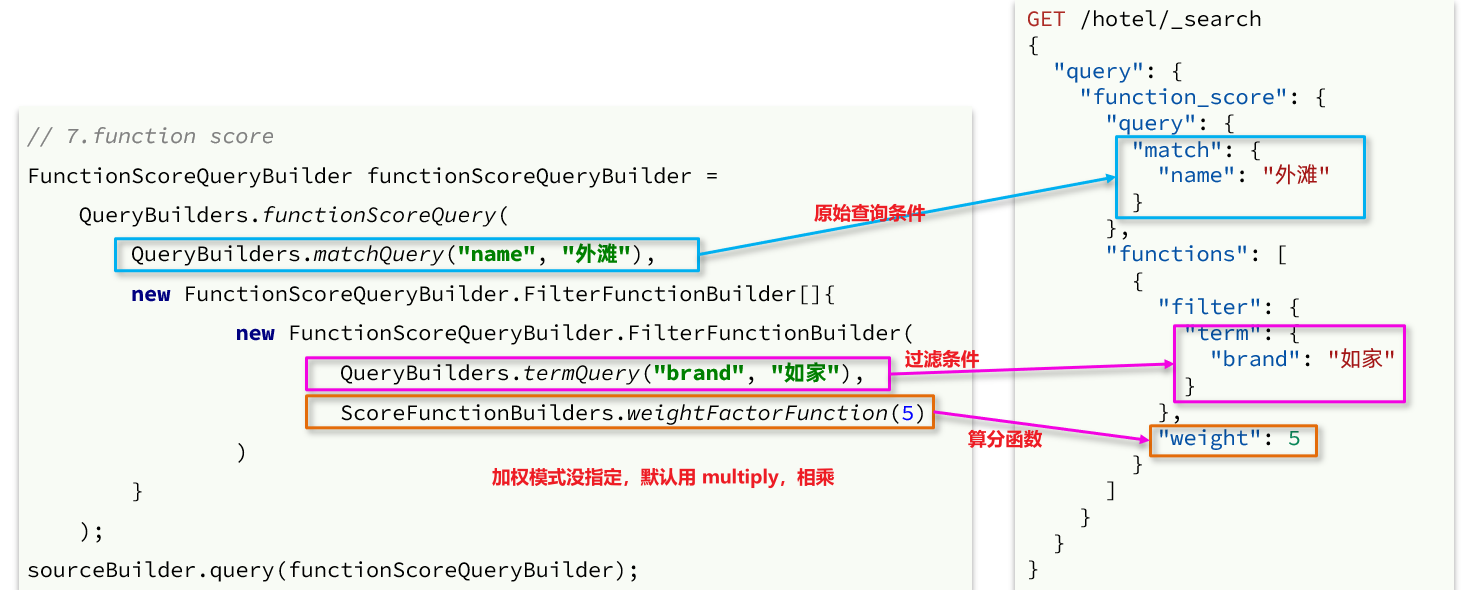

要想认为控制相关性算分,就需要利用elasticsearch中的function score 查询了。

function score 查询中包含四部分内容:

function score的运行流程如下:

因此,其中的关键点是:

需求:给“如家”这个品牌的酒店排名靠前一些

翻译一下这个需求,转换为之前说的四个要点:

因此最终的DSL语句如下:

1 | GET /hotel/_search |

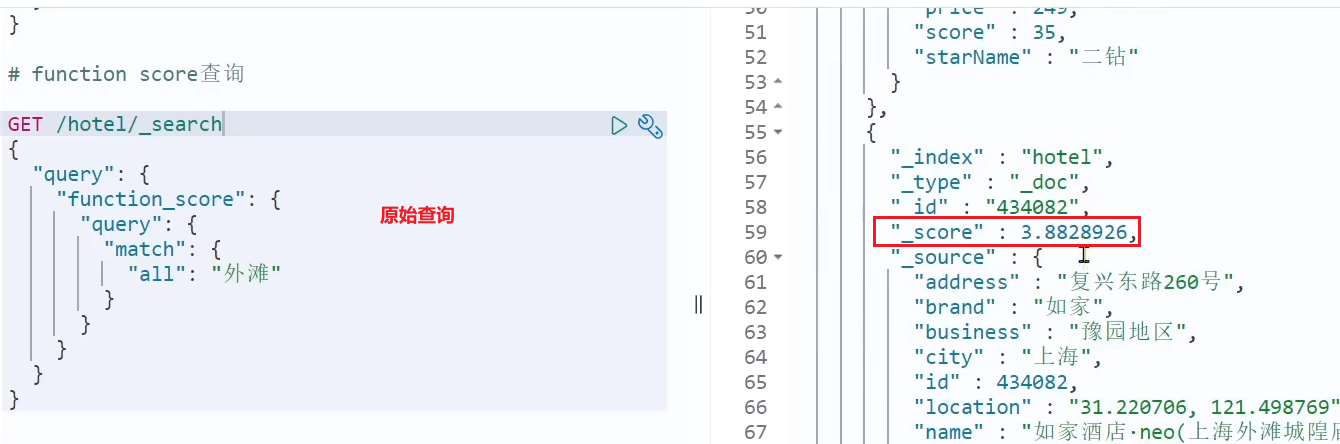

测试,在未添加算分函数时,如家得分如下:

添加了算分函数后,如家得分就提升了:

function score query定义的三要素是什么?

布尔查询是一个或多个查询子句的组合,每一个子句就是一个子查询。子查询的组合方式有:

比如在搜索酒店时,除了关键字搜索外,我们还可能根据品牌、价格、城市等字段做过滤:

每一个不同的字段,其查询的条件、方式都不一样,必须是多个不同的查询,而要组合这些查询,就必须用bool查询了。

需要注意的是,搜索时,参与**打分的字段越多,查询的性能也越差**。因此这种多条件查询时,建议这样做:

1 | GET /hotel/_search |

需求:搜索名字包含“如家”,价格不高于400,在坐标31.21,121.5周围10km范围内的酒店。

分析:

bool查询有几种逻辑关系?

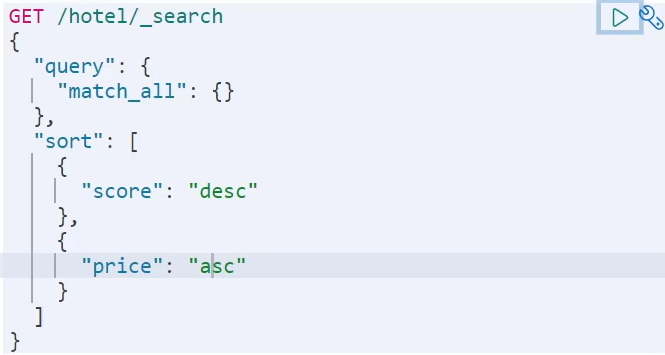

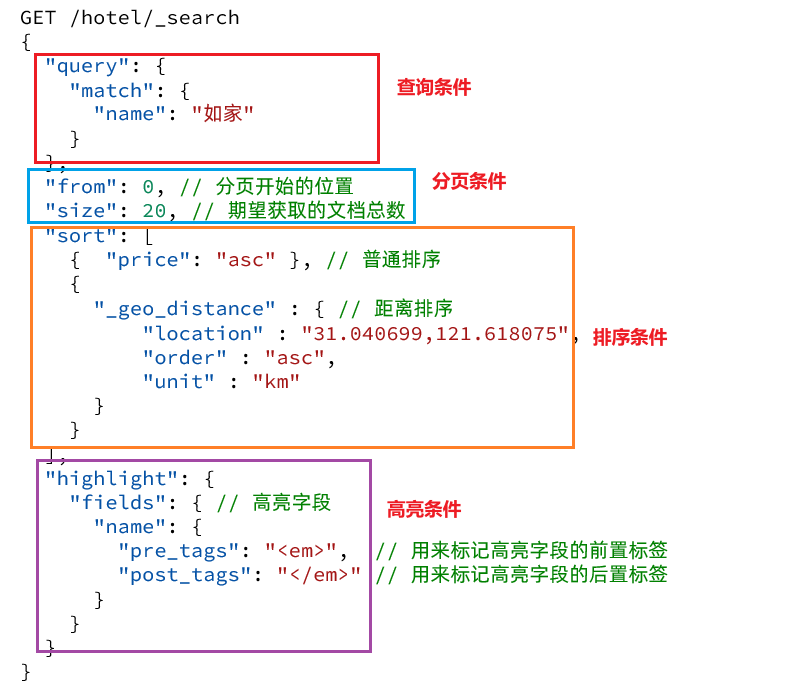

搜索的结果可以按照用户指定的方式去处理或展示。

elasticsearch默认是根据相关度算分(_score)来排序,但是也支持自定义方式对搜索结果排序。可以排序字段类型有:keyword类型、数值类型、地理坐标类型、日期类型等。

keyword、数值、日期类型排序的语法基本一致。

语法:

1 | GET /indexName/_search |

排序条件是一个数组,也就是可以写多个排序条件。按照声明的顺序,当第一个条件相等时,再按照第二个条件排序,以此类推

示例:

需求描述:酒店数据按照用户评价(score)降序排序,评价相同的按照价格(price)升序排序

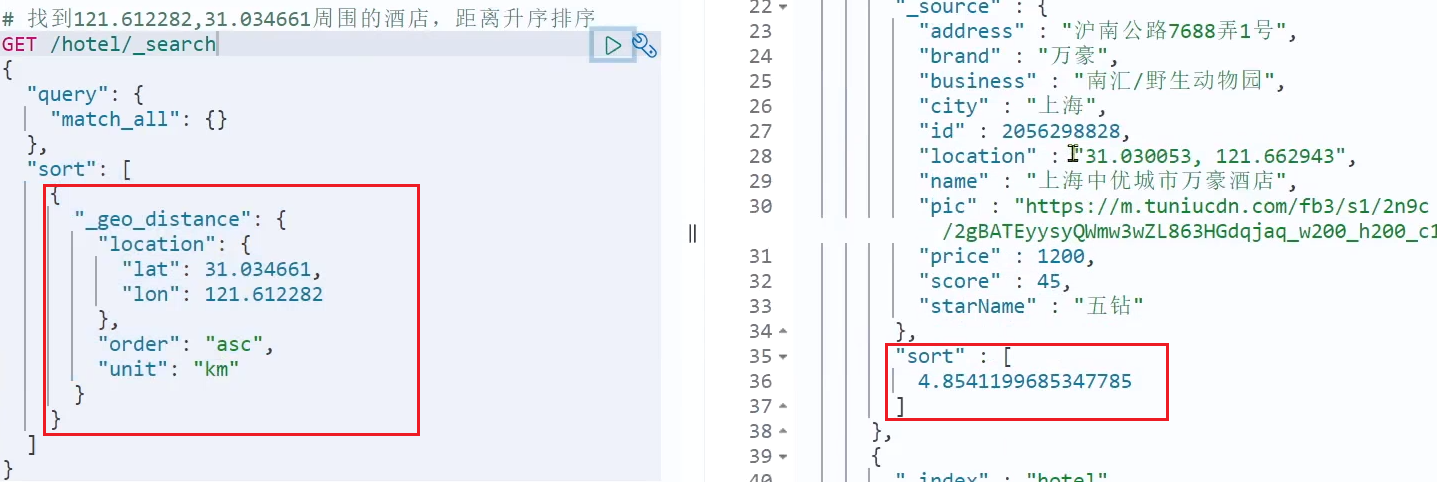

地理坐标排序略有不同。

语法说明:

1 | GET /indexName/_search |

这个查询的含义是:

示例:

需求描述:实现对酒店数据按照到你的位置坐标的距离升序排序

提示:获取你的位置的经纬度的方式:https://lbs.amap.com/demo/jsapi-v2/example/map/click-to-get-lnglat/

假设我的位置是:31.034661,121.612282,寻找我周围距离最近的酒店。

elasticsearch 默认情况下只返回top10的数据。而如果要查询更多数据就需要修改分页参数了。elasticsearch中通过修改from、size参数来控制要返回的分页结果:

类似于mysql中的limit ?, ?

分页的基本语法如下:

1 | GET /hotel/_search |

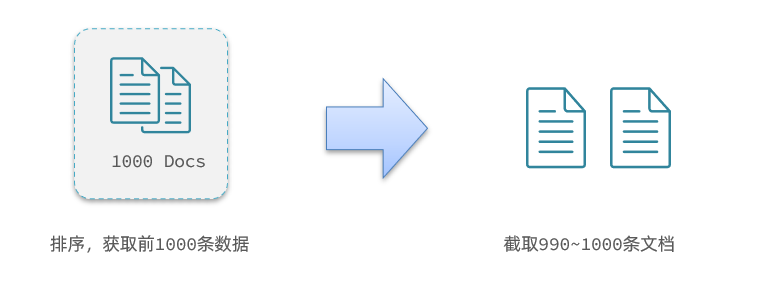

现在,我要查询990~1000的数据,查询逻辑要这么写:

1 | GET /hotel/_search |

这里是查询990开始的数据,也就是 第990~第1000条 数据。

不过,elasticsearch内部分页时,必须先查询 0~1000条,然后截取其中的990 ~ 1000的这10条:

查询TOP1000,如果es是单点模式,这并无太大影响。

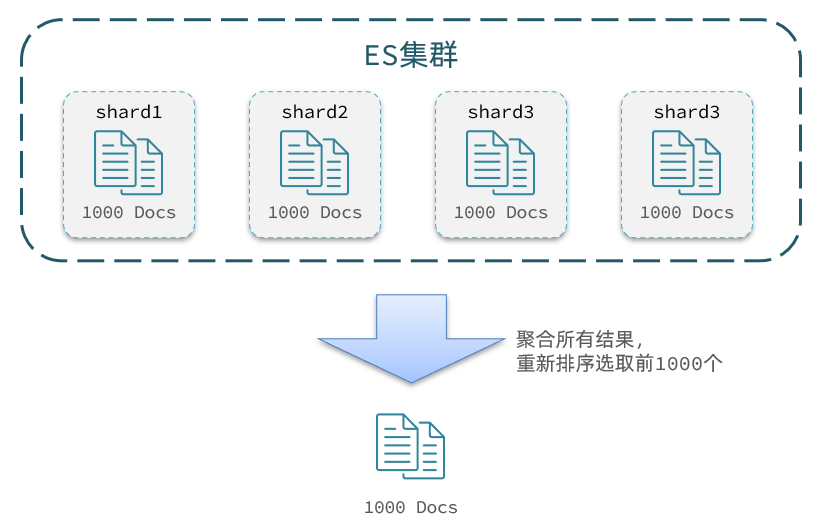

但是elasticsearch将来一定是集群,例如我集群有5个节点,我要查询TOP1000的数据,并不是每个节点查询200条就可以了。

因为节点A的TOP200,在另一个节点可能排到10000名以外了。

因此要想获取整个集群的TOP1000,必须先查询出每个节点的TOP1000,汇总结果后,重新排名,重新截取TOP1000。

那如果我要查询9900~10000的数据呢?是不是要先查询TOP10000呢?那每个节点都要查询10000条?汇总到内存中?

当查询分页深度较大时,汇总数据过多,对内存和CPU会产生非常大的压力,因此elasticsearch会禁止from+ size 超过10000的请求。

针对深度分页,ES提供了两种解决方案,官方文档:

分页查询的常见实现方案以及优缺点:

from + size:

after search:

scroll:

什么是高亮显示呢?

我们在百度,京东搜索时,关键字会变成红色,比较醒目,这叫高亮显示:

高亮显示的实现分为两步:

<em>标签<em>标签编写CSS样式高亮的语法:

1 | GET /hotel/_search |

注意:

示例:

查询的DSL是一个大的JSON对象,包含下列属性:

示例:

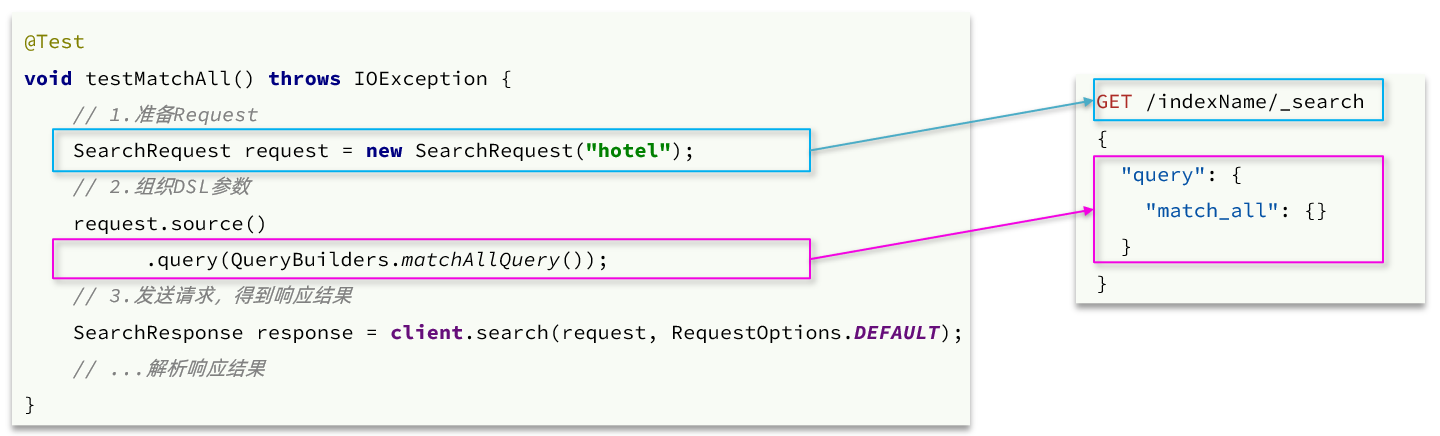

文档的查询同样适用前面学习的 RestHighLevelClient对象,基本步骤包括:

我们以match_all查询为例

代码解读:

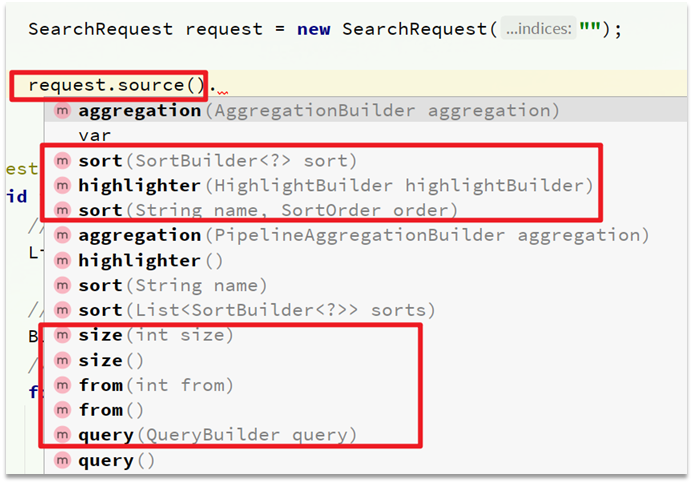

第一步,创建SearchRequest对象,指定索引库名

第二步,利用request.source()构建DSL,DSL中可以包含查询、分页、排序、高亮等

query():代表查询条件,利用QueryBuilders.matchAllQuery()构建一个match_all查询的DSL第三步,利用client.search()发送请求,得到响应

这里关键的API有两个,一个是request.source(),其中包含了查询、排序、分页、高亮等所有功能:

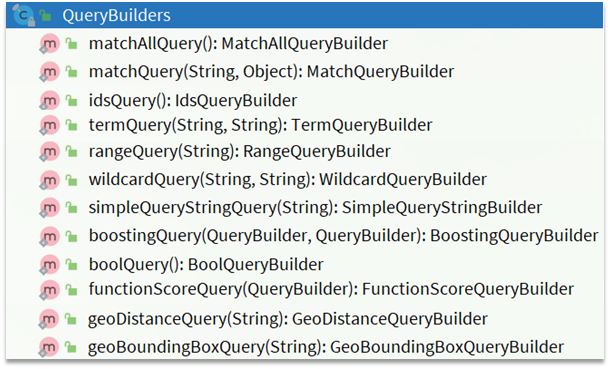

另一个是QueryBuilders,其中包含match、term、function_score、bool等各种查询:

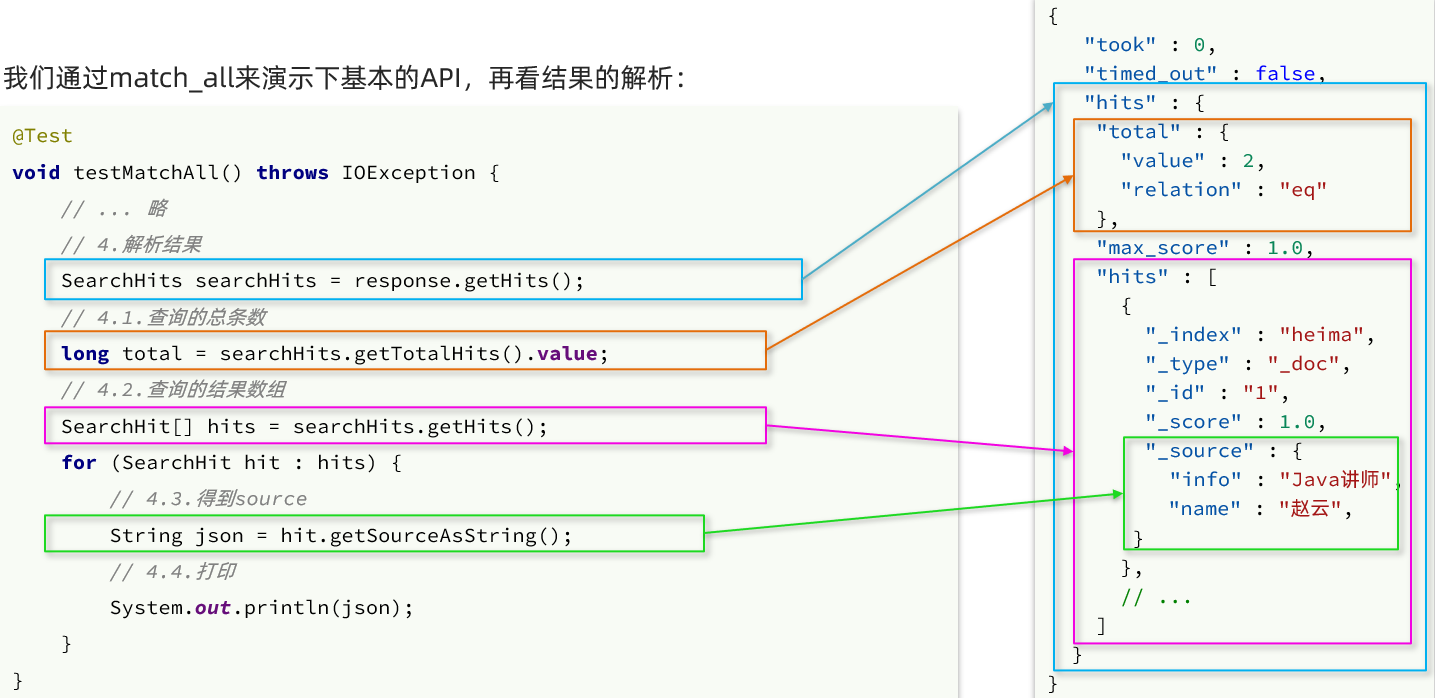

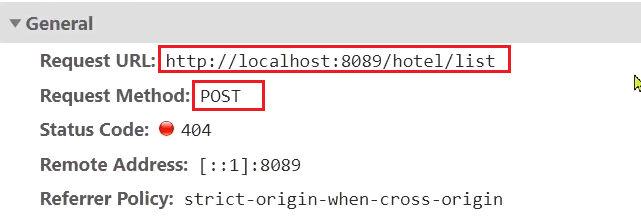

响应结果的解析:

elasticsearch返回的结果是一个JSON字符串,结构包含:

hits:命中的结果

total:总条数,其中的value是具体的总条数值max_score:所有结果中得分最高的文档的相关性算分hits:搜索结果的文档数组,其中的每个文档都是一个json对象

_source:文档中的原始数据,也是json对象因此,我们解析响应结果,就是逐层解析JSON字符串,流程如下:

SearchHits:通过response.getHits()获取,就是JSON中的最外层的hits,代表命中的结果

SearchHits#getTotalHits().value:获取总条数信息SearchHits#getHits():获取SearchHit数组,也就是文档数组

SearchHit#getSourceAsString():获取文档结果中的_source,也就是原始的json文档数据完整代码如下:

1 |

|

查询的基本步骤是:

创建SearchRequest对象

准备Request.source(),也就是DSL。

① QueryBuilders来构建查询条件

② 传入Request.source() 的 query() 方法

发送请求,得到结果

解析结果(参考JSON结果,从外到内,逐层解析)

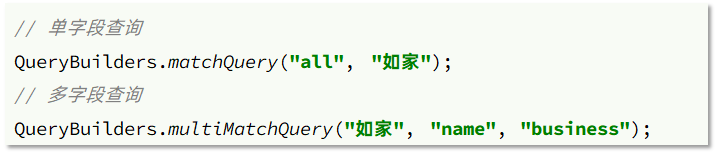

全文检索的match和multi_match查询与match_all的API基本一致。差别是查询条件,也就是query的部分。

因此,Java代码上的差异主要是request.source().query()中的参数了。同样是利用QueryBuilders提供的方法:

而结果解析代码则完全一致,可以抽取并共享。

完整代码如下:

1 |

|

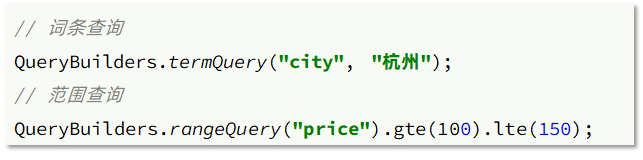

精确查询主要是两者:

与之前的查询相比,差异同样在查询条件,其它都一样。

查询条件构造的API如下:

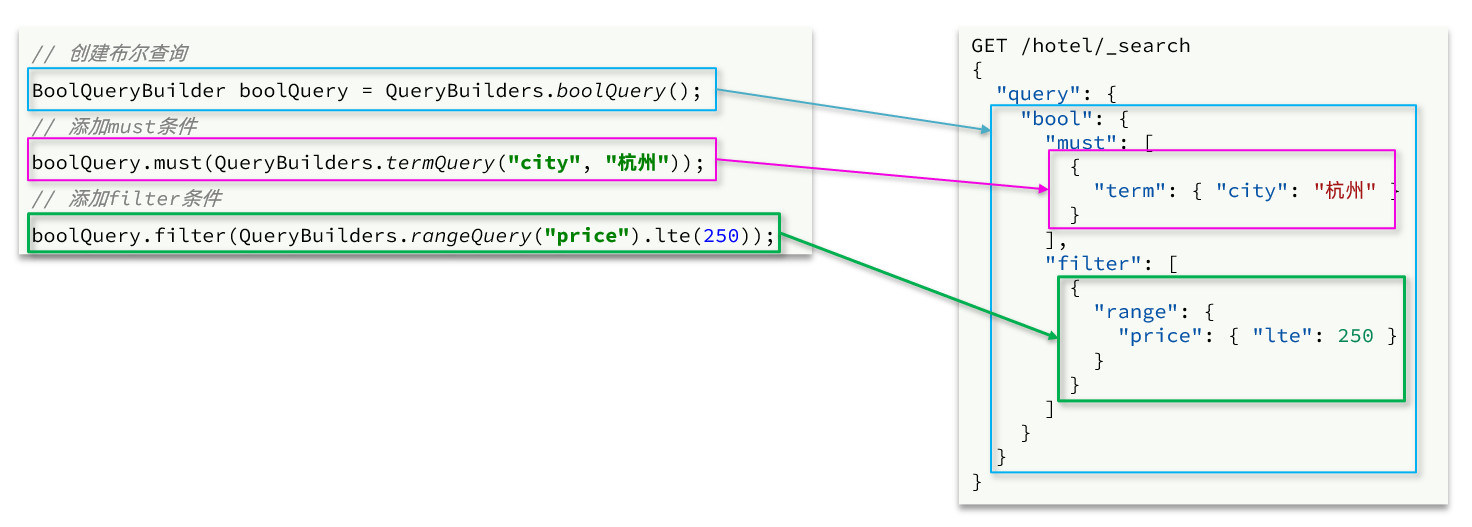

布尔查询是用must、must_not、filter等方式组合其它查询,代码示例如下:

可以看到,API与其它查询的差别同样是在查询条件的构建,QueryBuilders,结果解析等其他代码完全不变。

完整代码如下:

1 |

|

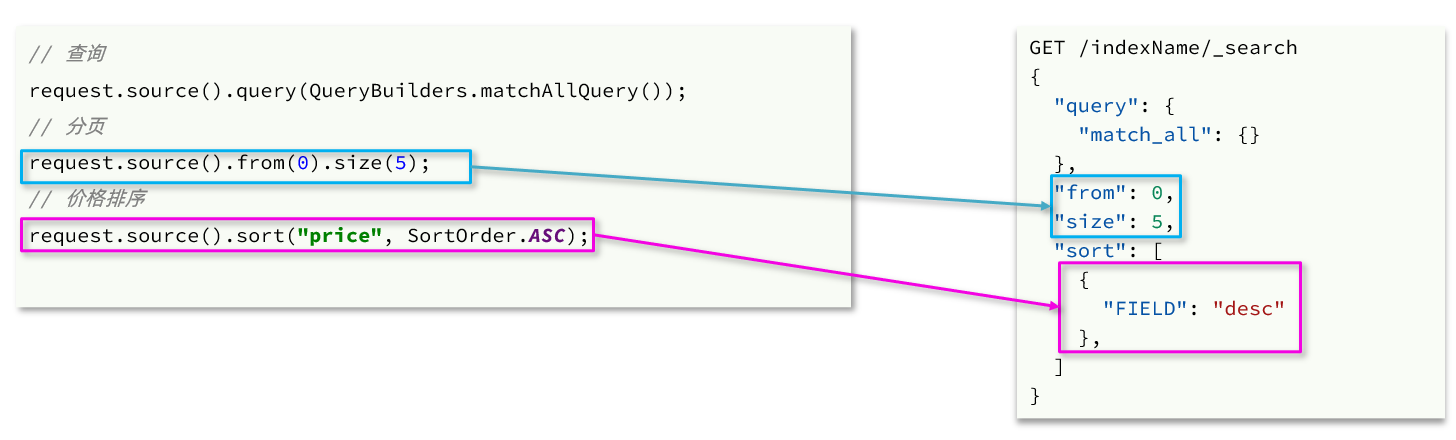

搜索结果的排序和分页是与query同级的参数,因此同样是使用request.source()来设置。

对应的API如下:

完整代码示例:

1 |

|

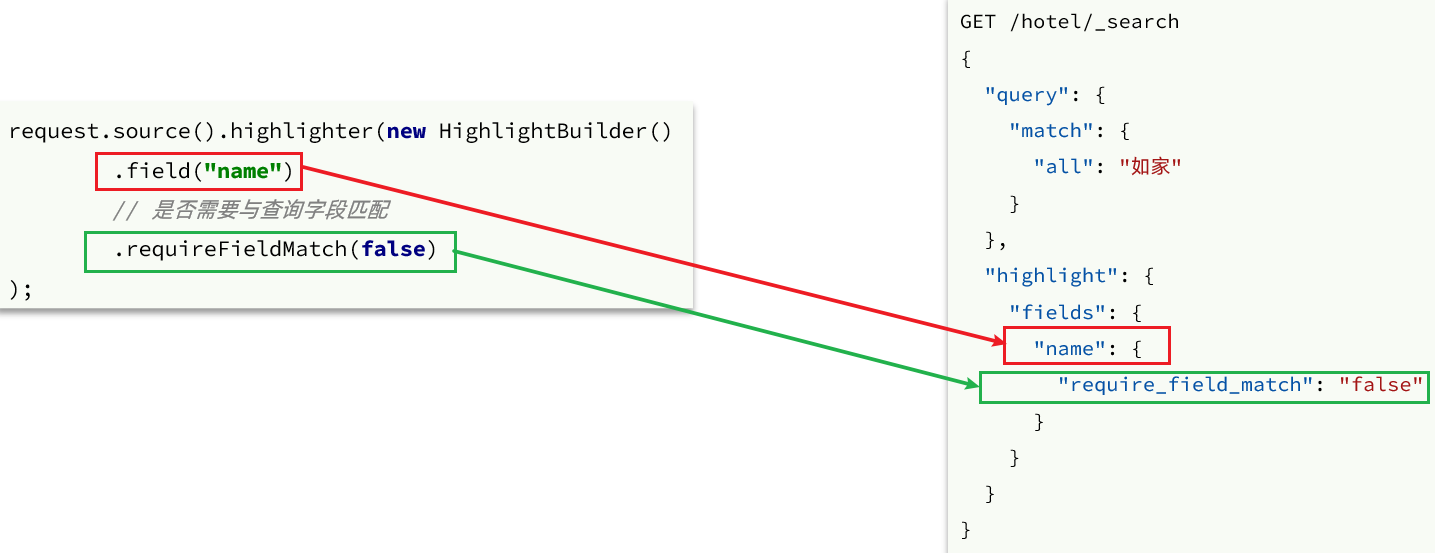

高亮的代码与之前代码差异较大,有两点:

高亮请求的构建API如下:

上述代码省略了查询条件部分,但是大家不要忘了:高亮查询必须使用全文检索查询,并且要有搜索关键字,将来才可以对关键字高亮。

完整代码如下:

1 |

|

高亮的结果与查询的文档结果默认是分离的,并不在一起。

因此解析高亮的代码需要额外处理:

代码解读:

完整代码如下:

1 | private void handleResponse(SearchResponse response) { |

下面,我们通过黑马旅游的案例来实战演练下之前学习的知识。

我们实现四部分功能:

启动我们提供的hotel-demo项目,其默认端口是8089,访问http://localhost:8090,就能看到项目页面了:

案例需求:实现黑马旅游的酒店搜索功能,完成关键字搜索和分页

在项目的首页,有一个大大的搜索框,还有分页按钮:

点击搜索按钮,可以看到浏览器控制台发出了请求:

请求参数如下:

由此可以知道,我们这个请求的信息如下:

total:总条数List<HotelDoc>:当前页的数据因此,我们实现业务的流程如下:

实体类有两个,一个是前端的请求参数实体,一个是服务端应该返回的响应结果实体。

1)请求参数

前端请求的json结构如下:

1 | { |

因此,我们在cn.itcast.hotel.pojo包下定义一个实体类:

1 | package cn.itcast.hotel.pojo; |

2)返回值

分页查询,需要返回分页结果PageResult,包含两个属性:

total:总条数List<HotelDoc>:当前页的数据因此,我们在cn.itcast.hotel.pojo中定义返回结果:

1 | package cn.itcast.hotel.pojo; |

定义一个HotelController,声明查询接口,满足下列要求:

Long total:总条数List<HotelDoc> hotels:酒店数据因此,我们在cn.itcast.hotel.web中定义HotelController:

1 |

|

我们在controller调用了IHotelService,并没有实现该方法,因此下面我们就在IHotelService中定义方法,并且去实现业务逻辑。

1)在cn.itcast.hotel.service中的IHotelService接口中定义一个方法:

1 | /** |

2)实现搜索业务,肯定离不开RestHighLevelClient,我们需要把它注册到Spring中作为一个Bean。在cn.itcast.hotel中的HotelDemoApplication中声明这个Bean:

1 |

|

3)在cn.itcast.hotel.service.impl中的HotelService中实现search方法:

1 |

|

需求:添加品牌、城市、星级、价格等过滤功能

在页面搜索框下面,会有一些过滤项:

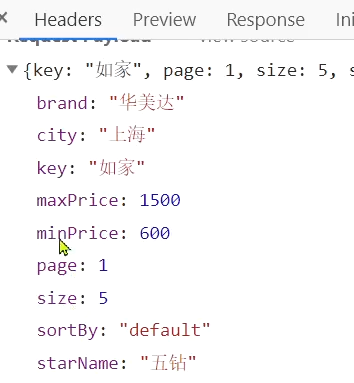

传递的参数如图:

包含的过滤条件有:

我们需要做两件事情:

修改在cn.itcast.hotel.pojo包下的实体类RequestParams:

1 |

|

在HotelService的search方法中,只有一个地方需要修改:requet.source().query( … )其中的查询条件。

在之前的业务中,只有match查询,根据关键字搜索,现在要添加条件过滤,包括:

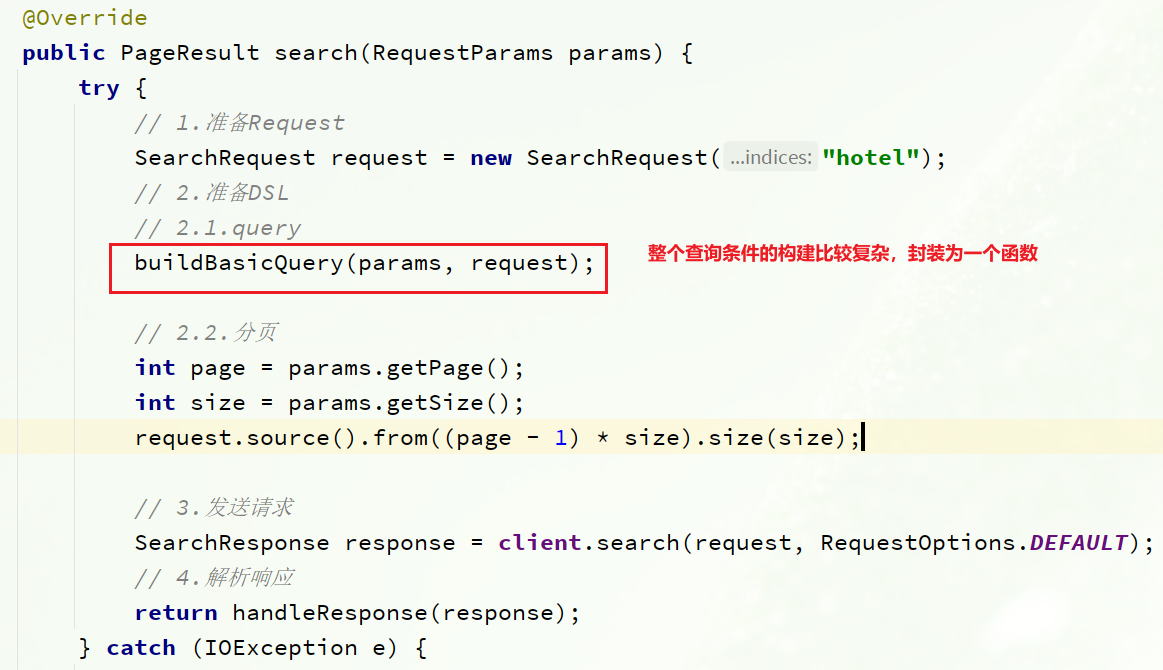

多个查询条件组合,肯定是boolean查询来组合:

因为条件构建的逻辑比较复杂,这里先封装为一个函数:

buildBasicQuery的代码如下:

1 | private void buildBasicQuery(RequestParams params, SearchRequest request) { |

需求:我附近的酒店

在酒店列表页的右侧,有一个小地图,点击地图的定位按钮,地图会找到你所在的位置:

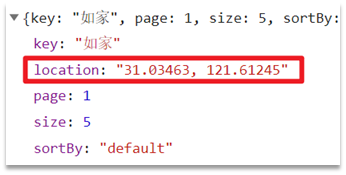

并且,在前端会发起查询请求,将你的坐标发送到服务端:

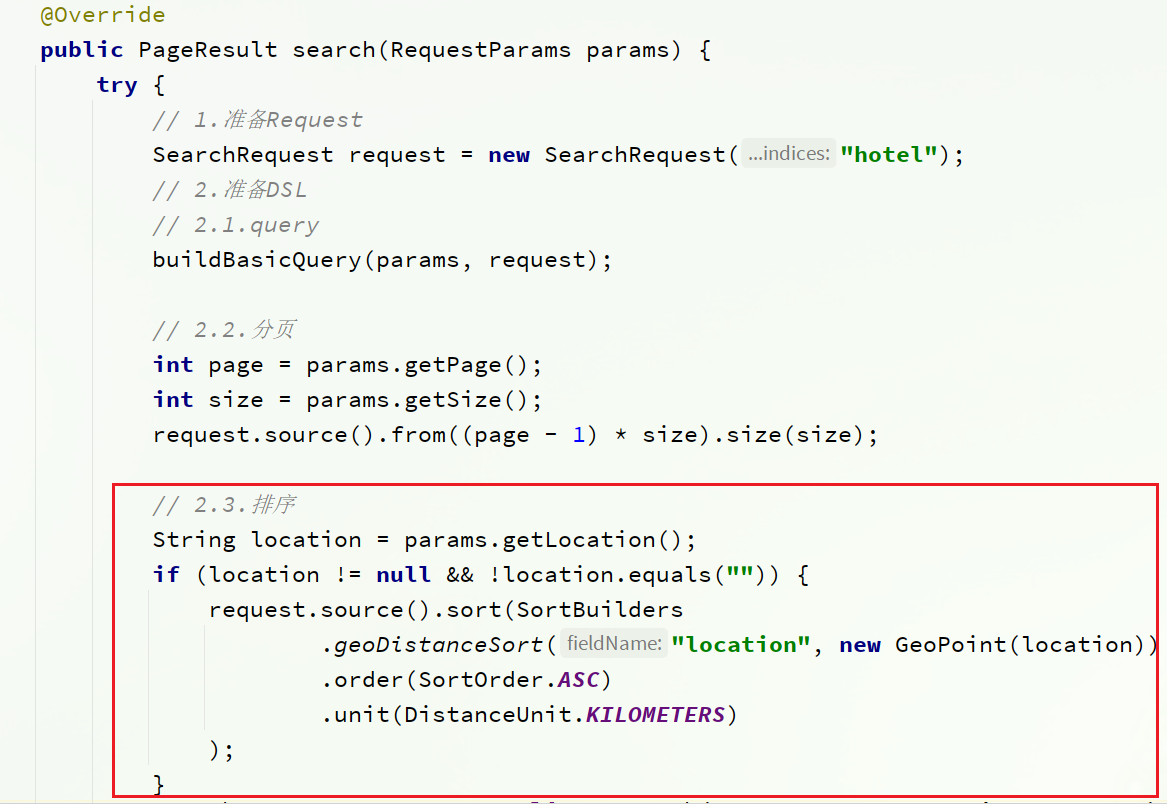

我们要做的事情就是基于这个location坐标,然后按照距离对周围酒店排序。实现思路如下:

修改在cn.itcast.hotel.pojo包下的实体类RequestParams:

1 | package cn.itcast.hotel.pojo; |

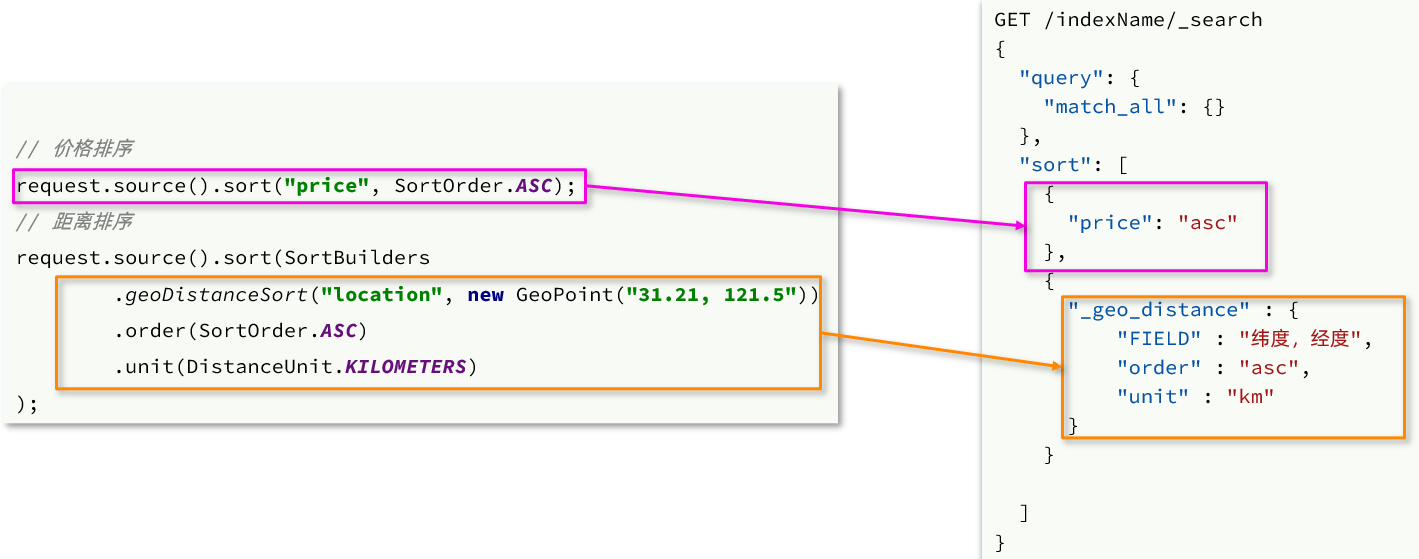

我们以前学习过排序功能,包括两种:

我们只讲了普通字段排序对应的java写法。地理坐标排序只学过DSL语法,如下:

1 | GET /indexName/_search |

对应的java代码示例:

在cn.itcast.hotel.service.impl的HotelService的search方法中,添加一个排序功能:

完整代码:

1 |

|

重启服务后,测试我的酒店功能:

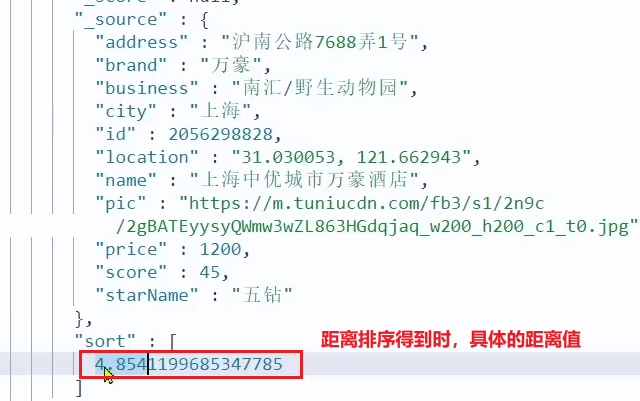

发现确实可以实现对我附近酒店的排序,不过并没有看到酒店到底距离我多远,这该怎么办?

排序完成后,页面还要获取我附近每个酒店的具体距离值,这个值在响应结果中是独立的:

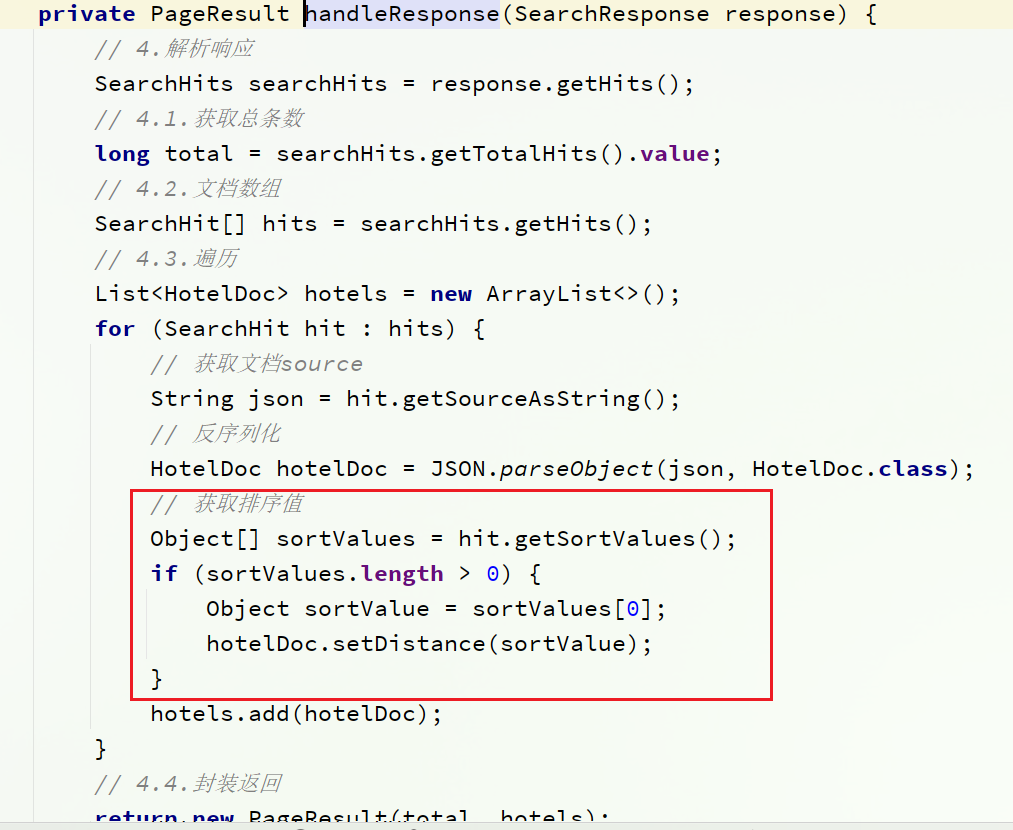

因此,我们在结果解析阶段,除了解析source部分以外,还要得到sort部分,也就是排序的距离,然后放到响应结果中。

我们要做两件事:

1)修改HotelDoc类,添加距离字段

1 | package cn.itcast.hotel.pojo; |

2)修改HotelService中的handleResponse方法

重启后测试,发现页面能成功显示距离了:

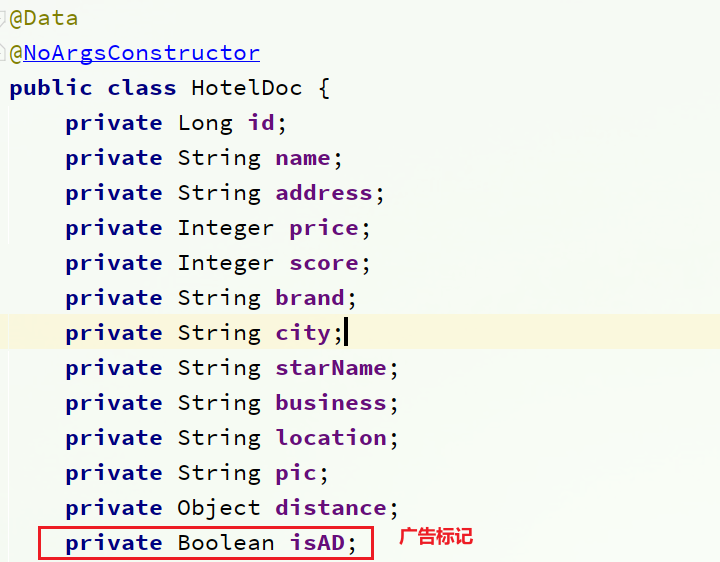

需求:让指定的酒店在搜索结果中排名置顶

要让指定酒店在搜索结果中排名置顶,效果如图:

页面会给指定的酒店添加广告标记。

那怎样才能让指定的酒店排名置顶呢?

我们之前学习过的function_score查询可以影响算分,算分高了,自然排名也就高了。而function_score包含3个要素:

这里的需求是:让指定酒店排名靠前。因此我们需要给这些酒店添加一个标记,这样在过滤条件中就可以根据这个标记来判断,是否要提高算分。

比如,我们给酒店添加一个字段:isAD,Boolean类型:

这样function_score包含3个要素就很好确定了:

因此,业务的实现步骤包括:

给HotelDoc类添加isAD字段,Boolean类型

挑选几个你喜欢的酒店,给它的文档数据添加isAD字段,值为true

修改search方法,添加function score功能,给isAD值为true的酒店增加权重

给cn.itcast.hotel.pojo包下的HotelDoc类添加isAD字段:

接下来,我们挑几个酒店,添加isAD字段,设置为true:

1 | POST /hotel/_update/1902197537 |

接下来我们就要修改查询条件了。之前是用的boolean 查询,现在要改成function_socre查询。

function_score查询结构如下:

对应的JavaAPI如下:

我们可以将之前写的boolean查询作为原始查询条件放到query中,接下来就是添加过滤条件、算分函数、加权模式了。所以原来的代码依然可以沿用。

修改cn.itcast.hotel.service.impl包下的HotelService类中的buildBasicQuery方法,添加算分函数查询:

1 | private void buildBasicQuery(RequestParams params, SearchRequest request) { |

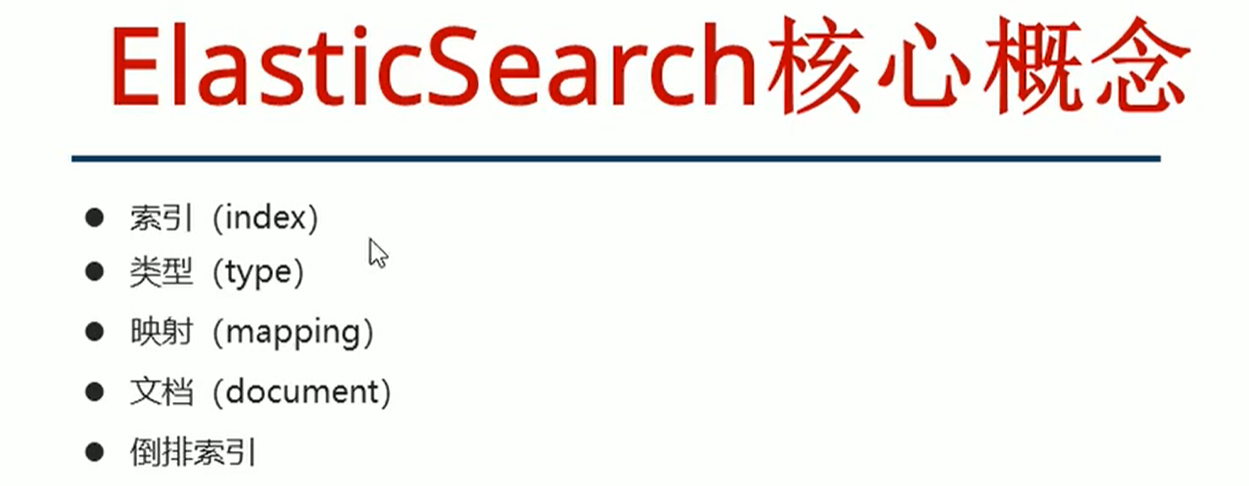

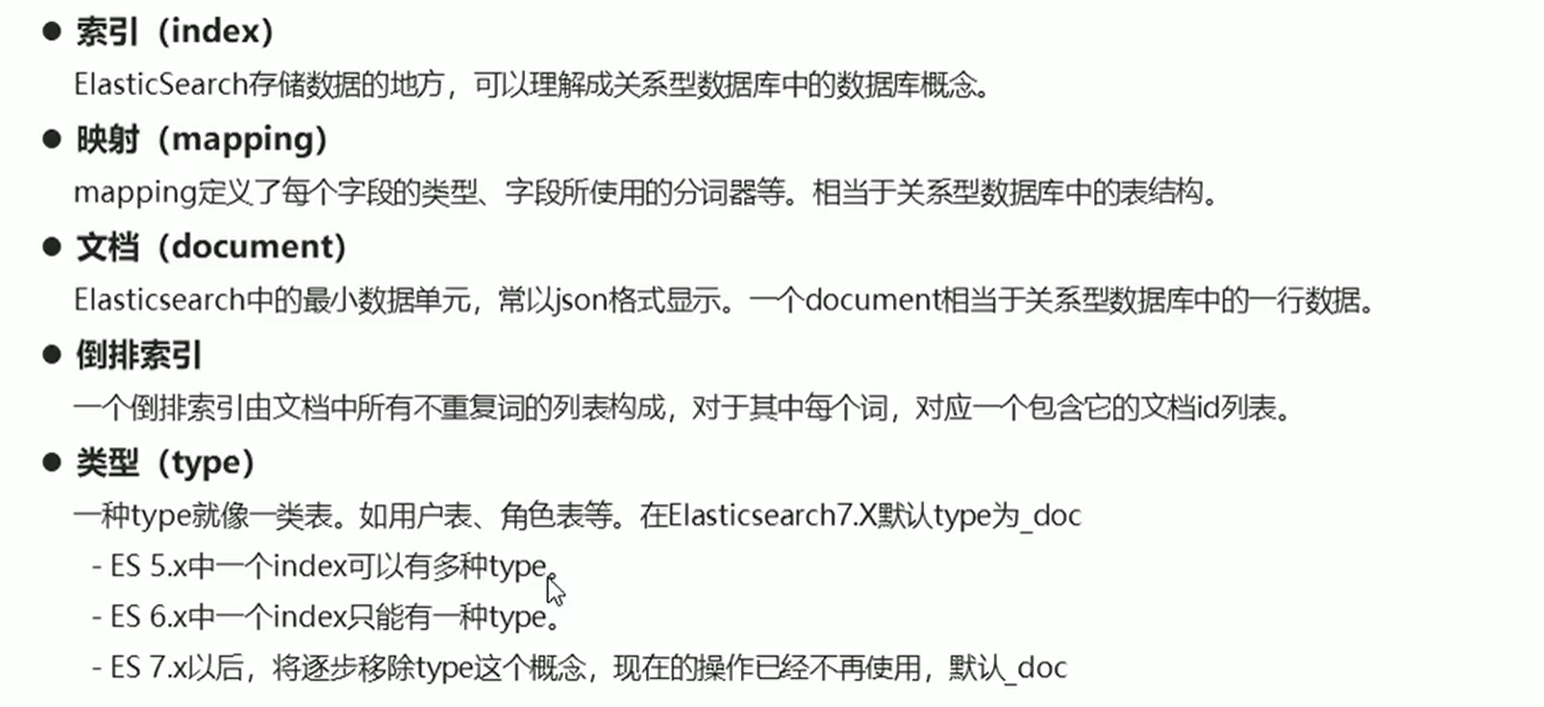

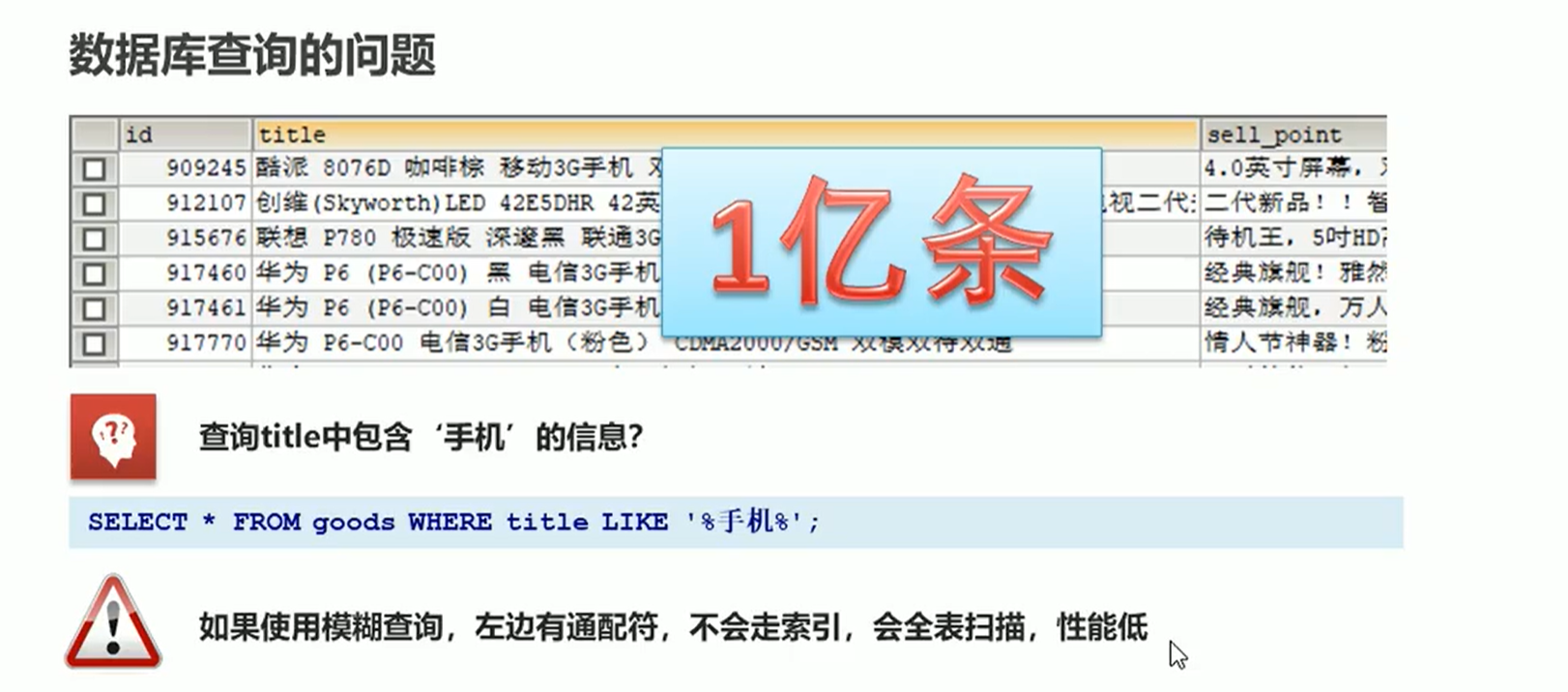

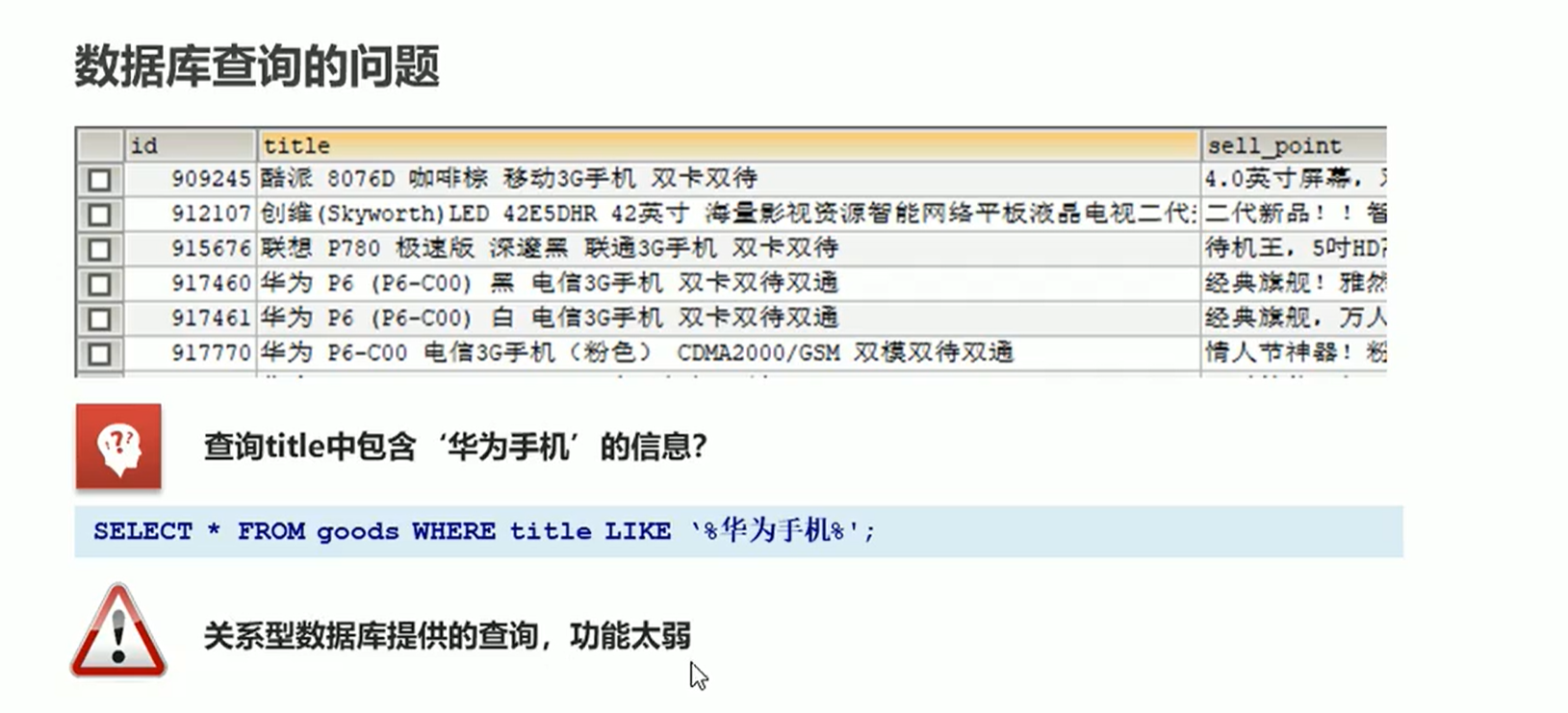

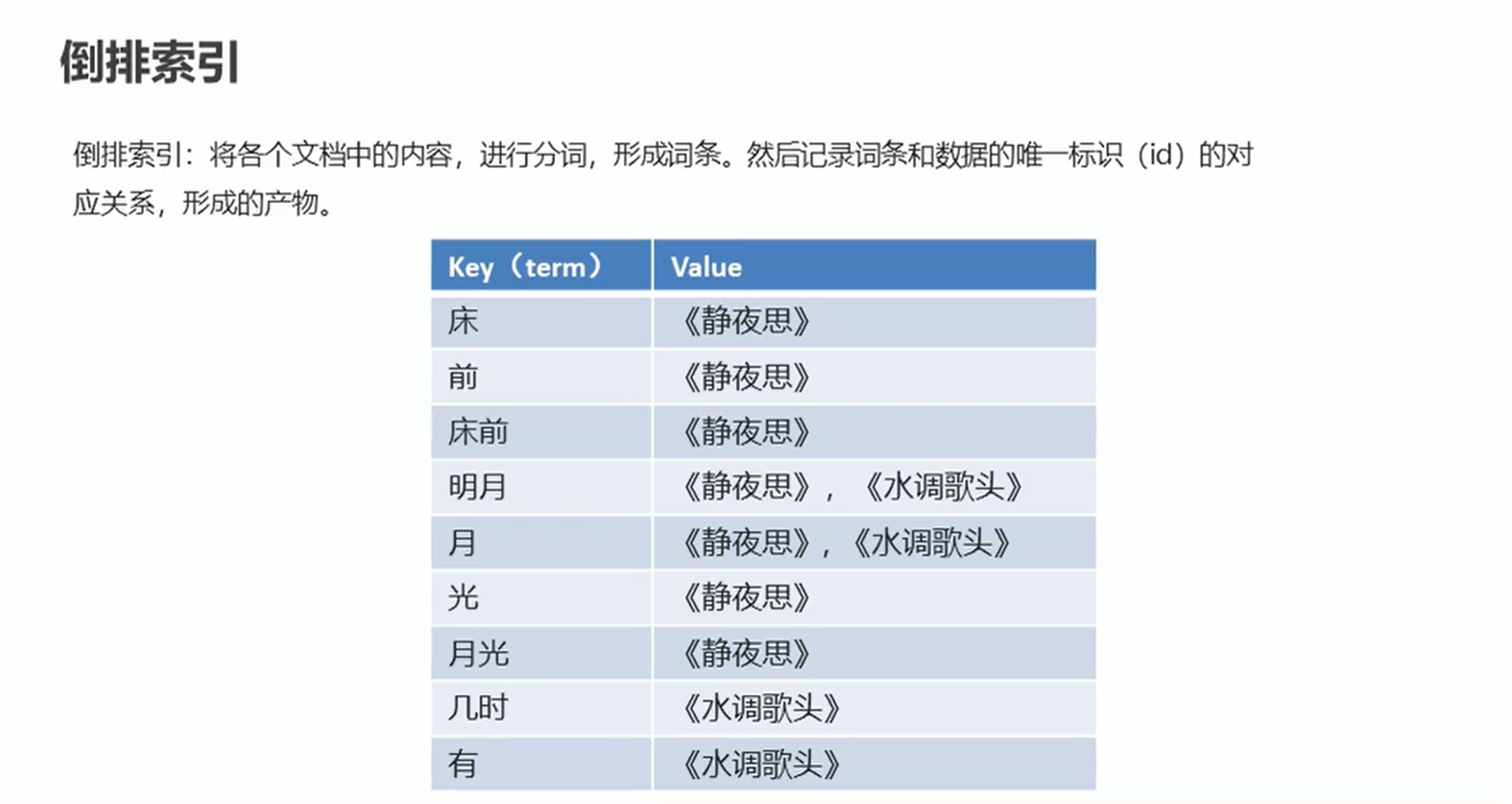

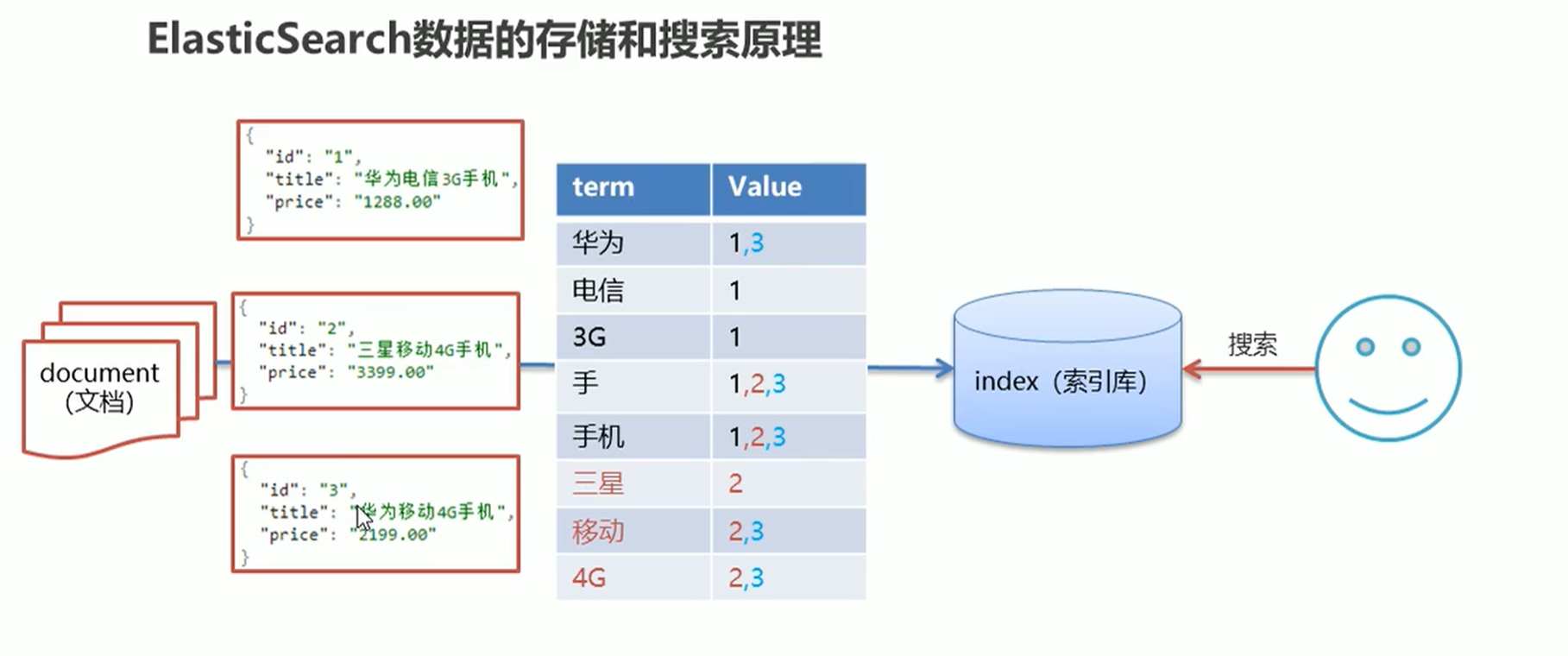

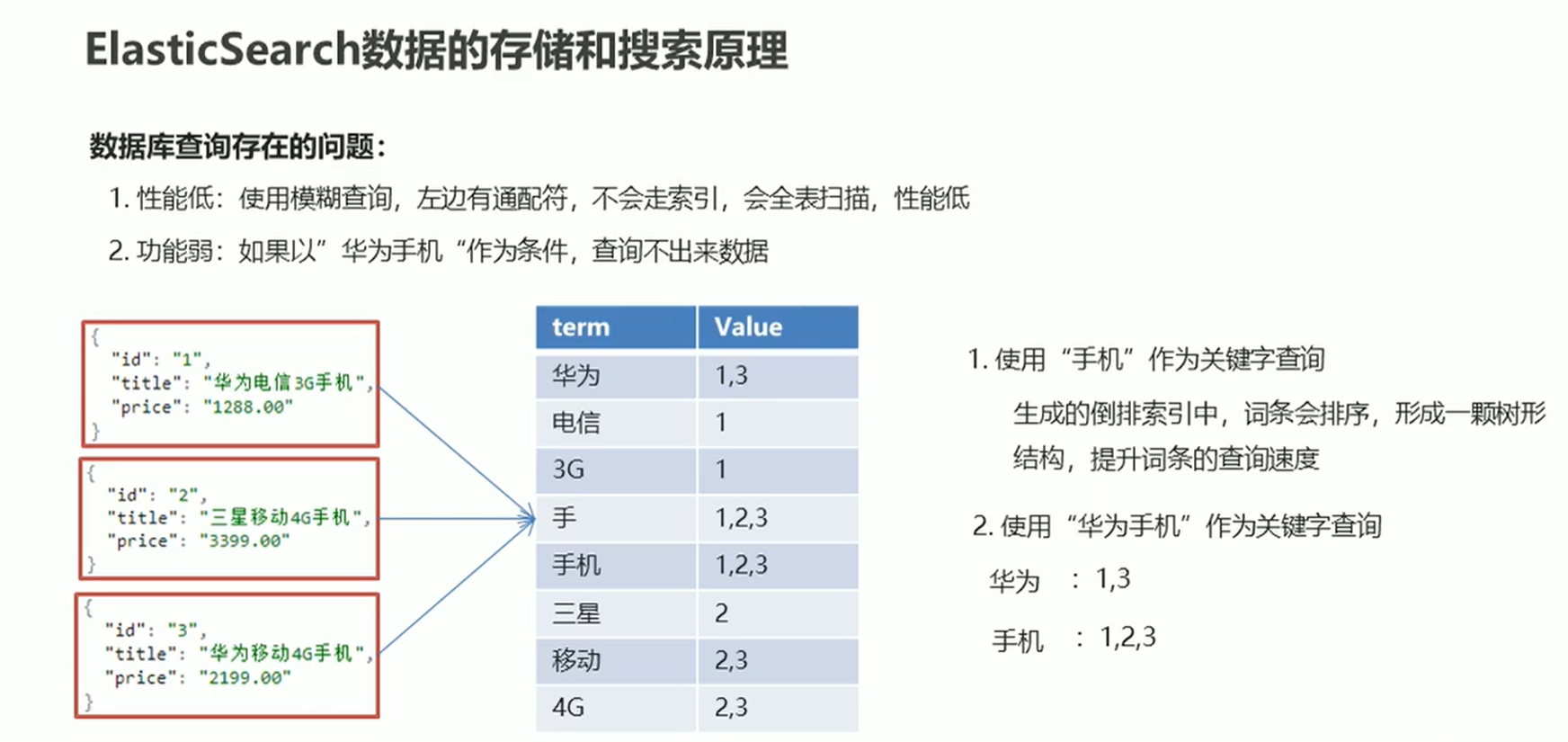

Elasticsearch是由 Java语言开发基于Lucene的一款开源的搜索、聚合分析和存储引擎。同时它也可以称作是一种非关系型文档数据库。

ElasticSearch和MySql分工不同,MySQL负责存储数据,ElasticSearch负责搜索数据

MySQL有事务性,而ElasticSearch没有事务性,所以你删了的数据是无法恢复的。

ElasticSearch没有物理外键这个特性,如果你的数据强一致性要求比较高还是建议慎用

因为ES生成的到排序索引中,词条会排序,形成一颗树形结构,提升词条的查询速度。

ES会先对查询关键字进行分词,再进行查询。

Netty 是由 JBOSS 提供的一个 Java 开源框架。Netty 提供异步的、基于事件驱动的网络应用程序框架,用以快速开发高性能、高可靠性的网络 IO 程序,是目前最流行的 NIO 框架,Netty 在互联网领域、大数据分布式计算领域、游戏行业、通信行业等获得了广泛的应用,知名的 Elasticsearch 、Dubbo 框架内部都采用了 Netty。

使用简单:封闭了 Java 原生 NIO 类库繁琐的 API,使用起来更加高效;

功能强大:预置多种编码能力,支持多种主流协议。同时通过 ChannelHandler 可以进行灵活的拓展,支持很强的定制能力;

高性能:与其它业界主流 NIO 框架相比,Netty 综合更优。主要体现在吞吐量更高、延迟更低、减少资源消耗以及最小化不必要的内存复制;

社区活跃与稳定:版本更新周期短,BUG 修复速度快,让开发者可以专注业务本身。

高并发:Netty 是一款基于 NIO(Nonblocking I/O,非阻塞IO)开发的网络通信框架。

传输快:Netty 使用零拷贝特性,尽量减少不必要的内存拷贝,实现更快的传输效率。

封装好:Netty 封装了 NIO 操作的很多细节,提供易于使用的 API。

理论上来说,NIO 可以做的事情,Netty 都可以做并且更好。Netty 主要用来做网络通信:

1)易用性:Netty 在 NIO 基础上封装了更加人性化的 API,大大降低开发人员的学习成本,同时还提供了很多开箱即用的工具。

2)稳定性:Netty 修复了 Java NIO 较多已知问题,如 select 空转导致 CPU 100%,TCP 断线重连,Keep-alive 检测等问题。

3)高性能:对象池复用(通过对象复用避免频繁创建和销毁带来的开销)和零拷贝技术。

Netty 和 Tomcat 最大的区别在于对通信协议的支持:

Tomcat 是基于 Http 协议的,本质是一个基于 http 协议的 web 容器,而 Netty 不仅支持 HTTP,还能通过编程自定义各种协议,通过 codec 自定义编码/解码字节流,完成数据传输。

Tomcat 需要遵循 Servlet 规范(HTTP 协议的请求-响应模型),而 Netty 不需要受到 Servlet 规范约束,可以发挥 NIO 最大特性。

BIO(同步阻塞 IO)

服务器实现模式为一个连接一个线程,即客户端有连接请求时服务器端就需要启动一个线程进行处理,如果这个连接不做任何事情会造成不必要的线程开销,当然可以通过线程池机制改善。BIO 方式适用于连接数目比较小且固定的架构,这种方式对服务器资源要求比较高,并发局限于应用中,JDK 1.4 以前的唯一选择,但程序直观简单易理解。

NIO(同步非阻塞 IO)

服务器实现模式为一个请求一个线程,即客户端发送的连接请求都会注册到多路复用器上,多路复用器轮询到连接有 IO 请求时才启动一个线程进行处理。NIO 方式适用于连接数目多且连接比较短(轻操作)的架构,比如聊天服务器,并发局限于应用中,编程比较复杂,JDK 1.4 开始支持。

AIO(异步非阻塞 IO)

服务器实现模式为一个有效请求一个线程,客户端的 IO 请求都是由 OS 先完成了再通知服务器应用去启动线程进行处理。 AIO 方式使用于连接数目多且连接比较长(重操作)的架构,比如相册服务器,充分调用 OS 参与并发操作,编程比较复杂,JDK 1.7 开始支持。

ref

Channel

基础的 IO 操作,如绑定、连接、读写等都依赖于底层网络传输所提供的原语,在 Java 的网络编程中,基础核心类是 Socket,而 Netty 的 Channel 提供了一组 API,极大地简化了直接与 Socket 进行操作的复杂性,并且 Channel 是很多类的父类,如 EmbeddedChannel、LocalServerChannel、NioDatagramChannel、NioSctpChannel、NioSocketChannel 等。

EventLoop

EventLoop 定义了处理在连接过程中发生的事件的核心抽象。

说白了,EventLoop 的主要作用实际就是负责监听网络事件并调用事件处理器进行相关 IO 操作的处理。

那 Channel 和 EventLoop 直接有啥联系呢?

Channel 为 Netty 网络操作(读写等操作)抽象类,EventLoop 负责处理注册到其上的 Channel 处理 IO 操作,两者配合参与 IO 操作。

ChannelFuture

ChannelHandler 和 ChannelPipeline

Bootstrap 和 ServerBootstrap

Netty 的引导类应用程序网络层配置提供容器,其涉及将进程绑定到给定端口或连接一个进程到在指定主机上指定端口上运行的另一进程。引导类分为客户端引导 Bootstrap 和服务端引导 ServerBootstrap。

EventLoopGroup 包含多个 EventLoop(每一个 EventLoop 通常内部包含一个线程),上面我们已经说了 EventLoop 的主要作用实际就是负责监听网络事件并调用事件处理器进行相关 I/O 操作的处理。

并且 EventLoop 处理的 I/O 事件都将在它专有的 Thread 上被处理,即 Thread 和 EventLoop 属于 1 : 1 的关系,从而保证线程安全。

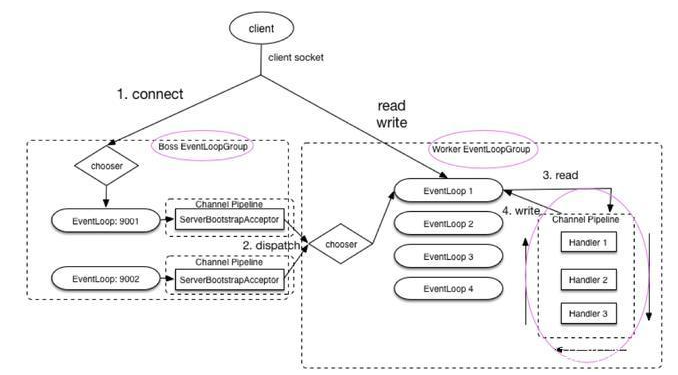

上图是一个服务端对 EventLoopGroup 使用的大致模块图,其中 Boss EventloopGroup 用于接收连接,Worker EventloopGroup 用于具体的处理(消息的读写以及其他逻辑处理)。

从上图可以看出:当客户端通过 connect 方法连接服务端时,bossGroup 处理客户端连接请求。当客户端处理完成后,会将这个连接提交给 workerGroup 来处理,然后 workerGroup 负责处理其 IO 相关操作。

Netty 通过 Reactor 模型基于多路复用器接收并处理用户请求,内部实现了两个线程池,boss 线程池和 work 线程池,其中 boss 线程池的线程负责处理请求的 accept 事件,当接收到 accept 事件的请求时,把对应的 socket 封装到一个 NioSocketChannel 中,并交给 work 线程池,其中 work 线程池负责请求的 read 和 write 事件,由对应的 Handler 处理。

1 | //1.eventGroup既用于处理客户端连接,又负责具体的处理。 |

对于代码:

1 | // 1.bossGroup 用于接收连接,workerGroup 用于具体的处理 |

1 | // 1.bossGroup 用于接收连接,workerGroup 用于具体的处理 |

先来看一段代码实现:

1 | // 1.bossGroup 用于接收连接,workerGroup 用于具体的处理 |

Netty 采用了串行无锁化设计,在 IO 线程内部进行串行操作,避免多线程竞争导致的性能下降。表面上看,串行化设计似乎 CPU 利用率不高,并发程度不够。但是,通过调整 NIO 线程池的线程参数,可以同时启动多个串行化的线程并行运行,这种局部无锁化的串行线程设计相比一个队列-多个工作线程模型性能更优。

Netty 的 NioEventLoop 读取到消息后,直接调用 ChannelPipeline 的 fireChannelRead(Object msg),只要用户不主动切换线程,一直会由 NioEventLoop 调用到用户的 handler,期间不进行线程切换,这种串行化处理方式避免了多线程操作导致的锁竞争,从性能角度看是最优的。

这个 BUG 是指 Java 的 NIO 在 Linux 下进行 selector.select() 时,本来如果轮询的结果为空并且不调用 wakeup 方法的话,这个 selector.select() 应该是一直阻塞的,但是 Java 却会打破阻塞,继续执行,导致程序无限空转,造成 CPU 使用率 100%。(这个问题只存在 Linux 是因为 Linux 的 NIO 是基于 epoll 实现的,而 Java 实现的 epoll 存在 BUG,windows 下 NIO 基于 poll 就不存在此问题)

Netty 的解决方案:

为 Selector 的 select 操作设置超时时间,同时定义可以跳出阻塞的四种情况:

而前两种返回值不为 0,可以跳出循环,超时有时间戳记录,所以每次空轮询,有专门的计数器进行 +1,如果空轮询的次数超过了 512 次(默认),就认为其触发了空轮询 BUG。

当触发 BUG 后,Netty 直接重建一个 Selector,将原来的 Channel 重新注册到新的 Selector 上,并将旧的 Selector 关掉。

TCP 是一个面向流的传输协议,所谓流,就是没有界限的一串数据。TCP 底层并不了解上层业务数据的具体含义,它会根据 TCP 缓冲区的实际情况进行包的划分,所以在业务上认为,一个完整的包可能会被 TCP 拆分成多个包进行发送,也有可能把多个小的包封装成一个大的数据包发送,这就是所谓的 TCP 粘包和拆包问题。

粘包和拆包是 TCP 网络编程中不可避免的,无论是服务端还是客户端,当我们读取或者发送消息的时候,都需要考虑 TCP 底层的粘包/拆包机制。

数据从发送方到接收方需要经过操作系统的缓冲区,而造成粘包和拆包的主要原因就在这个缓冲区上。粘包可以理解为缓冲区数据堆积,导致多个请求数据粘在一起,而拆包可以理解为发送的数据大于缓冲区,进行拆分处理。

详细来说,造成粘包和拆包的原因主要有以下三个:

1)应用程序 write 写入的字节大小大于套接口发送缓冲区大小;

2)进行 MSS 大小的 TCP 分段;

3)以太网帧的 payload 大于 MTU 进行 IP 分片。

由于底层的 TCP 无法理解上层的业务数据,所以在底层是无法保证数据包不被拆分和重组的,这个问题只能通过上层的应用协议栈设计来解决,根据业界的主流协议可以归纳出以下解决方案:

1)消息长度固定,累计读取到长度和为定长LEN的报文后,就认为读取到了一个完整的信息。

2)将特殊的分隔符作为消息的结束标志,如回车换行符。

3)通过在消息头中定义长度字段来标识消息的总长度。

相比粘包,拆包问题比较简单,用户可以自己定义自己的编码器进行处理,Netty 并没有提供相应的组件。对于粘包的问题,代码比较繁琐,Netty 提供了 4 种解码器来解决,分别如下:

Zero-copy 就是在操作数据时, 不需要将数据 buffer从 一个内存区域拷贝到另一个内存区域。 少了一次内存的拷贝,CPU 效率就得到的提升。

接收和发送 ByteBuffer 采用 DIRECT BUFFERS,使用堆外直接内存进行 Socket 读写,不需要进行字节缓冲区的二次拷贝;

提供了组合 Buffer 对象,可以聚合多个 ByteBuffer 对象,用户可以像操作一个 Buffer 那样方便的对组合 Buffer 进行操作;

文件传输采用了 transferTo 方法,它可以直接将文件缓冲区的数据发送到目标 Channel,避免了传统通过循环 write 方式导致的内存拷贝问题。

和操作系统上的零拷贝的区别?

Netty 的 Zero-copy 完全是在用户态(Java 应用层)的, 更多的偏向于优化数据操作。而在 OS 层面上的 Zero-copy 通常指避免在用户态(User-space)与内核态(Kernel-space)之间来回拷贝数据。

我们知道 TCP 在进行读写之前,server 与 client 之间必须提前建立一个连接。建立连接的过程,需要我们常说的三次握手,释放/关闭连接的话需要四次挥手。这个过程是比较消耗网络资源并且有时间延迟的。

所谓,短连接说的就是 server 端 与 client 端建立连接之后,读写完成之后就关闭掉连接,如果下一次再要互相发送消息,就要重新连接。短连接的有点很明显,就是管理和实现都比较简单,缺点也很明显,每一次的读写都要建立连接必然会带来大量网络资源的消耗,并且连接的建立也需要耗费时间。

长连接说的就是 client 向 server 双方建立连接之后,即使 client 与 server 完成一次读写,它们之间的连接并不会主动关闭,后续的读写操作会继续使用这个连接。长连接的可以省去较多的 TCP 建立和关闭的操作,降低对网络资源的依赖,节约时间。对于频繁请求资源的客户来说,非常适用长连接。

在 TCP 保持长连接的过程中,可能会出现断网等网络异常出现,异常发生的时候, client 与 server 之间如果没有交互的话,它们是无法发现对方已经掉线的。为了解决这个问题, 我们就需要引入心跳机制。

心跳机制的工作原理是: 在 client 与 server 之间在一定时间内没有数据交互(即处于 idle 状态)时, 客户端或服务器就会发送一个特殊的数据包给对方, 当接收方收到这个数据报文后, 也立即发送一个特殊的数据报文, 回应发送方, 此即一个 PING-PONG 交互。所以, 当某一端收到心跳消息后, 就知道了对方仍然在线, 这就确保 TCP 连接的有效性。

TCP 实际上自带的就有长连接选项,本身是也有心跳包机制,也就是 TCP 的选项:SO_KEEPALIVE。但 TCP 协议层面的长连接灵活性不够,所以,一般情况下我们都是在应用层协议上实现自定义心跳机制的,也就是在 Netty 层面通过编码实现。通过 Netty 实现心跳机制的话,核心类是 IdleStateHandler 。

对象池其实就是缓存一些对象从而避免大量创建同一个类型的对象,类似线程池的概念。对象池缓存了一些已经创建好的对象,避免需要时才创建对象,同时限制了实例的个数。池化技术最终要的就是重复的使用池内已经创建的对象。从上面的内容就可以看出对象池适用于以下几个场景:

Netty 自己实现了一套轻量级的对象池。在 Netty 中,通常会有多个 IO 线程独立工作(基于 NioEventLoop 实现)。每个 IO 线程轮询单独的 Selector 实例来检索 IO 事件,并在 IO 来临时开始处理。最常见的 IO 操作就是读写,具体到 NIO 就是从内核缓冲区拷贝数据到用户缓冲区或者从用户缓冲区拷贝数据到内核缓冲区。这里会涉及到大量的创建和回收 Buffer, Netty 对 Buffer 进行了池化从而降低系统开销。

ref

序列化(编码)是将对象序列化为二进制形式(字节数组),主要用于网络传输、数据持久化等;而反序列化(解码)则是将从网络、磁盘等读取的字节数组还原成原始对象,主要用于网络传输对象的解码,以便完成远程调用。

影响序列化性能的关键因素:序列化后的码流大小(网络带宽的占用)、序列化的性能(CPU资源占用);是否支持跨语言(异构系统的对接和开发语言切换)。

目前几种主流协议

Java 默认提供的序列化

无法跨语言、序列化后的码流太大、序列化的性能差。

XML

优点是人机可读性好,可指定元素或特性的名称。缺点:序列化数据只包含数据本身以及类的结构,不包括类型标识和程序集信息;只能序列化公共属性和字段;不能序列化方法;文件庞大,文件格式复杂,传输占带宽。适用场景:当做配置文件存储数据,实时数据转换。

JSON

是一种轻量级的数据交换格式,优点:兼容性高、数据格式比较简单,易于读写、序列化后数据较小,可扩展性好,兼容性好、与XML相比,其协议比较简单,解析速度比较快。缺点:数据的描述性比XML差、不适合性能要求为ms级别的情况、额外空间开销比较大。适用场景(可替代XML):跨防火墙访问、可调式性要求高、基于Web browser的Ajax请求、传输数据量相对小,实时性要求相对低(例如秒级别)的服务。

Fastjson

采用一种“假定有序快速匹配”的算法。优点:接口简单易用、目前java语言中最快的json库。缺点:过于注重快,而偏离了“标准”及功能性、代码质量不高,文档不全。适用场景:协议交互、Web输出、Android客户端。

Thrift

不仅是序列化协议,还是一个RPC框架。优点:序列化后的体积小, 速度快、支持多种语言和丰富的数据类型、对于数据字段的增删具有较强的兼容性、支持二进制压缩编码。缺点:使用者较少、跨防火墙访问时,不安全、不具有可读性,调试代码时相对困难、不能与其他传输层协议共同使用(例如HTTP)、无法支持向持久层直接读写数据,即不适合做数据持久化序列化协议。适用场景:分布式系统的RPC解决方案。

Avro

Hadoop的一个子项目,解决了JSON的冗长和没有IDL的问题。优点:支持丰富的数据类型、简单的动态语言结合功能、具有自我描述属性、提高了数据解析速度、快速可压缩的二进制数据形式、可以实现远程过程调用RPC、支持跨编程语言实现。缺点:对于习惯于静态类型语言的用户不直观。适用场景:在Hadoop中做Hive、Pig和MapReduce的持久化数据格式。

Protobuf

将数据结构以.proto文件进行描述,通过代码生成工具可以生成对应数据结构的POJO对象和Protobuf相关的方法和属性。优点:序列化后码流小,性能高、结构化数据存储格式(XML JSON等)、通过标识字段的顺序,可以实现协议的前向兼容、结构化的文档更容易管理和维护。缺点:需要依赖于工具生成代码、支持的语言相对较少,官方只支持Java 、C++ 、python。适用场景:对性能要求高的RPC调用、具有良好的跨防火墙的访问属性、适合应用层对象的持久化。

2020年04月13日

Java面试总结汇总,整理了包括Java重点知识,以及常用开源框架,欢迎大家阅读。文章可能有错误的地方,因为个人知识有限,欢迎各位大佬指出!文章持续更新中…

ID 标题 地址 1 设计模式面试题(总结最全面的面试题) juejin.cn/post/684490… 2 Java基础知识面试题(总结最全面的面试题) juejin.cn/post/684490… 3 Java集合面试题(总结最全面的面试题) juejin.cn/post/684490… 4 JavaIO、BIO、NIO、AIO、Netty面试题(总结最全面的面试题) juejin.cn/post/684490… 5 Java并发编程面试题(总结最全面的面试题) juejin.cn/post/684490… 6 Java异常面试题(总结最全面的面试题) juejin.cn/post/684490… 7 Java虚拟机(JVM)面试题(总结最全面的面试题) juejin.cn/post/684490… 8 Spring面试题(总结最全面的面试题) juejin.cn/post/684490… 9 Spring MVC面试题(总结最全面的面试题) juejin.cn/post/684490… 10 Spring Boot面试题(总结最全面的面试题) juejin.cn/post/684490… 11 Spring Cloud面试题(总结最全面的面试题) juejin.cn/post/684490… 12 Redis面试题(总结最全面的面试题) juejin.cn/post/684490… 13 MyBatis面试题(总结最全面的面试题) juejin.cn/post/684490… 14 MySQL面试题(总结最全面的面试题) juejin.cn/post/684490… 15 TCP、UDP、Socket、HTTP面试题(总结最全面的面试题) juejin.cn/post/684490… 16 Nginx面试题(总结最全面的面试题) juejin.cn/post/684490… 17 ElasticSearch面试题 18 kafka面试题 19 RabbitMQ面试题(总结最全面的面试题) juejin.cn/post/684490… 20 Dubbo面试题(总结最全面的面试题) juejin.cn/post/684490… 21 ZooKeeper面试题(总结最全面的面试题) juejin.cn/post/684490… 22 Netty面试题(总结最全面的面试题) 23 Tomcat面试题(总结最全面的面试题) juejin.cn/post/684490… 24 Linux面试题(总结最全面的面试题) juejin.cn/post/684490… 25 互联网相关面试题(总结最全面的面试题) 26 互联网安全面试题(总结最全面的面试题)

java 如关闭数据源自动配置功能: @SpringBootApplication(exclude = { DataSourceAutoConfiguration.class })。XXXAutoConfiguration ,在这个配置类中通过条件注解来决定一个配置是否生效(条件注解就是 Spring 中原本就有的),然后它还会提供一系列的默认配置,也允许开发者根据实际情况自定义相关配置,然后通过类型安全的属性(spring.factories)注入将这些配置属性注入进来,新注入的属性会代替掉默认属性。正因为如此,很多第三方框架,我们只需要引入依赖就可以直接使用了。当然,开发者也可以自定义 Starter我个人理解SpringBoot就是由各种Starter组合起来的,我们自己也可以开发Starter尽管 Spring Boot 有很多优点,但它仍然有一些缺点需要牢记:

这个时候再导入我们需要的springboot starter时,就可以忽略版本号:

这个时候再导入我们需要的springboot starter时,就可以忽略版本号:

可以实现接口 ApplicationRunner 或者 CommandLineRunner,这两个接口实现方式一样,它们都只提供了一个 run 方法

1 |

|

@Component注解

这个实现类,要注入到spring容器中,这里使用了@Component注解;

在同一个项目中,可以定义多个ApplicationRunner的实现类,他们的执行顺序通过注解@Order注解或者再实现Ordered接口来实现。

run方法的参数:ApplicationArguments可以获取到当前项目执行的命令参数。(比如把这个项目打成jar执行的时候,带的参数可以通过ApplicationArguments获取到);由于该方法是在容器启动完成之后,才执行的,所以,这里可以从spring容器中拿到其他已经注入的bean。

@Order注解

如果有多个实现类,而你需要他们按一定顺序执行的话,可以在实现类上加上@Order注解。@Order(value=整数值)。SpringBoot会按照@Order中的value值从小到大依次执行。

@order,使用注解方式使bean的加载顺序得到控制,@Order标记定义了组件的加载顺序,值越小拥有越高的优先级,可为负数。值越小,越先被加载。

@Order(-1)优先于@Order(0)

@Order(1)优先于@Order(2)

背景

项目启动之前,预先加载数据。比如,权限容器、特殊用户数据等。通常我们可以使用监听器、事件来操作。但是,springboot提供了一个简单的方式来实现此类需求,即,CommandLineRunner。

先了解一下这个类

1 | import org.springframework.core.Ordered; |

文档中,我们可以知道以下几点。

所以我们基本上大概已经了解了这个接口的作用以及用法。

案例说明

分别定义一个数据加载类MyStartupRunner1,排序为2;另一个数据加载类MyStartupRunner2,排序为1。看看它们记载数据的顺序。

1 |

|

1 |

|

在 Spring Boot 里面,可以使用以下几种方式来加载配置。

常用配置文件中读取配置的结论:config配置中心 => jvm参数 => 系统环境变量 => 项目内的application-xxx.yaml => 项目内的application.yaml => bootstrap.yaml

1 |

|

controller 的增强,用于对controller 做一些统一的操作,一般是用于全局的异常处理,也可以用于全局结果的返回处理

可以在一定程度上简化代码,减少代码的书写量,统一对所有结果和异常做处理,包括异常信息的返回和错误日志的答应等

@ControllerAdvice,是Spring3.2提供的新注解,它是一个Controller增强器,可对controller中被 @RequestMapping注解的方法加一些逻辑处理。主要作用有一下三种 :

需要配合@ExceptionHandler使用。 当将异常抛到controller时,可以对异常进行统一处理,规定返回的json格式或是跳转到一个错误页面

全局异常处理举例以及说明

@ControllerAdvice ,@ExceptionHandler 的全局处理

Slf4j 为日志注解

1 | ...... |

Spring boot actuator 是 spring 启动框架中的重要功能之一。Spring boot 监视器可帮助您访问生产环境中正在运行的应用程序的当前状态。有几个指标必须在生产环境中进行检查和监控。即使一些外部应用程序可能正在使用这些服务来向相关人员触发警报消息。监视器模块公开了一组可直接作为 HTTP URL 访问的REST 端点来检查状态。

Spring Boot自带监控组件—Actuator,它可以帮助实现对程序内部运行情况的监控。本章首先介绍Actuator轻松实现应用程序的监控治理,比如健康状况、审计、统计和HTTP追踪、Bean加载情况、环境变量、日志信息、线程信息等,然后介绍如何使用Spring Boot Admin构建完整的运维监控平台。

Actuator的核心是端点(Endpoint),它用来监视、提供应用程序的信息,Spring Boot提供的spring-boot-actuator组件中已经内置了非常多的Endpoint(health、info、beans、metrics、httptrace、shutdown等),每个端点都可以启用和禁用。

监控端点分类:

1)应用配置类:可以查看应用在运行期的静态信息,比如自动配置信息、加载的Spring Bean信息、YML文件配置信息、环境信息、请求映射信息。

2)度量指标类:主要是运行期的动态信息,如堆栈、请求连接、健康状态、系统性能等

3)操作控制类:主要是指shutdown,用户可以发送一个请求将应用的监控功能关闭。

1 | <dependency> |

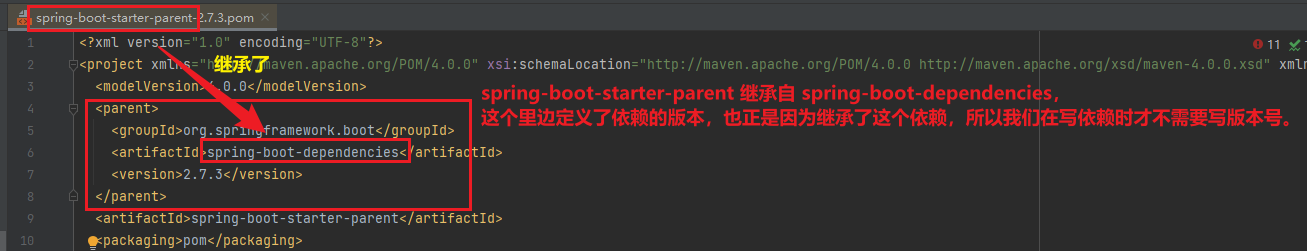

我们都知道,新创建一个 Spring Boot 项目,默认都是有 parent 的,这个 parent 就是 spring-boot-starter-parent ,spring-boot-starter-parent 主要有如下作用:

定义了 Java 编译版本为 1.8 。

使用 UTF-8 格式编码。

继承自 spring-boot-dependencies,这个里边定义了依赖的版本,也正是因为继承了这个依赖,所以我们在写依赖时才不需要写版本号。看源码发现:

执行打包操作的配置。

自动化的资源过滤。

自动化的插件配置。

针对 application.properties 和 application.yml 的资源过滤,包括通过 profile 定义的不同环境的配置文件,例如 application-dev.properties 和 application-dev.yml。

总结就是打包用的

java -jar xxx.jar 命令来运行,这种 jar 不可以作为普通的 jar 被其他项目依赖,即使依赖了也无法使用其中的类。\BOOT-INF\classes 目录下才是我们的代码,因此无法被直接引用。如果非要引用,可以在 pom.xml 文件中增加配置,将 Spring Boot 项目打包成两个 jar ,一个可执行,一个可引用。Queries Per Second 是每秒查询率 ,是一台服务器每秒能够相应的查询次数,是对一个特定的查询服务器在规定时间内所处理流量多少的衡量标准, 即每秒的响应请求数,也即是最大吞吐能力。

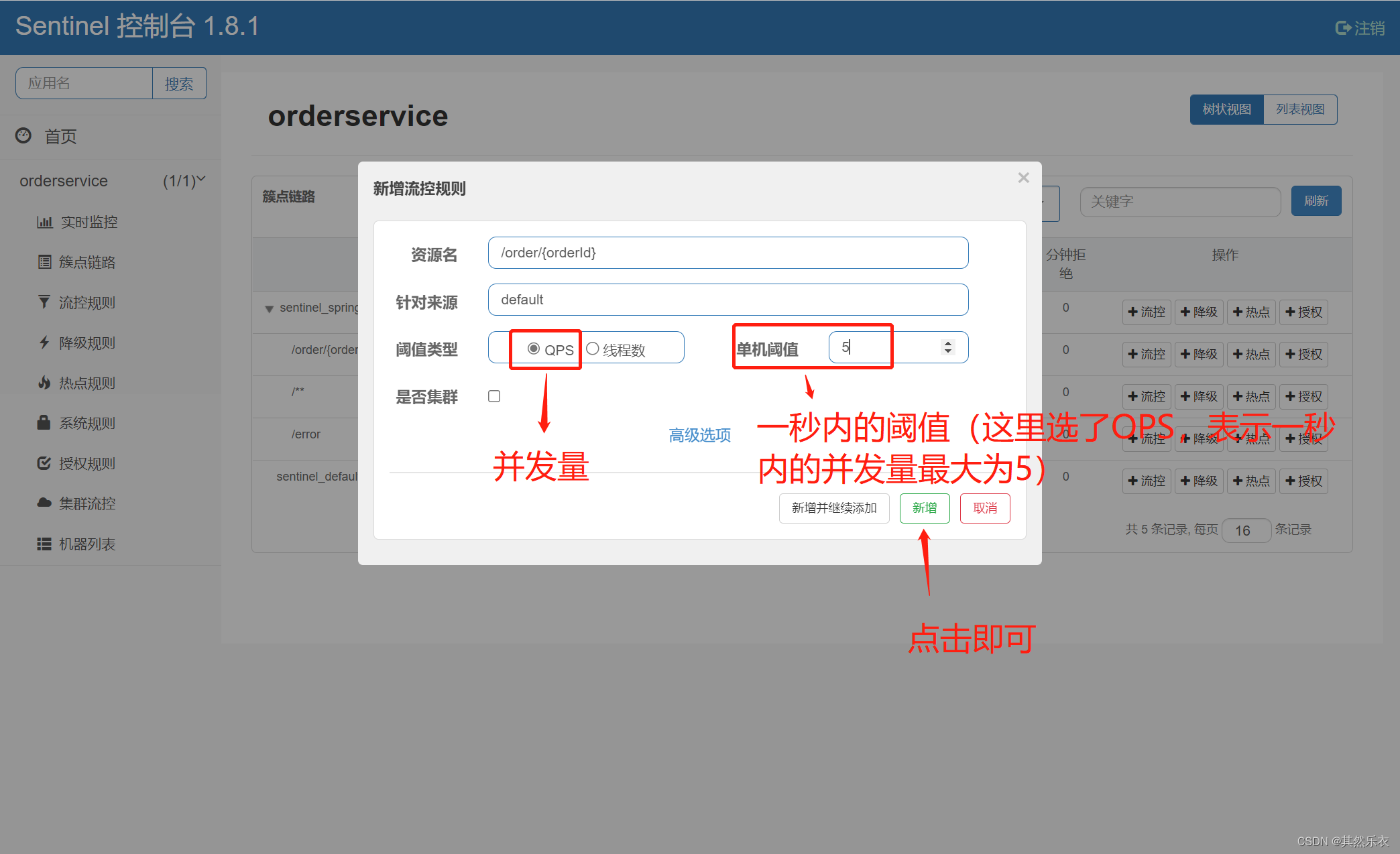

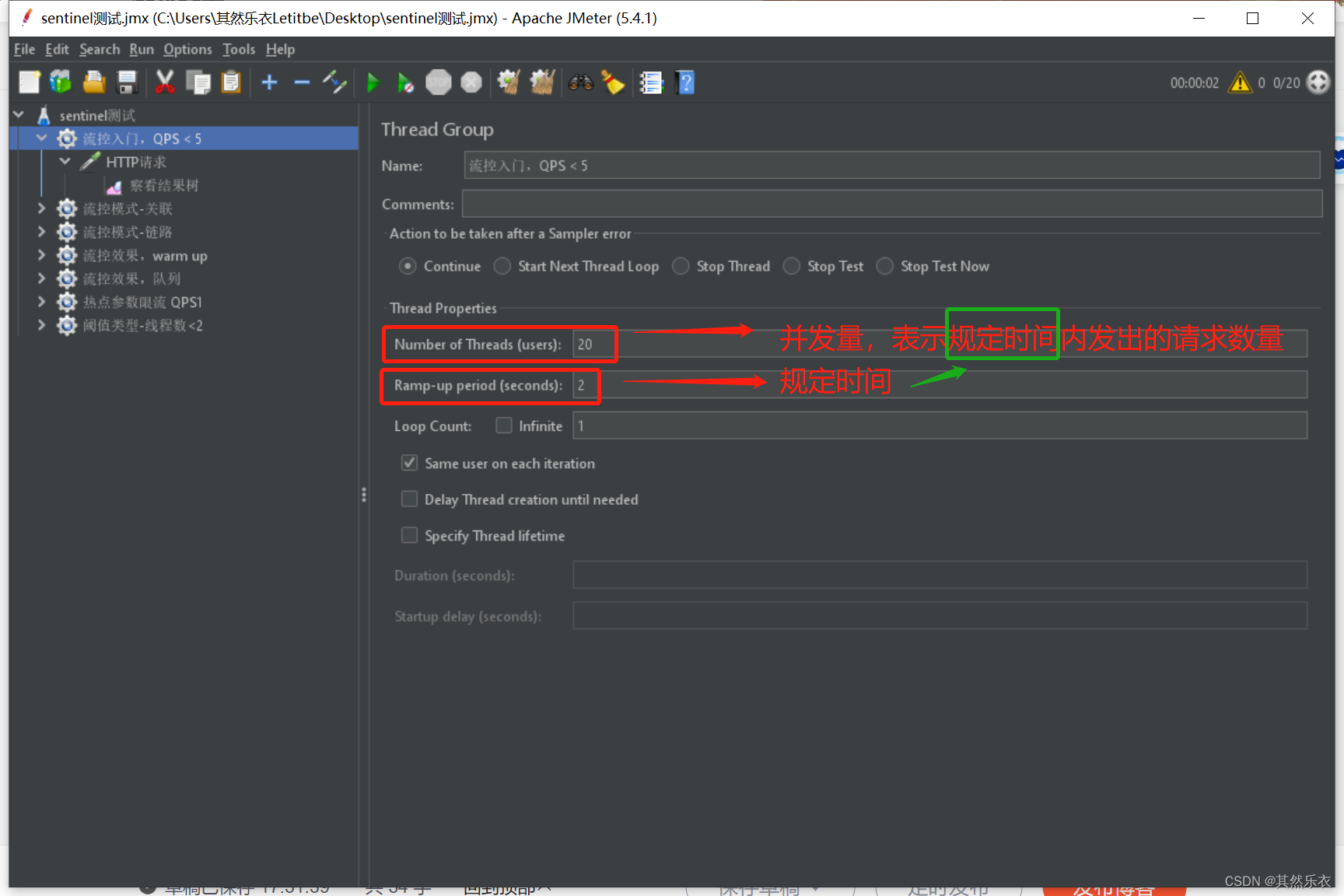

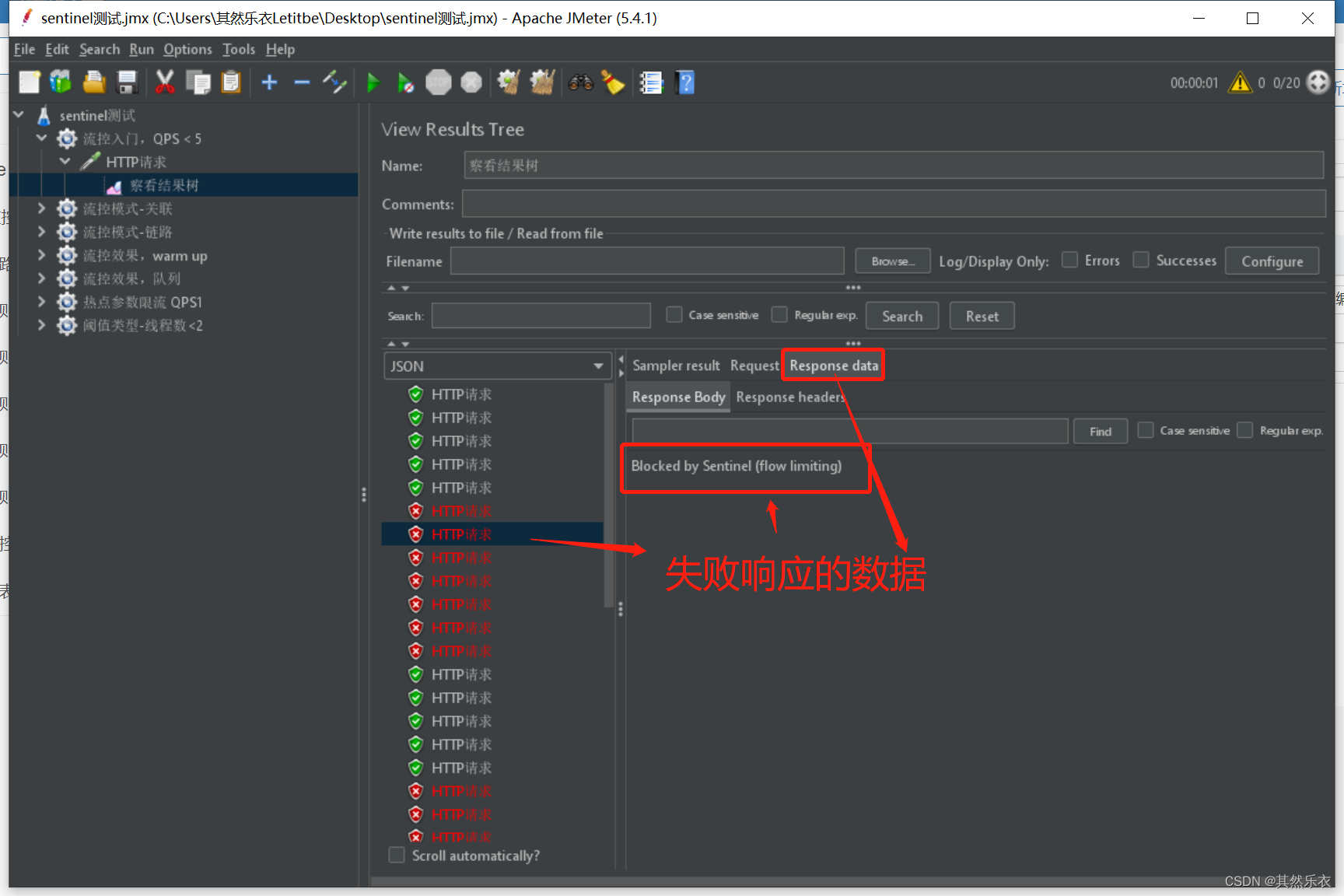

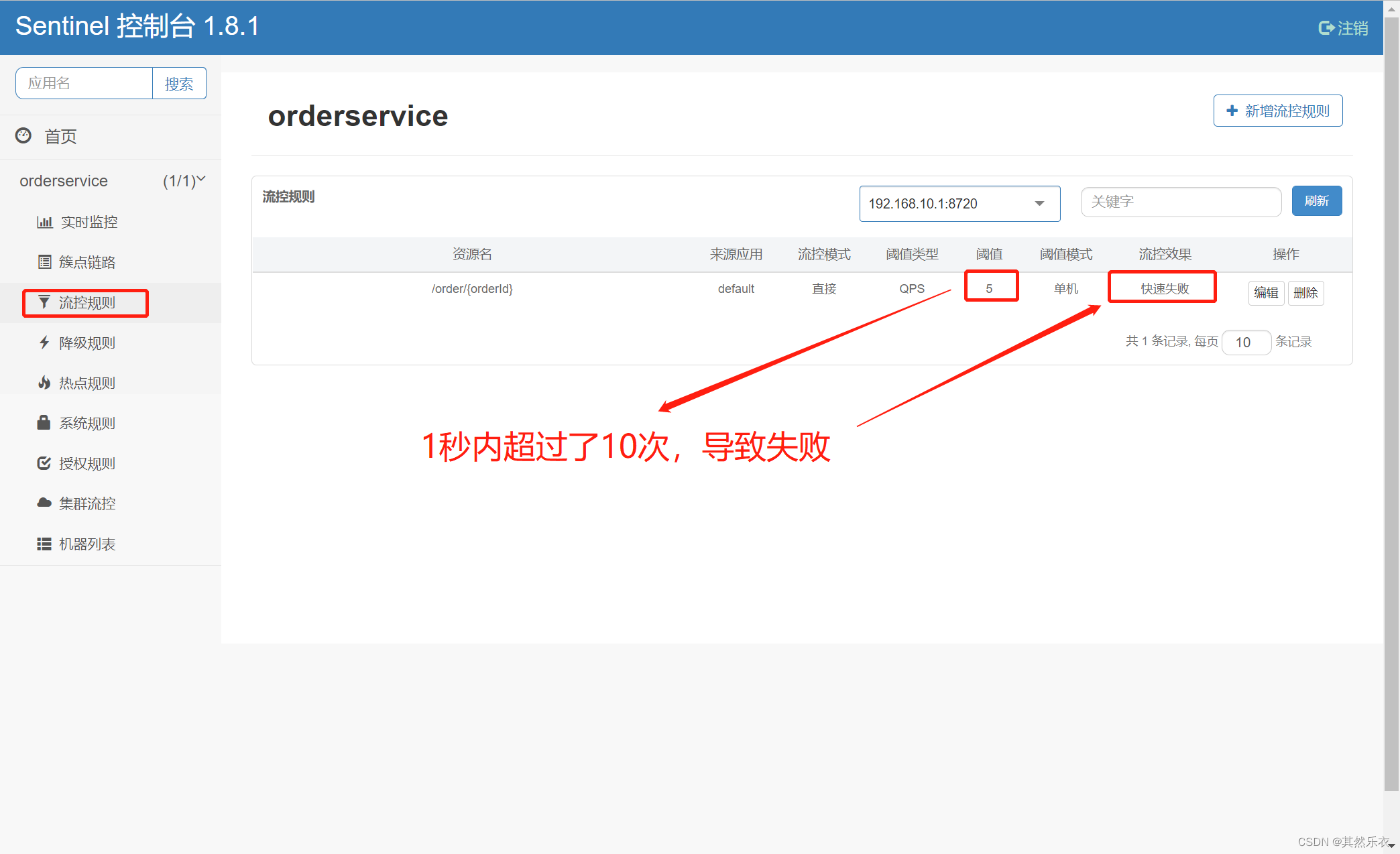

添加规则:

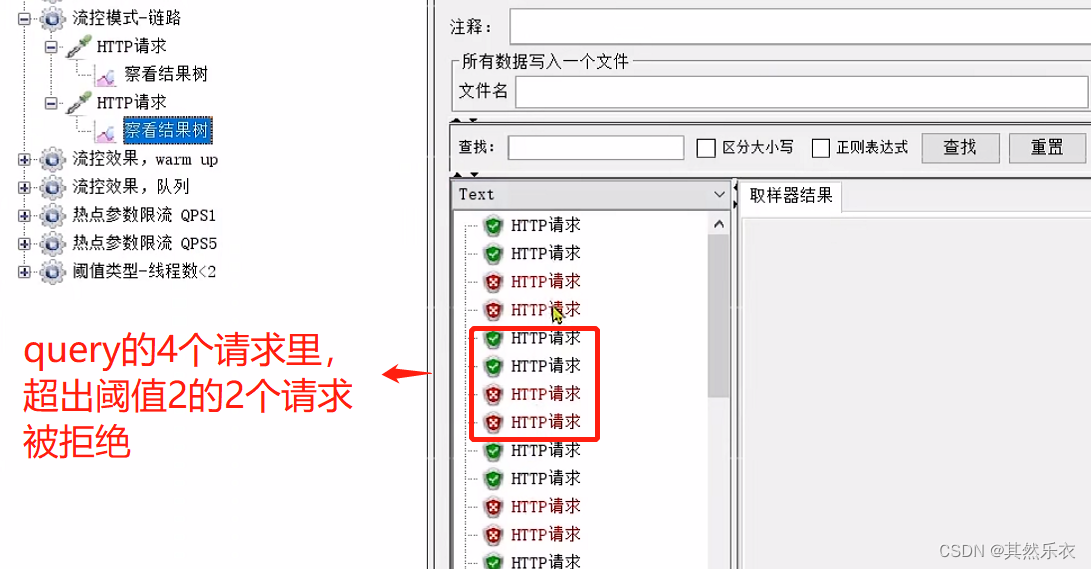

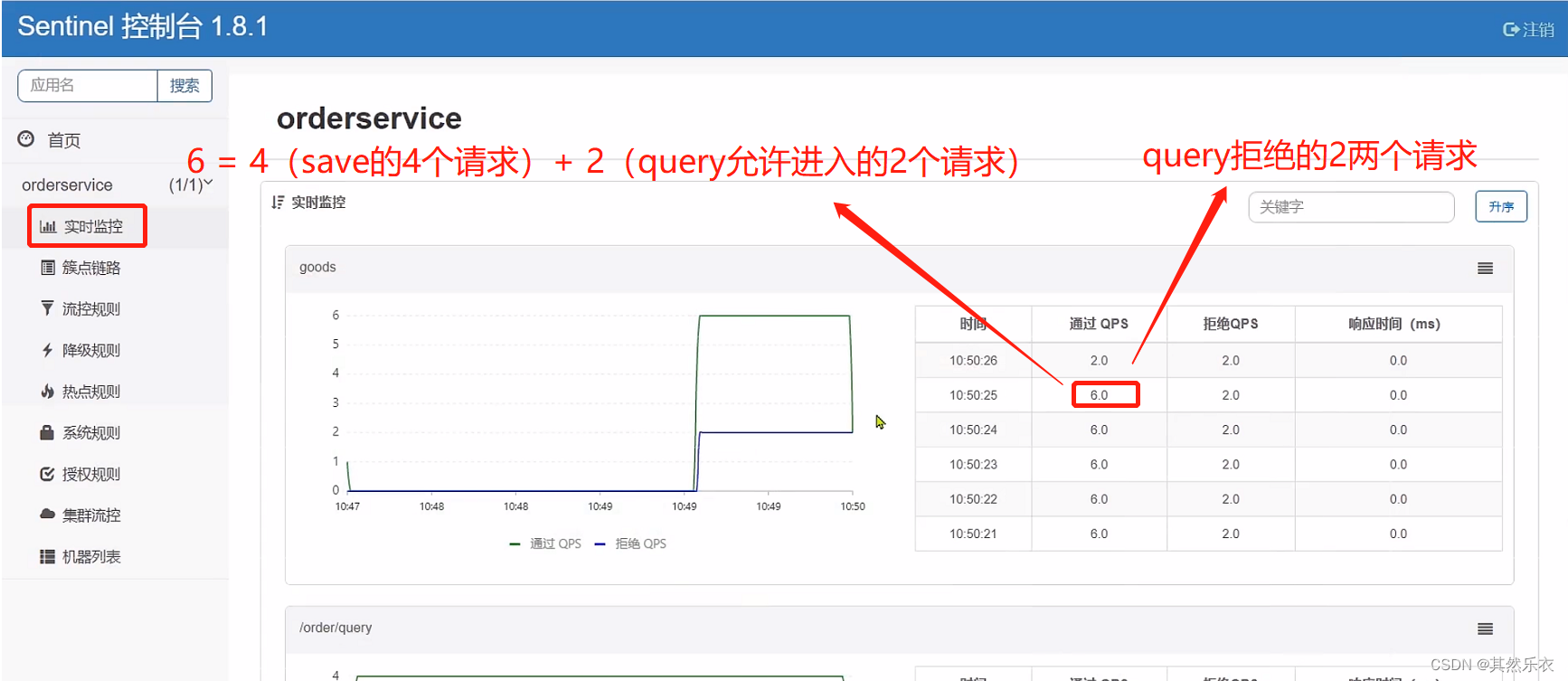

测试例子分析:

启动测试

点击 察看结果树

上面测试例子,到Sentinel控制台的实时监控可以看到

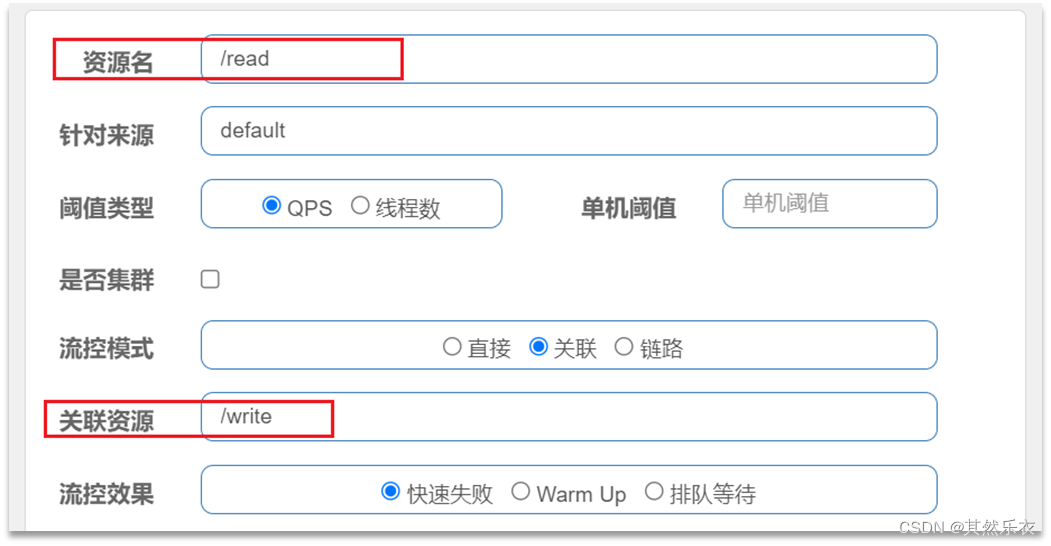

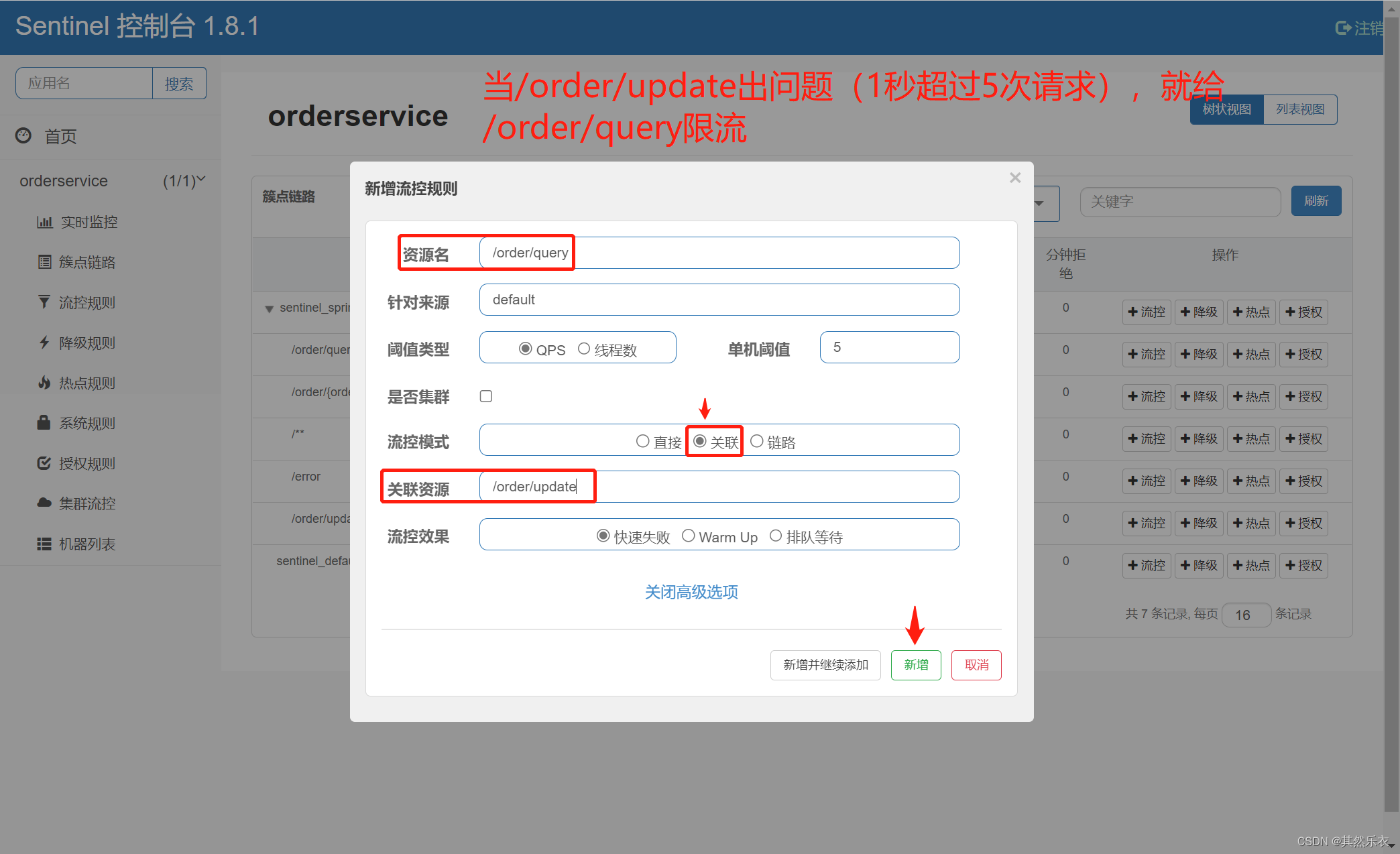

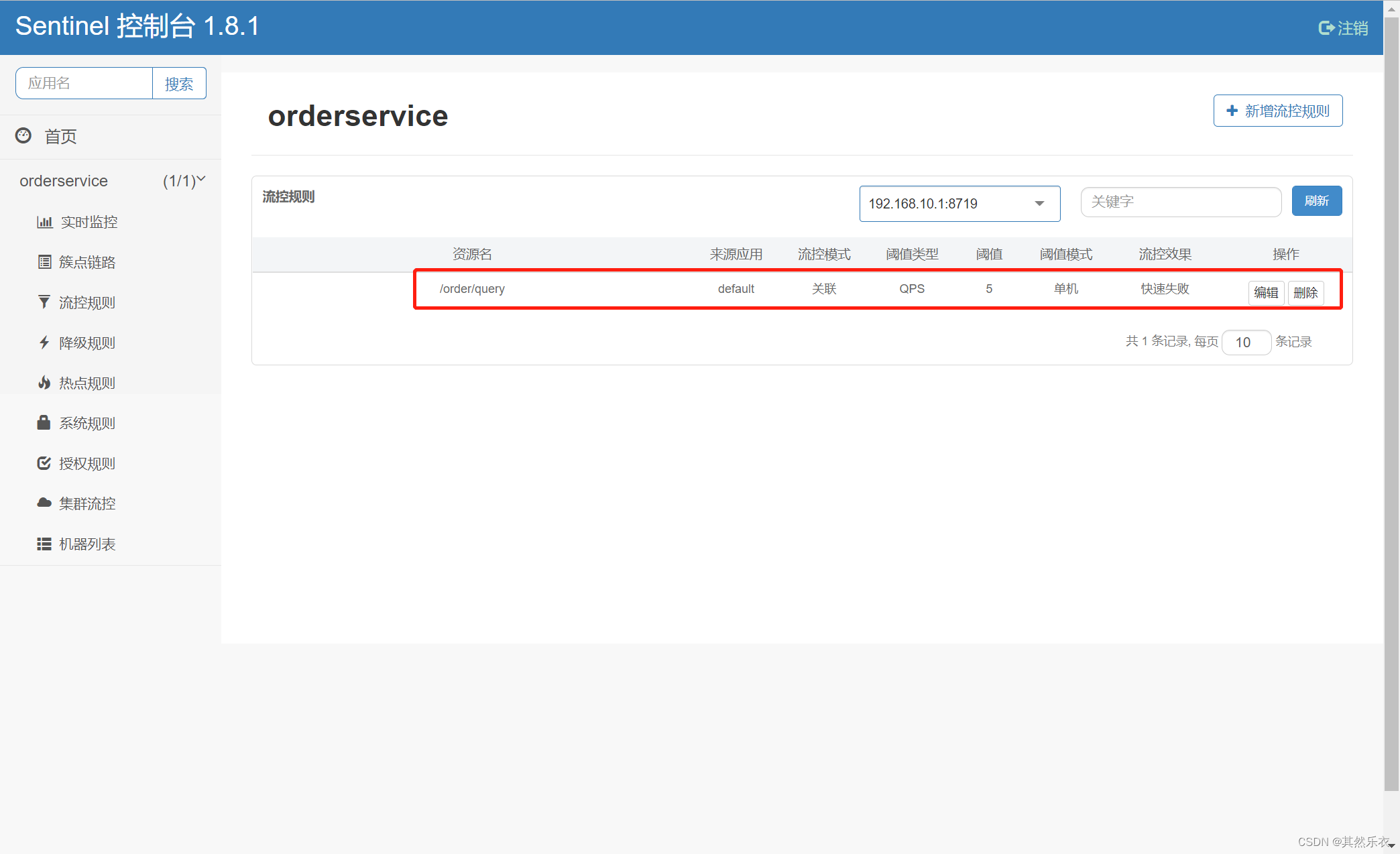

•关联模式:统计与当前资源相关的另一个资源,触发阈值时,对当前资源限流

•使用场景:比如用户支付时需要修改订单状态,同时用户要查询订单。查询和修改操作会争抢数据库锁,产生竞争。业务需求是有限支付和更新订单的业务,因此当修改订单业务触发阈值时,需要对查询订单业务限流。

当**/write资源访问量触发阈值时,就会对/read**资源限流,避免影响/write资源。

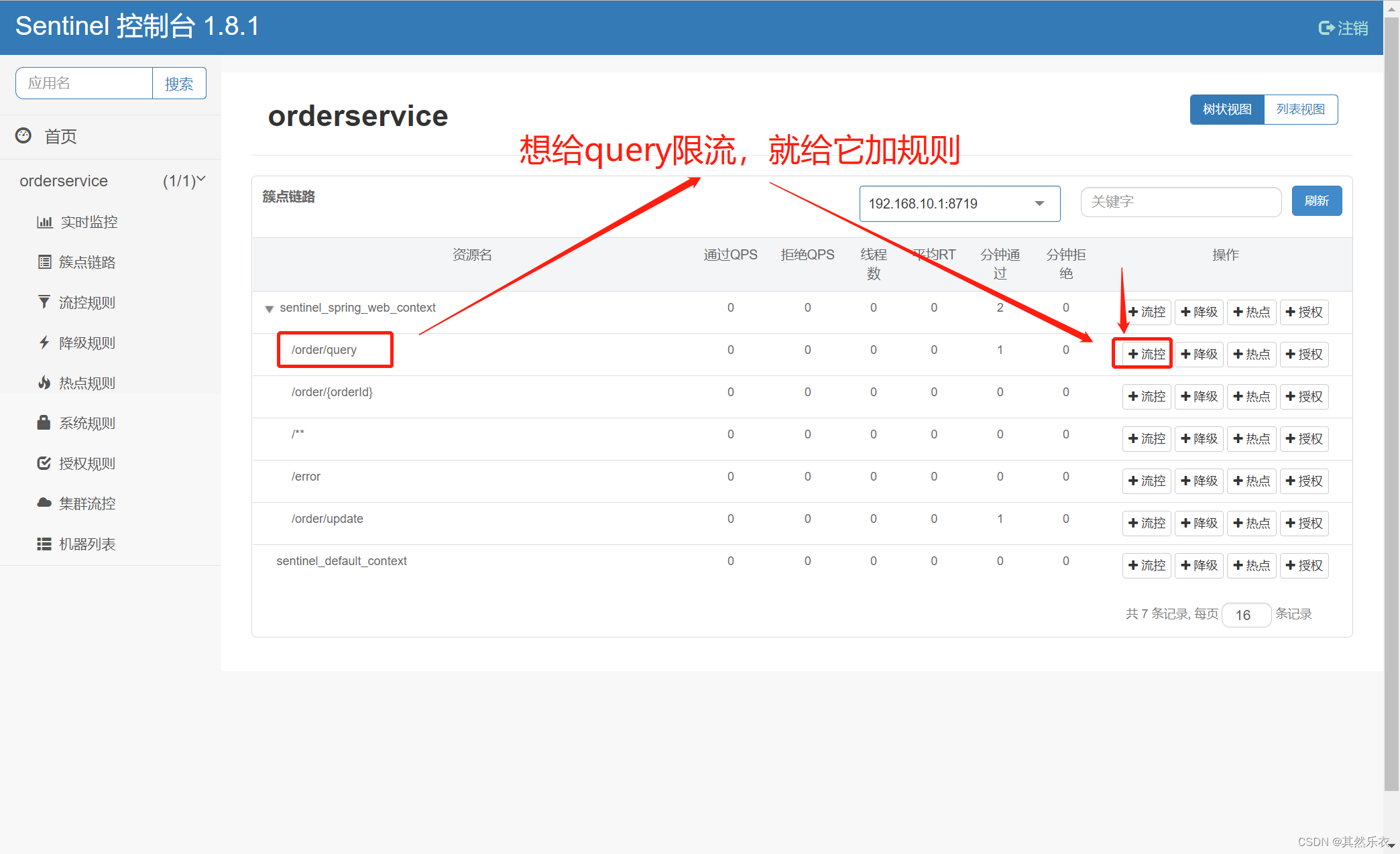

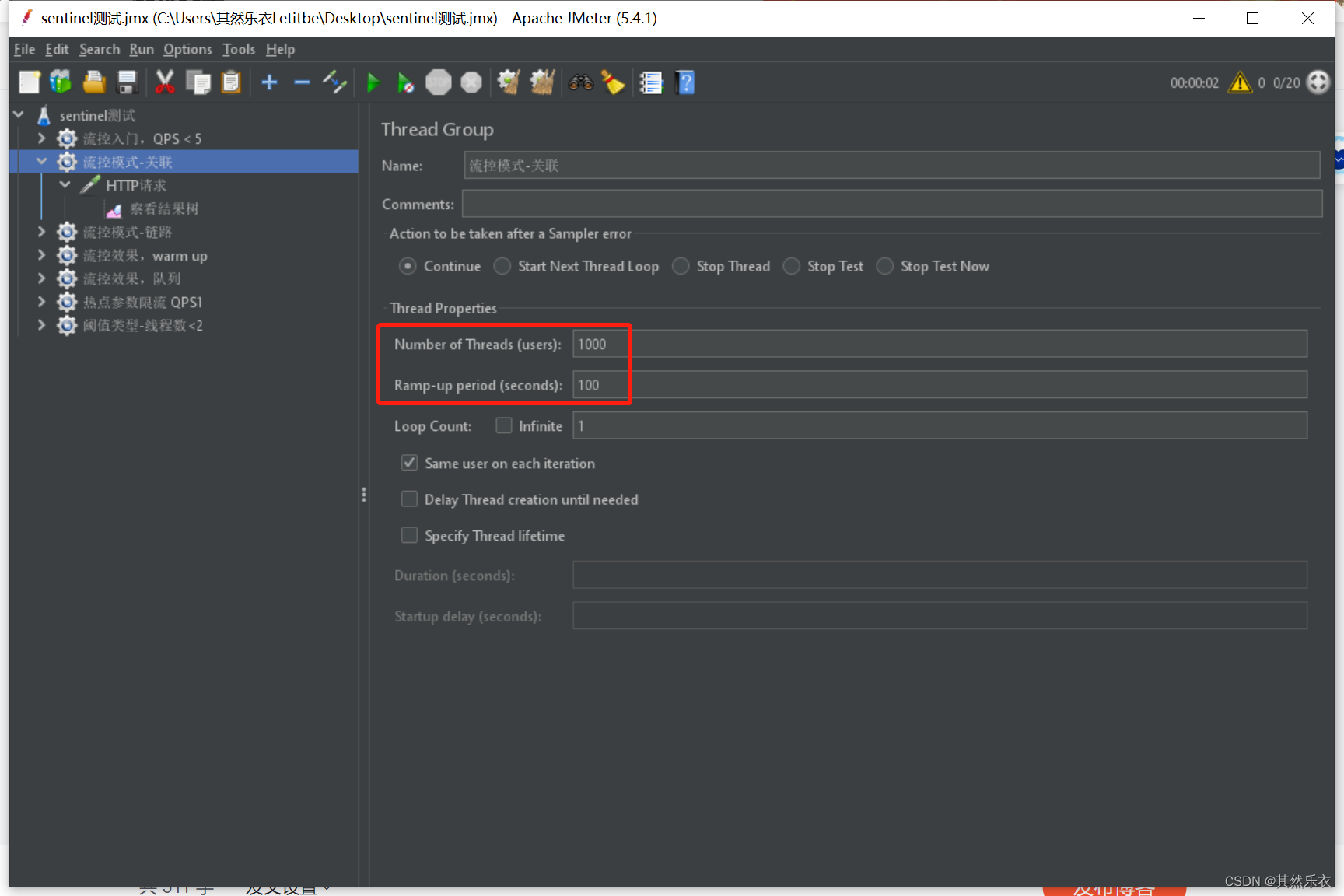

需求:

•在OrderController新建两个端点:/order/query和/order/update,无需实现业务

•配置流控规则,当/order/update资源被访问的QPS超过5时,对/order/query请求限流

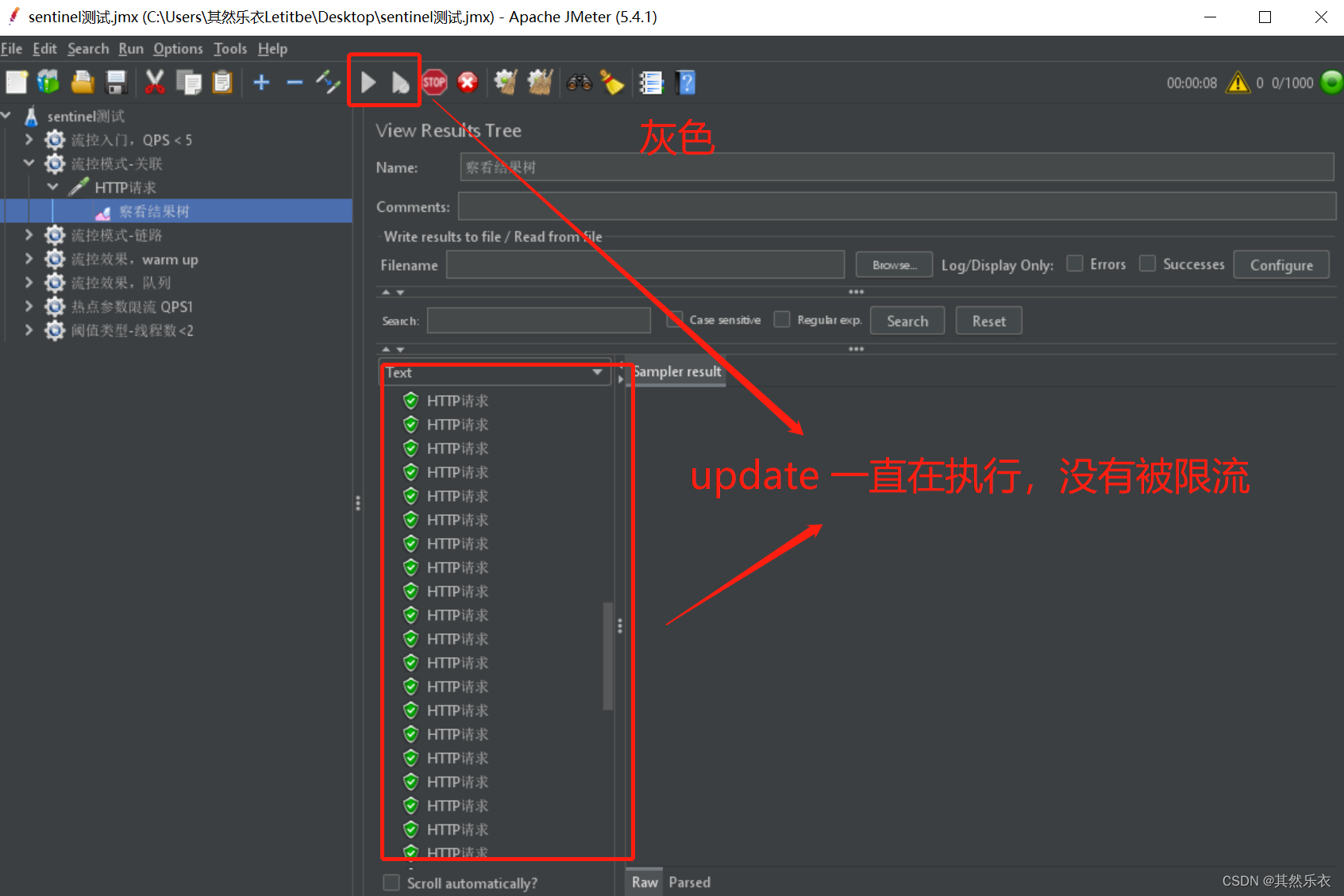

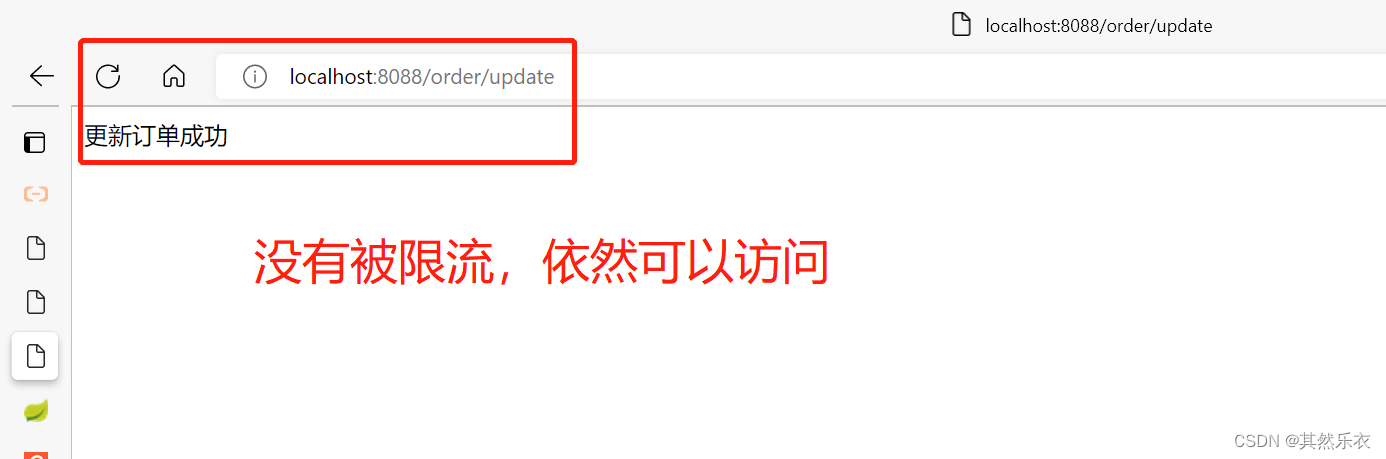

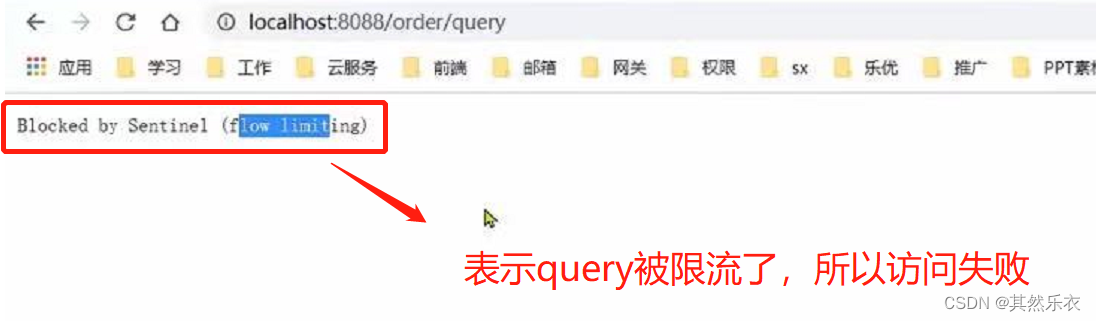

4. 去网页访问验证:

4. 去网页访问验证:

query被限流

两个有竞争关系的资源

一个优先级较高,一个优先级较低(优先级高的触发阈值时(本案例的order),对优先级低的限流(本案例的query))

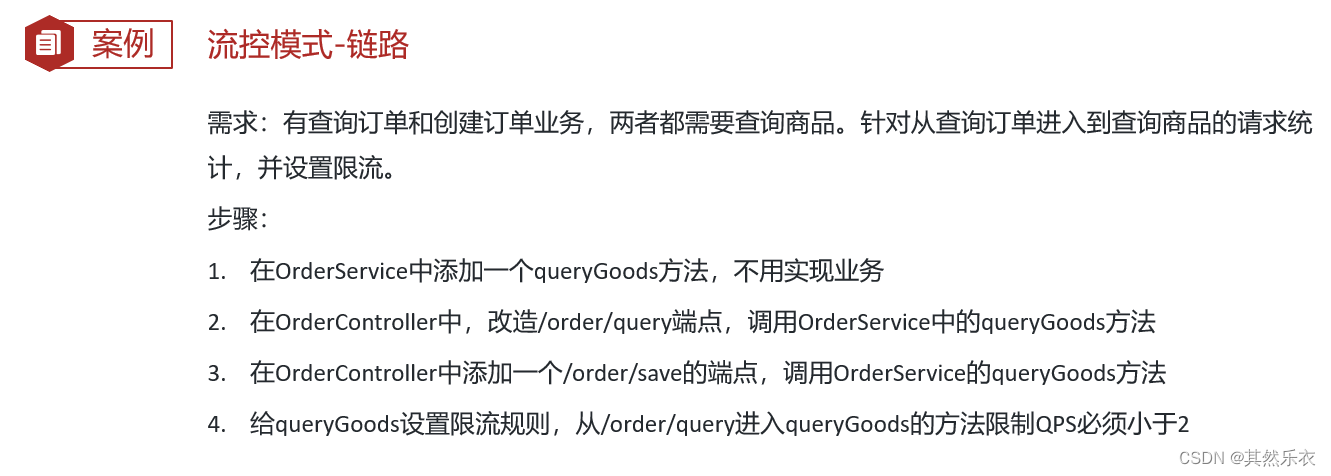

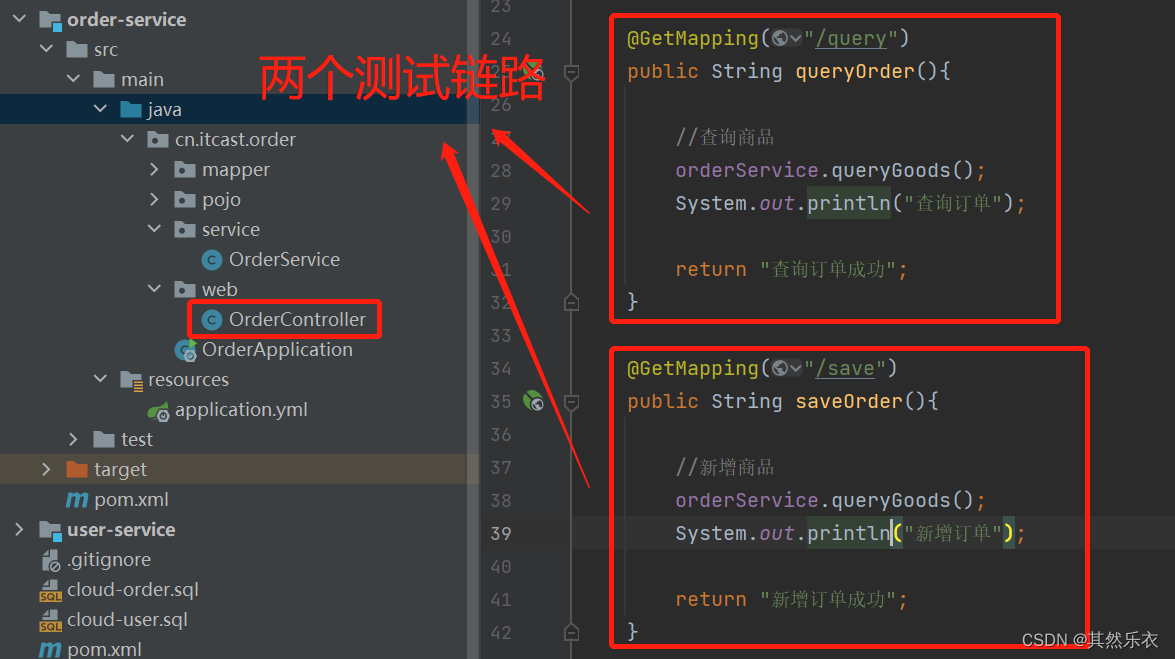

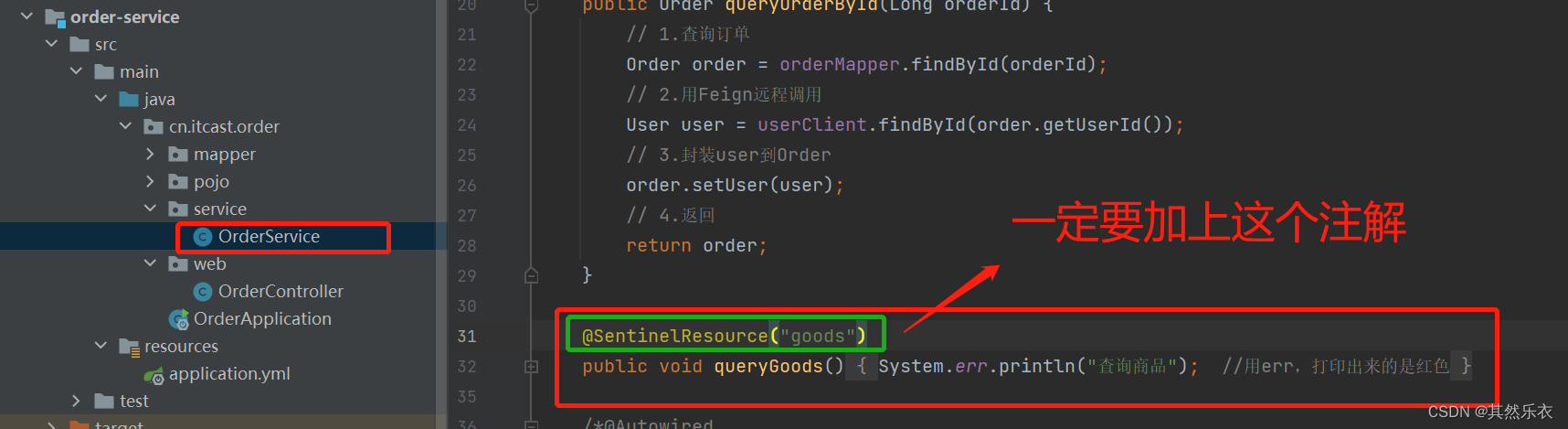

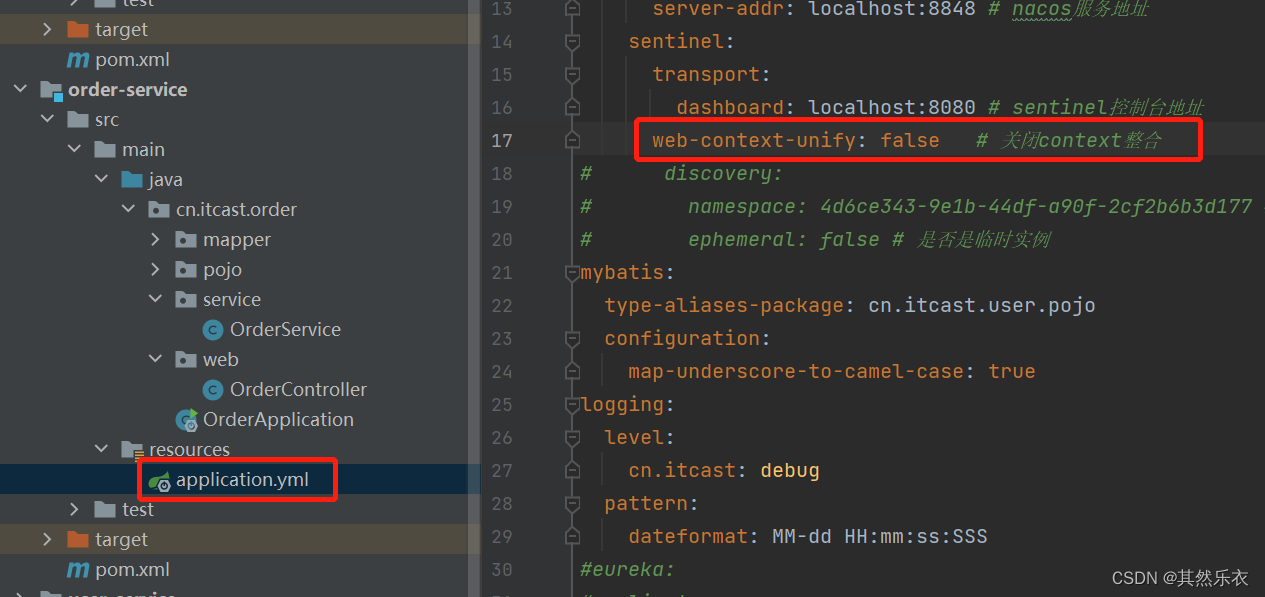

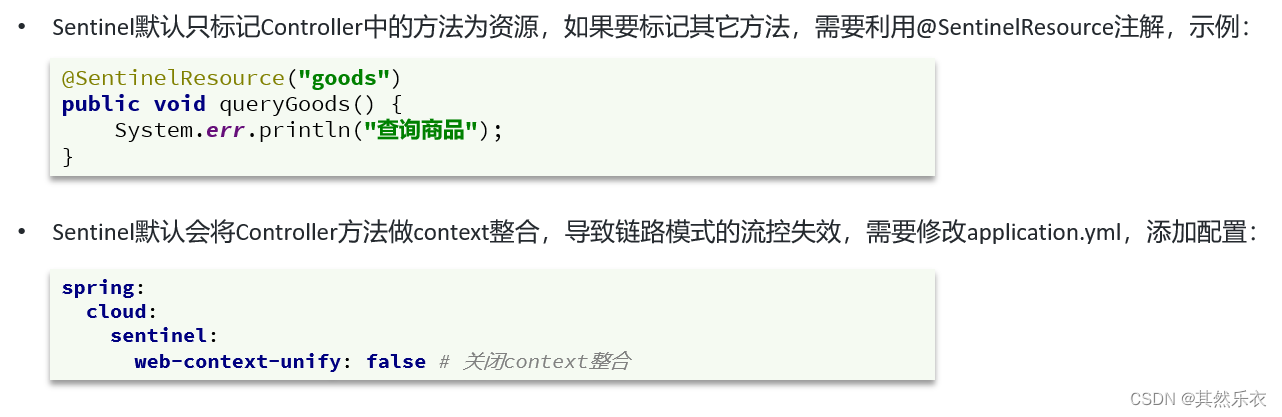

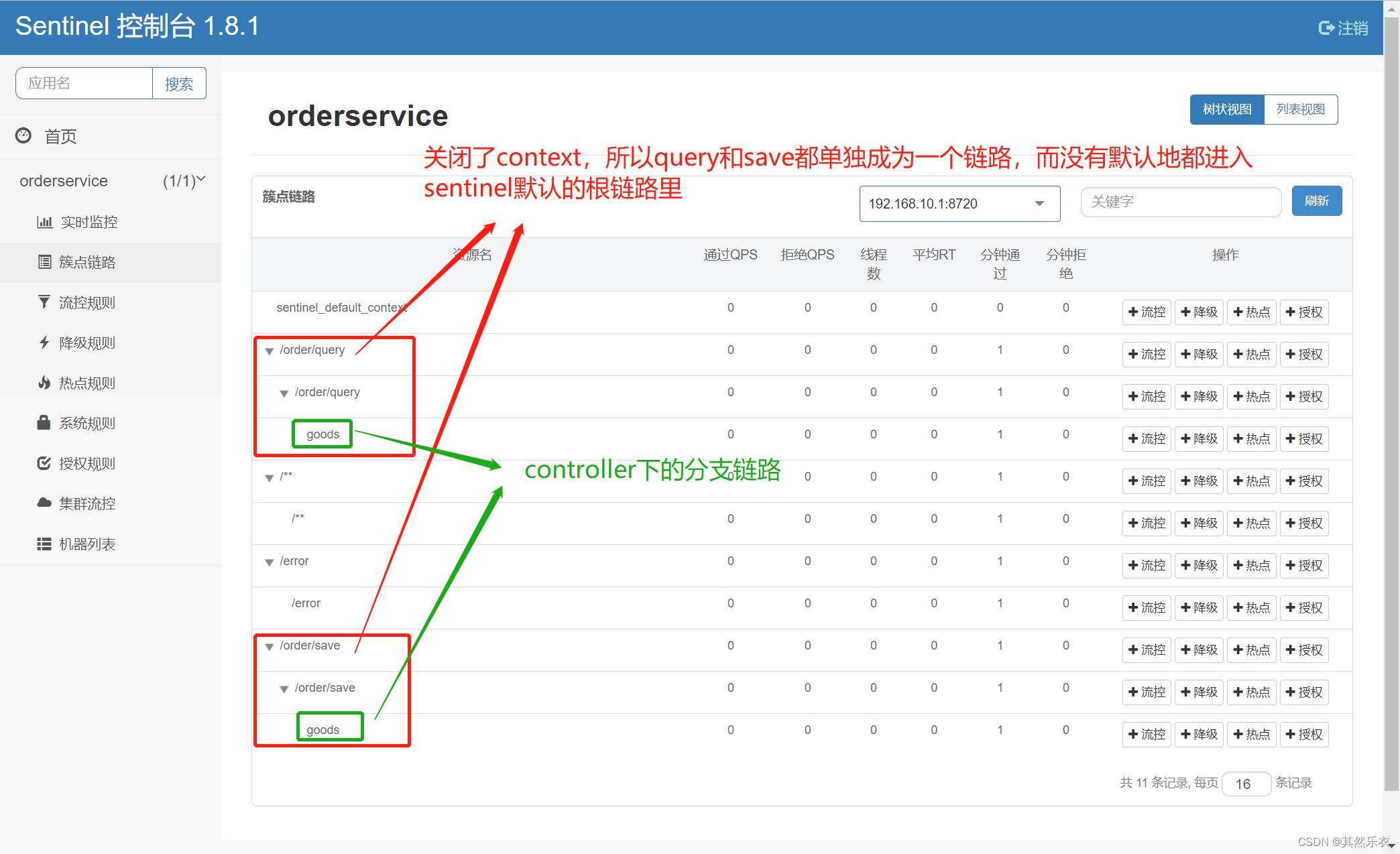

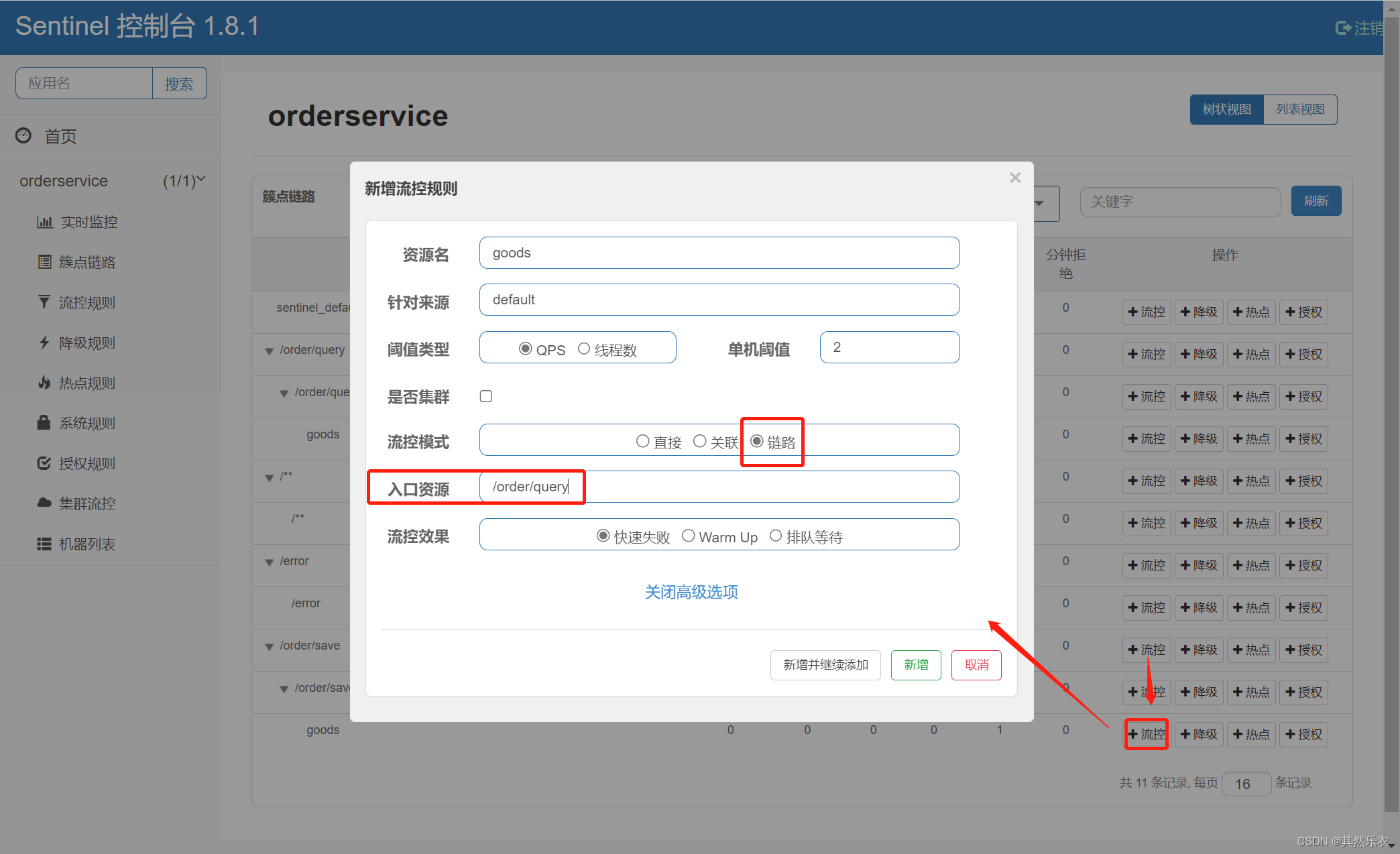

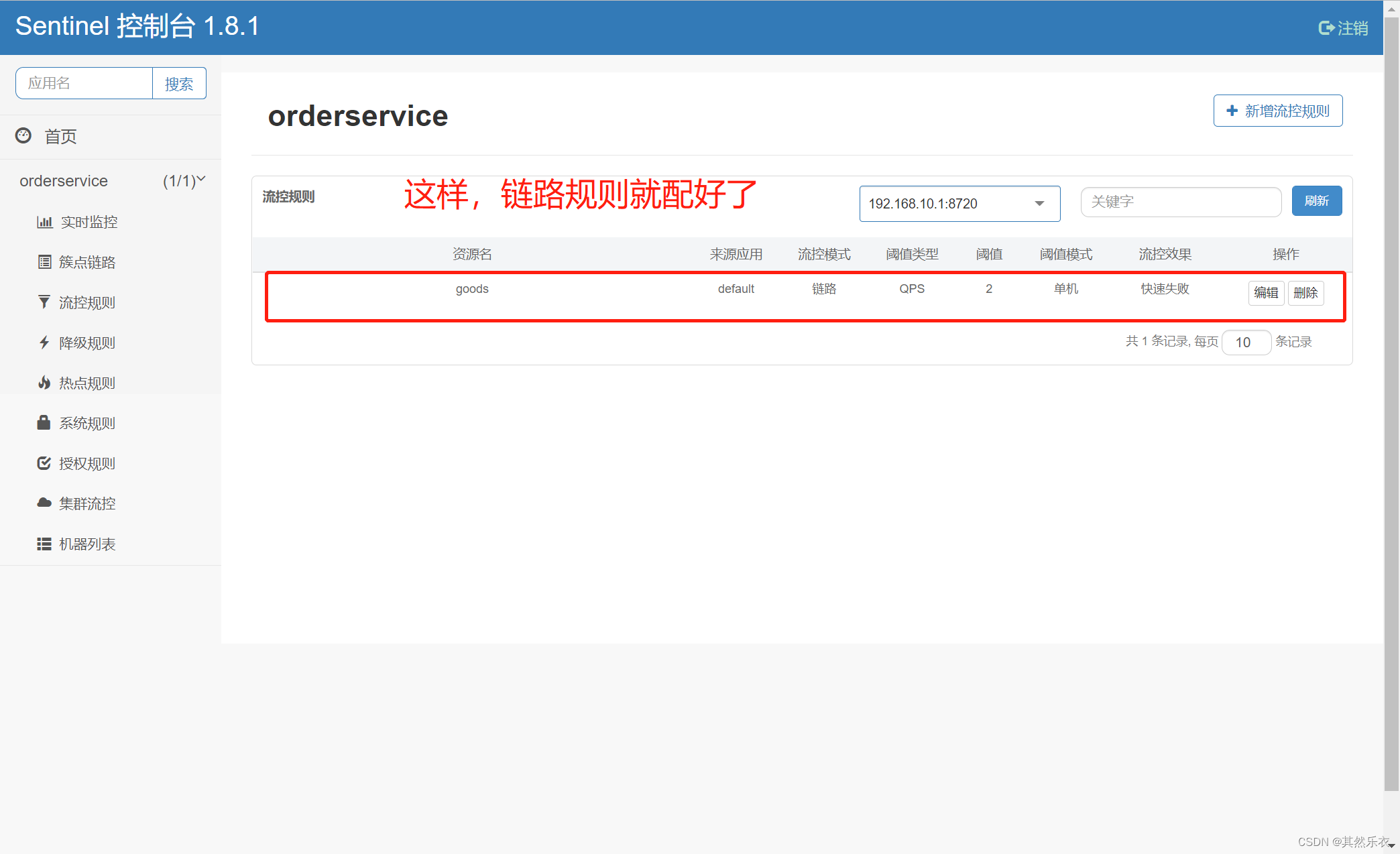

Sentinel默认只标记Controller中的方法为资源,如果要标记其它方法,需要利用@SentinelResource注解

去配置文件里配置,关闭contextM,就可以让controller里的方法单独成为一个链路;不关闭context的话,controller里的方法都会默认进去sentinel默认的根链路里,这样就只有一条链路,无法流控链路模式

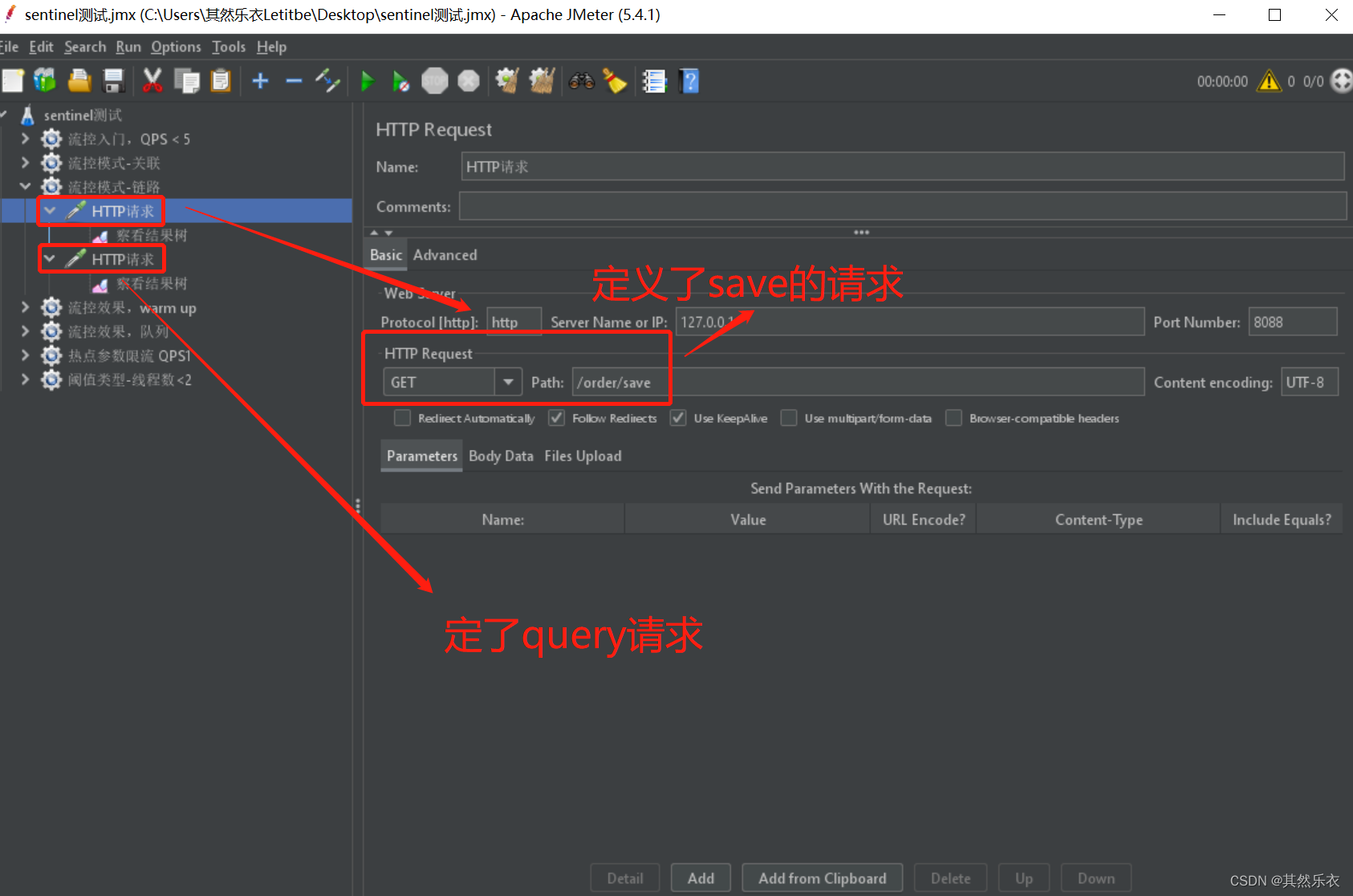

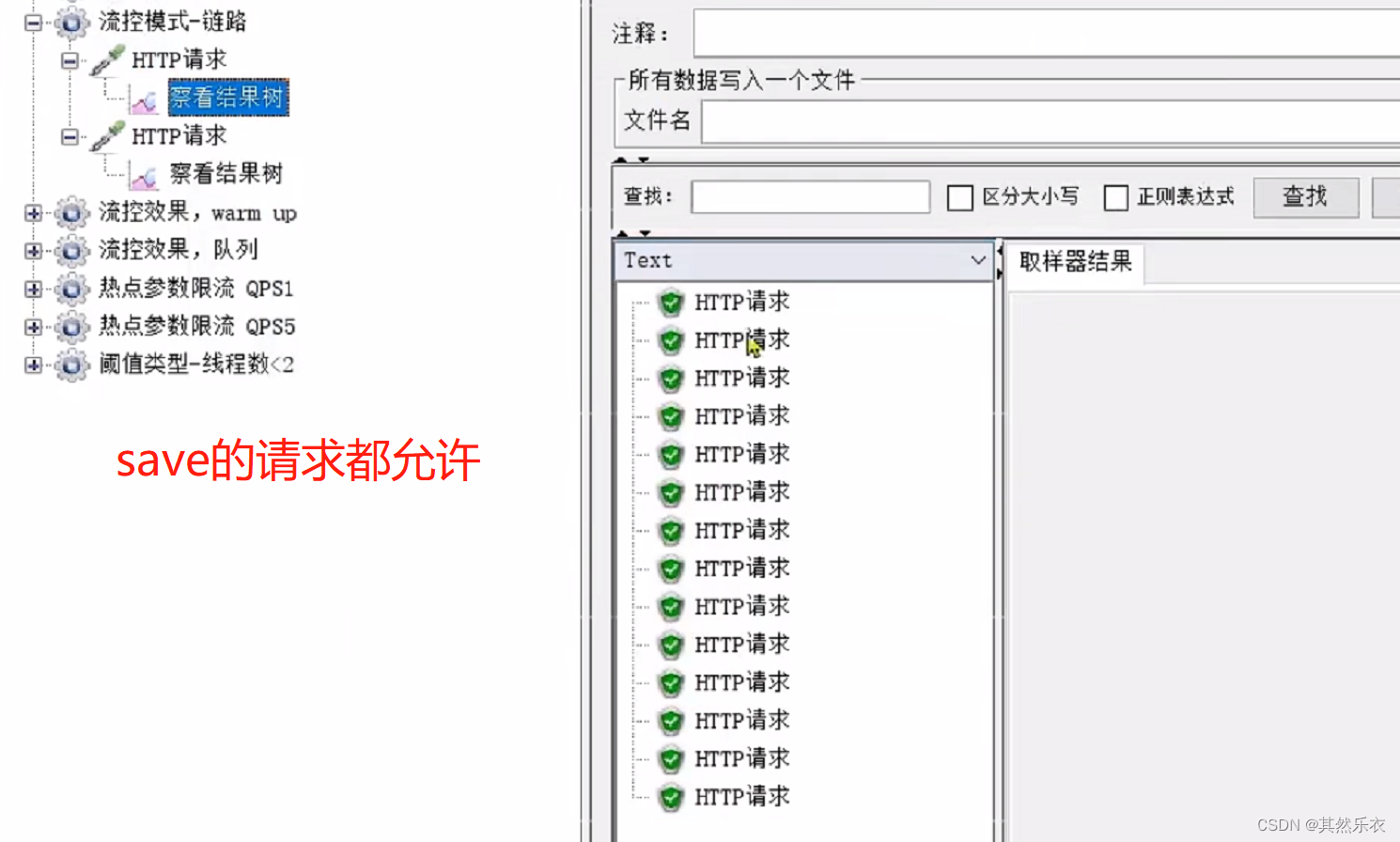

启动测试

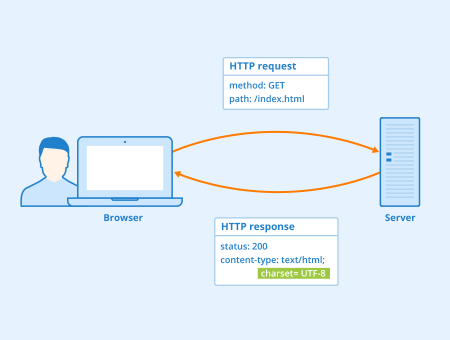

超文本传输协议(HTTP,HyperText Transfer Protocol) 主要是为 Web 浏览器与 Web 服务器之间的通信而设计的。当我们使用浏览器浏览网页的时候,我们网页就是通过 HTTP 请求进行加载的,整个过程如下图所示。

HTTP 协是基于 TCP协议,发送 HTTP 请求之前首先要建立 TCP 连接也就是要经历 3 次握手。目前使用的 HTTP 协议大部分都是 1.1。在 1.1 的协议里面,默认是开启了 Keep-Alive 的,这样的话建立的连接就可以在多次请求中被复用了。

另外, HTTP 协议是”无状态”的协议,它无法记录客户端用户的状态,一般我们都是通过 Session 来记录客户端用户的状态。

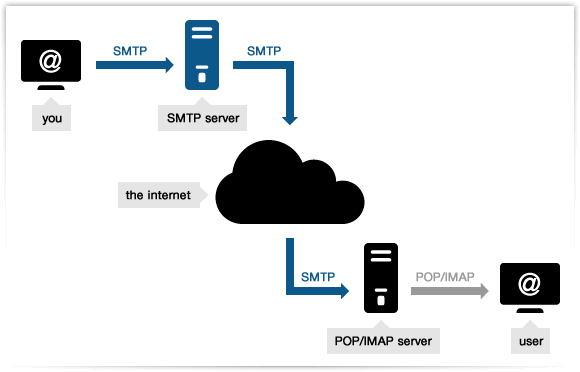

简单邮件传输(发送)协议(SMTP,Simple Mail Transfer Protocol) 基于 TCP 协议,用来发送电子邮件。

注意⚠️:接受邮件的协议不是 SMTP 而是 POP3 协议。

SMTP 协议这块涉及的内容比较多,下面这两个问题比较重要:

电子邮件的发送过程?

比如我的邮箱是“dabai@cszhinan.com”,我要向“xiaoma@qq.com”发送邮件,整个过程可以简单分为下面几步:

如何判断邮箱是真正存在的?

很多场景(比如邮件营销)下面我们需要判断我们要发送的邮箱地址是否真的存在,这个时候我们可以利用 SMTP 协议来检测:

推荐几个在线邮箱是否有效检测工具:

这两个协议没必要多做阐述,只需要了解 POP3 和 IMAP 两者都是负责邮件接收的协议即可。另外,需要注意不要将这两者和 SMTP 协议搞混淆了。SMTP 协议只负责邮件的发送,真正负责接收的协议是POP3/IMAP。

IMAP 协议相比于POP3更新一点,为用户提供的可选功能也更多一点,几乎所有现代电子邮件客户端和服务器都支持IMAP。大部分网络邮件服务提供商都支持POP3和IMAP。

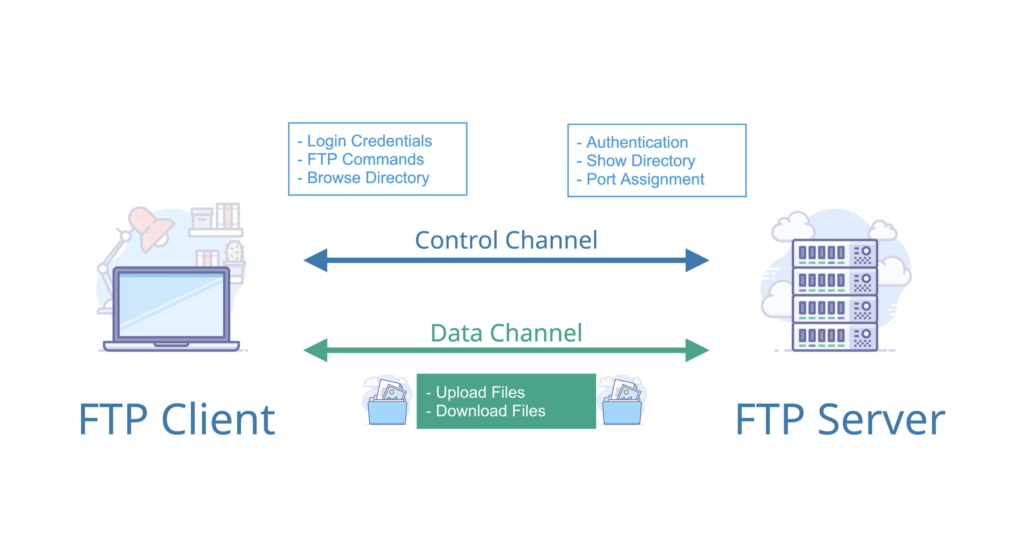

FTP 协议 主要提供文件传输服务,基于 TCP 实现可靠的传输。使用 FTP 传输文件的好处是可以屏蔽操作系统和文件存储方式。

FTP 是基于客户—服务器(C/S)模型而设计的,在客户端与 FTP 服务器之间建立两个连接。如果我们要基于 FTP 协议开发一个文件传输的软件的话,首先需要搞清楚 FTP 的原理。关于 FTP 的原理,很多书籍上已经描述的非常详细了:

FTP 的独特的优势同时也是与其它客户服务器程序最大的不同点就在于它在两台通信的主机之间使用了两条 TCP 连接(其它客户服务器应用程序一般只有一条 TCP 连接):

- 控制连接:用于传送控制信息(命令和响应)

- 数据连接:用于数据传送;

这种将命令和数据分开传送的思想大大提高了 FTP 的效率。

Telnet 协议 通过一个终端登陆到其他服务器,建立在可靠的传输协议 TCP 之上。Telnet 协议的最大缺点之一是所有数据(包括用户名和密码)均以明文形式发送,这有潜在的安全风险。这就是为什么如今很少使用Telnet并被一种称为SSH的非常安全的协议所取代的主要原因。

SSH( Secure Shell) 是目前较可靠,专为远程登录会话和其他网络服务提供安全性的协议。利用 SSH 协议可以有效防止远程管理过程中的信息泄露问题。SSH 建立在可靠的传输协议 TCP 之上。

Telnet 和 SSH 之间的主要区别在于 SSH 协议会对传输的数据进行加密保证数据安全性。

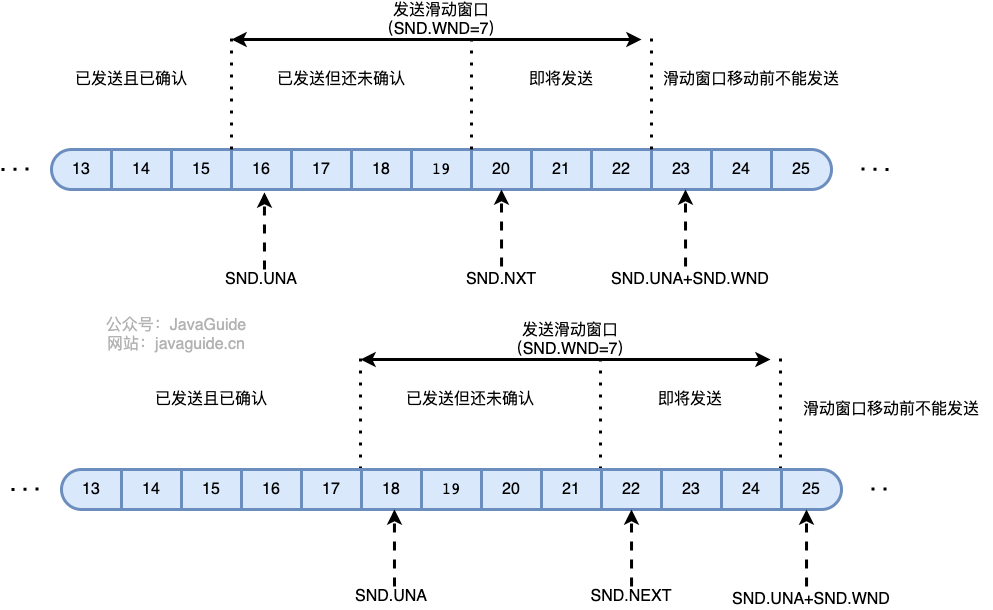

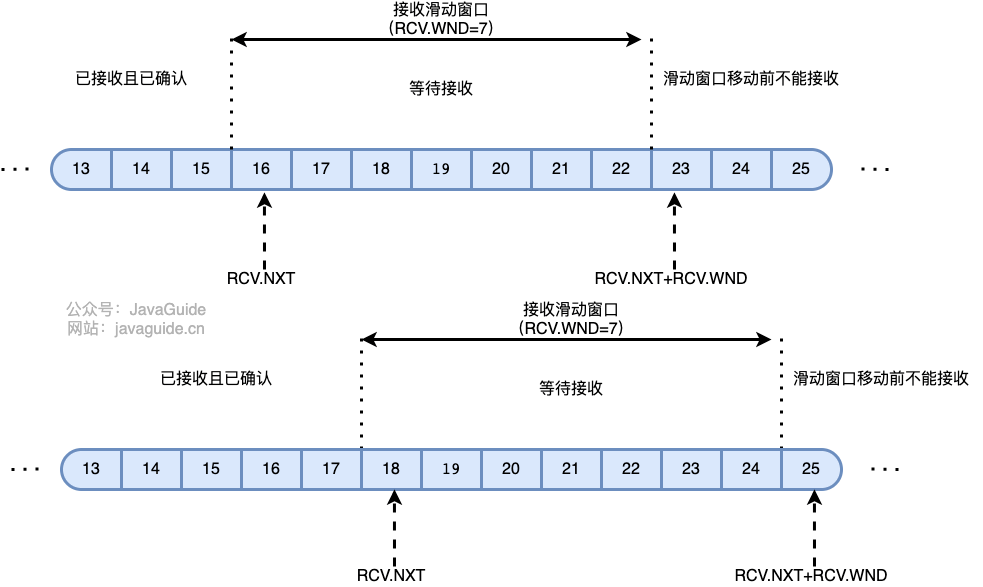

TCP 利用滑动窗口实现流量控制。流量控制是为了控制发送方发送速率,保证接收方来得及接收。 接收方发送的确认报文中的窗口字段可以用来控制发送方窗口大小,从而影响发送方的发送速率。将窗口字段设置为 0,则发送方不能发送数据。

这是因为双方在通信的时候,发送方的速率与接收方的速率是不一定相等,如果发送方的发送速率太快,会导致接收方处理不过来。如果接收方处理不过来的话,就只能把处理不过来的数据存在 接收缓冲区(Receiving Buffers) 里(失序的数据包也会被存放在缓存区里)。如果缓存区满了发送方还在狂发数据的话,接收方只能把收到的数据包丢掉。出现丢包问题的同时又疯狂浪费着珍贵的网络资源。因此,我们需要控制发送方的发送速率,让接收方与发送方处于一种动态平衡才好。

这里需要注意的是(常见误区):

TCP 为全双工(Full-Duplex, FDX)通信,双方可以进行双向通信,客户端和服务端既可能是发送端又可能是接收端。因此,两端各有一个发送缓冲区与接收缓冲区,两端都各自维护一个发送窗口和一个接收窗口。接收窗口大小取决于应用、系统、硬件的限制(TCP传输速率不能大于应用的数据处理速率)。通信双方的发送窗口和接收窗口的要求相同

可用窗口大小 = SND.UNA + SND.WND - SND.NXT 。

接收窗口的大小是根据接收端处理数据的速度动态调整的。 如果接收端读取数据快,接收窗口可能会扩大。 否则,它可能会缩小。

另外,这里的滑动窗口大小只是为了演示使用,实际窗口大小通常会远远大于这个值。

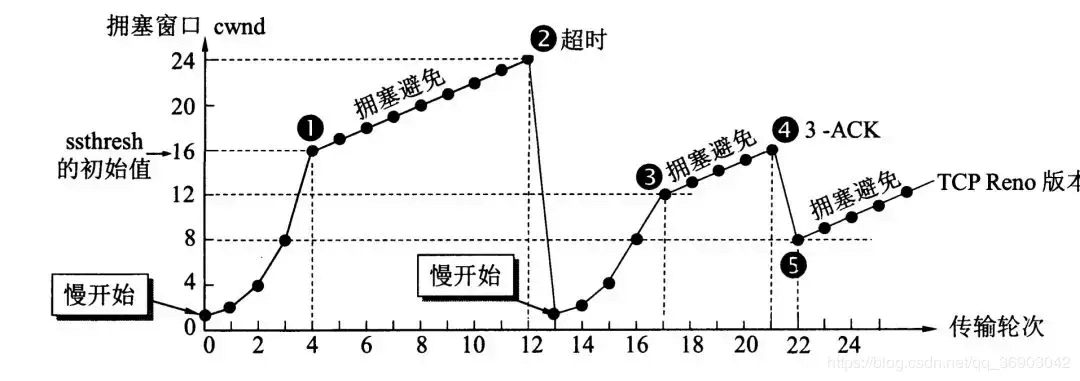

在某段时间,若对网络中某一资源的需求超过了该资源所能提供的可用部分,网络的性能就要变坏。这种情况就叫拥塞。拥塞控制就是为了防止过多的数据注入到网络中,这样就可以使网络中的路由器或链路不致过载。拥塞控制所要做的都有一个前提,就是网络能够承受现有的网络负荷。拥塞控制是一个全局性的过程,涉及到所有的主机,所有的路由器,以及与降低网络传输性能有关的所有因素。相反,流量控制往往是点对点通信量的控制,是个端到端的问题。流量控制所要做到的就是抑制发送端发送数据的速率,以便使接收端来得及接收。

为了进行拥塞控制,TCP 发送方要维持一个 拥塞窗口(cwnd) 的状态变量。拥塞控制窗口的大小取决于网络的拥塞程度,并且动态变化。发送方让自己的发送窗口取为拥塞窗口和接收方的接受窗口中较小的一个。

TCP 的拥塞控制采用了四种算法,即 慢开始 、 拥塞避免 、快重传 和 快恢复。在网络层也可以使路由器采用适当的分组丢弃策略(如主动队列管理 AQM),以减少网络拥塞的发生。

自动重传请求(Automatic Repeat-reQuest,ARQ)是 OSI 模型中数据链路层和传输层的错误纠正协议之一。它通过使用确认和超时这两个机制,在不可靠服务的基础上实现可靠的信息传输。如果发送方在发送后一段时间之内没有收到确认信息(Acknowledgements,就是我们常说的 ACK),它通常会重新发送,直到收到确认或者重试超过一定的次数。

ARQ 包括停止等待 ARQ 协议和连续 ARQ 协议。

停止等待协议是为了实现可靠传输的,它的基本原理就是每发完一个分组就停止发送,等待对方确认(回复 ACK)。如果过了一段时间(超时时间后),还是没有收到 ACK 确认,说明没有发送成功,需要重新发送,直到收到确认后再发下一个分组;

在停止等待协议中,若接收方收到重复分组,就丢弃该分组,但同时还要发送确认。

发送方发送分组, 接收方在规定时间内收到,并且回复确认.发送方再次发送。

停止等待协议中超时重传是指只要超过一段时间仍然没有收到确认,就重传前面发送过的分组(认为刚才发送过的分组丢失了)。因此每发送完一个分组需要设置一个超时计时器,其重传时间应比数据在分组传输的平均往返时间更长一些。这种自动重传方式常称为 自动重传请求 ARQ 。另外在停止等待协议中若收到重复分组,就丢弃该分组,但同时还要发送确认。

连续 ARQ 协议可提高信道利用率。发送方维持一个发送窗口,凡位于发送窗口内的分组可以连续发送出去,而不需要等待对方确认。接收方一般采用累计确认,对按序到达的最后一个分组发送确认,表明到这个分组为止的所有分组都已经正确收到了。

信道利用率高,容易实现,即使确认丢失,也不必重传。

不能向发送方反映出接收方已经正确收到的所有分组的信息。 比如:发送方发送了 5 条 消息,中间第三条丢失(3 号),这时接收方只能对前两个发送确认。发送方无法知道后三个分组的下落,而只好把后三个全部重传一次。这也叫 Go-Back-N(回退 N),表示需要退回来重传已经发送过的 N 个消息。

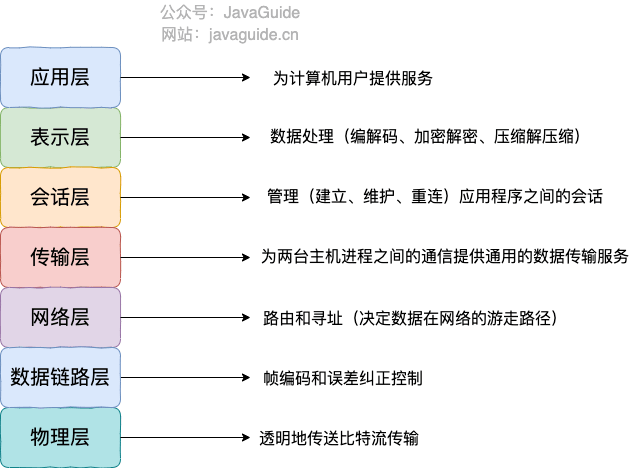

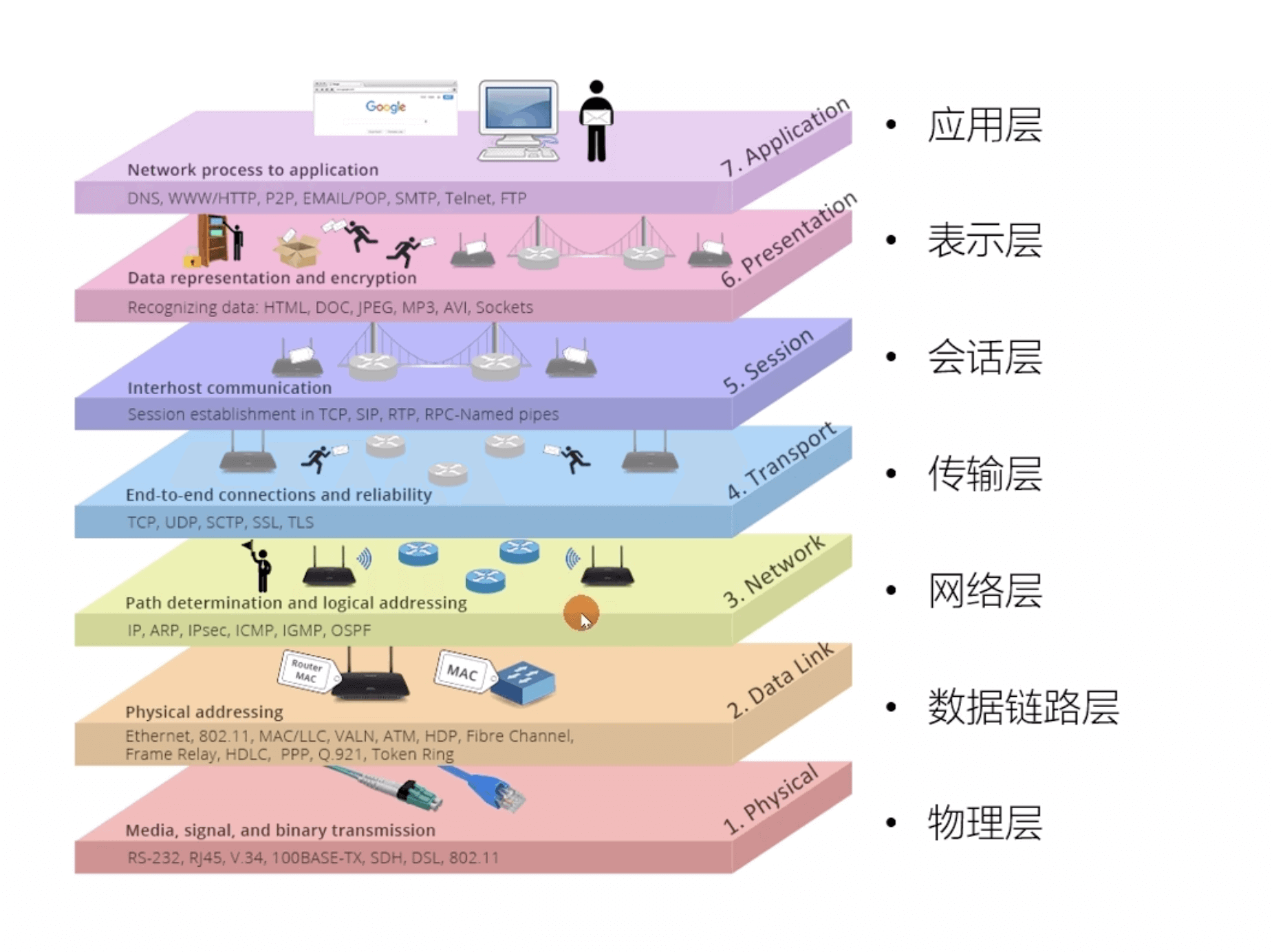

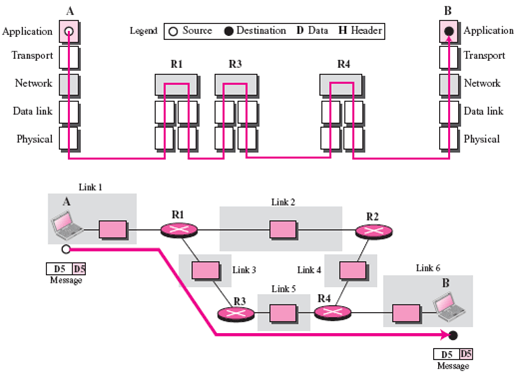

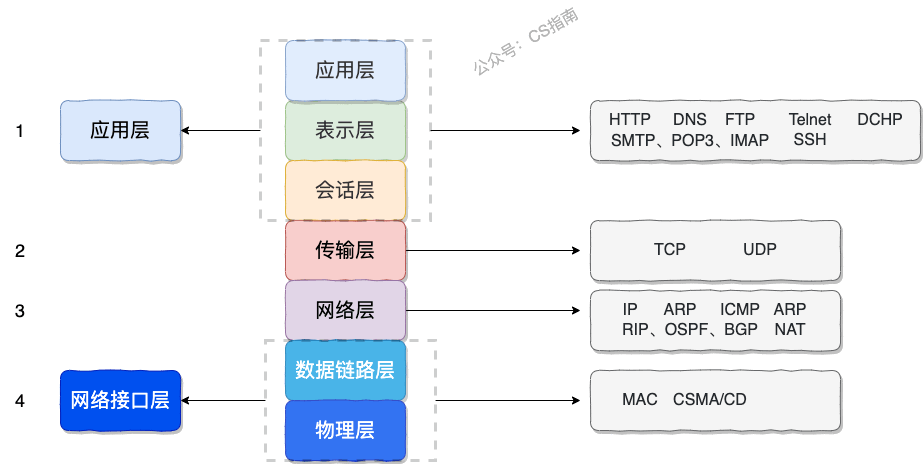

OSI模型: 即开放式通信系统互联参考模型(Open System Interconnection Reference Model),是国际标准化组织(ISO)提出的一个试图使各种计算机在世界范围内互连为网络的标准框架,简称OSI。

OSI 七层模型 是国际标准化组织a提出一个网络分层模型,其大体结构以及每一层提供的功能如下图所示:

每一层都专注做一件事情,并且每一层都需要使用下一层提供的功能比如传输层需要使用网络层提供的路由和寻址功能,这样传输层才知道把数据传输到哪里去。

OSI 的七层体系结构概念清楚,理论也很完整,但是它比较复杂而且不实用,而且有些功能在多个层中重复出现。

上面这种图可能比较抽象,再来一个比较生动的图片。下面这个图片是我在国外的一个网站上看到的,非常赞!

既然 OSI 七层模型这么厉害,为什么干不过 TCP/IP 四 层模型呢?

的确,OSI 七层模型当时一直被一些大公司甚至一些国家政府支持。这样的背景下,为什么会失败呢?我觉得主要有下面几方面原因:

OSI 七层模型虽然失败了,但是却提供了很多不错的理论基础。为了更好地去了解网络分层,OSI 七层模型还是非常有必要学习的。

最后再分享一个关于 OSI 七层模型非常不错的总结图片!

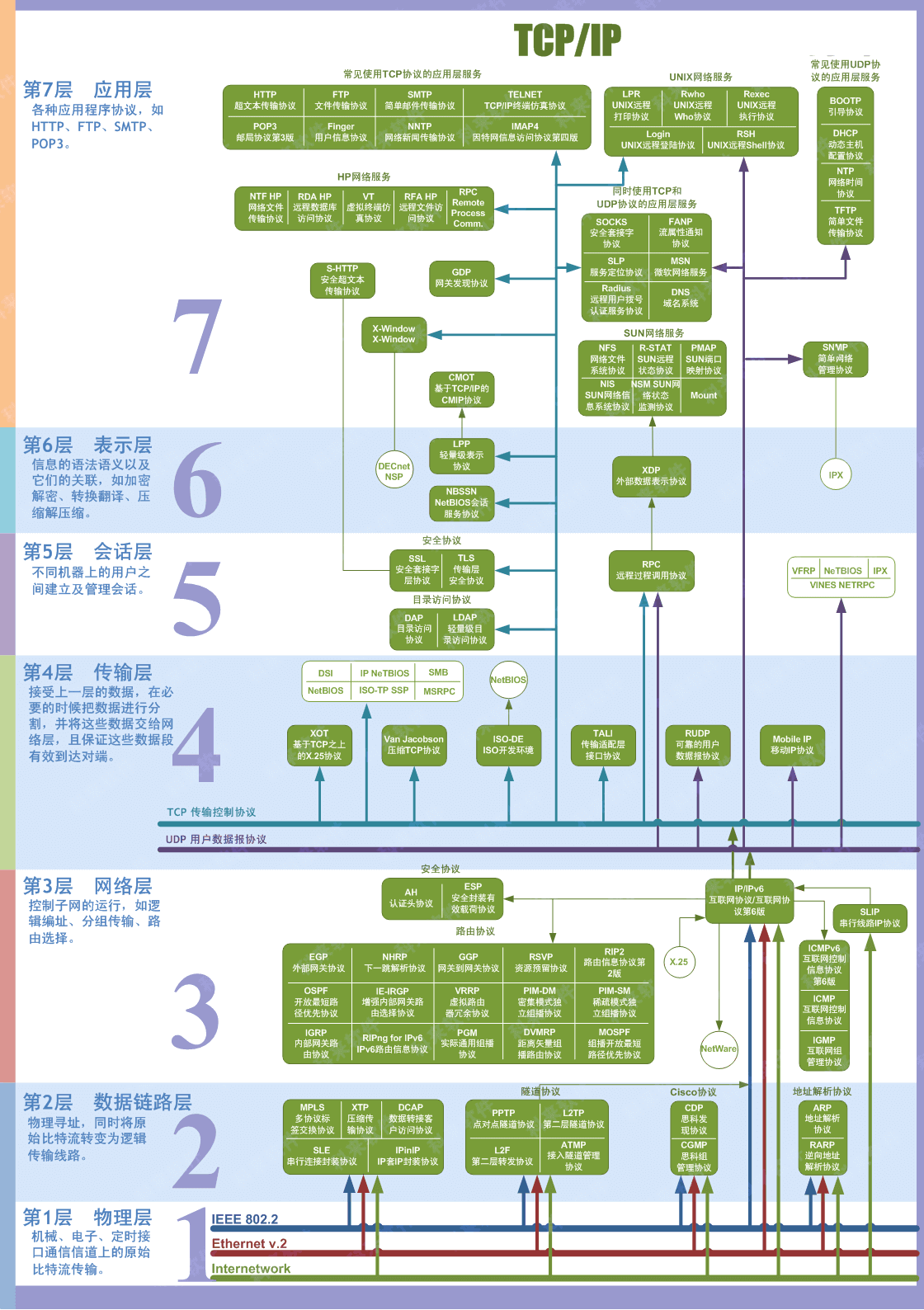

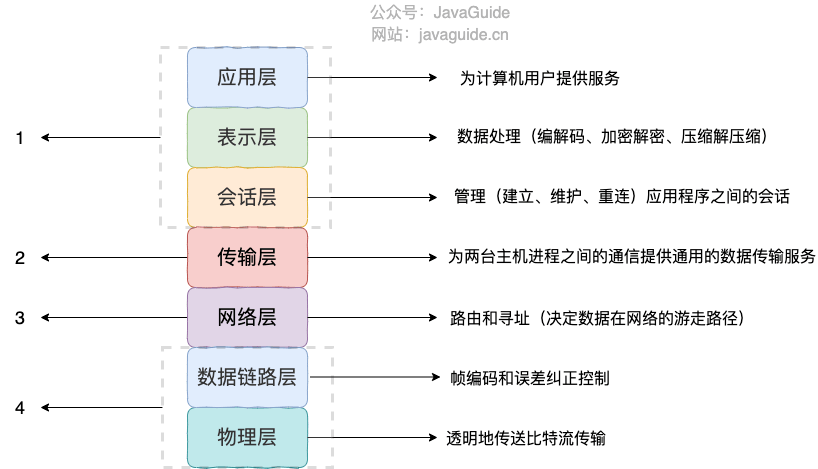

TCP/IP 四层模型 是目前被广泛采用的一种模型,我们可以将 TCP / IP 模型看作是 OSI 七层模型的精简版本,由以下 4 层组成:

需要注意的是,我们并不能将 TCP/IP 四层模型 和 OSI 七层模型完全精确地匹配起来,不过可以简单将两者对应起来,如下图所示:

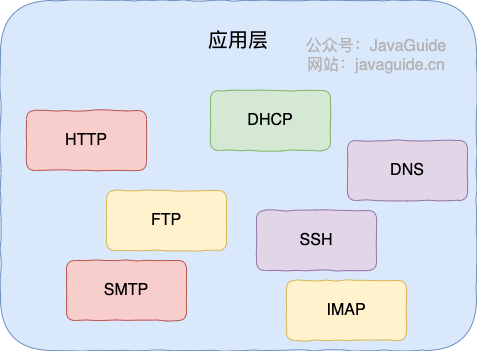

应用层位于传输层之上,主要提供两个终端设备上的应用程序之间信息交换的服务,它定义了信息交换的格式,消息会交给下一层传输层来传输。 我们把应用层交互的数据单元称为报文。

应用层协议定义了网络通信规则,对于不同的网络应用需要不同的应用层协议。在互联网中应用层协议很多,如支持 Web 应用的 HTTP 协议,支持电子邮件的 SMTP 协议等等。

应用层常见协议总结,请看这篇文章:应用层常见协议总结(应用层)。

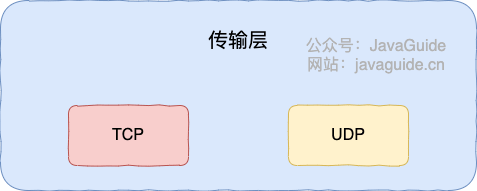

传输层的主要任务就是负责向两台终端设备进程之间的通信提供通用的数据传输服务。 应用进程利用该服务传送应用层报文。“通用的”是指并不针对某一个特定的网络应用,而是多种应用可以使用同一个运输层服务。

运输层主要使用以下两种协议:

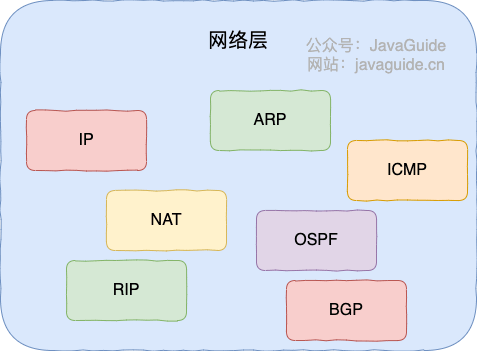

网络层负责为分组交换网上的不同主机提供通信服务。 在发送数据时,网络层把运输层产生的报文段或用户数据报封装成分组和包进行传送。在 TCP/IP 体系结构中,由于网络层使用 IP 协议,因此分组也叫 IP 数据报,简称数据报。

⚠️注意 :不要把运输层的“用户数据报 UDP”和网络层的“IP 数据报”弄混。

网络层的还有一个任务就是选择合适的路由,使源主机运输层所传下来的分组,能通过网络层中的路由器找到目的主机。

这里强调指出,网络层中的“网络”二字已经不是我们通常谈到的具体网络,而是指计算机网络体系结构模型中第三层的名称。

互联网是由大量的异构(heterogeneous)网络通过路由器(router)相互连接起来的。互联网使用的网络层协议是无连接的网际协议(Internet Prococol)和许多路由选择协议,因此互联网的网络层也叫做 网际层 或 IP 层。

网络层常见协议 :

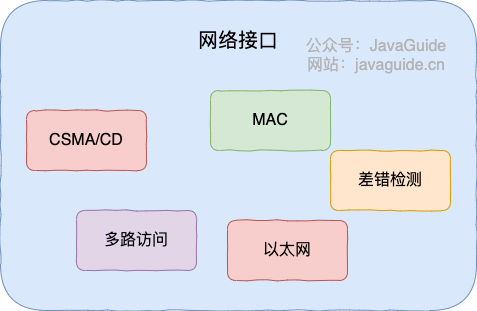

我们可以把网络接口层看作是数据链路层和物理层的合体。

简单总结一下每一层包含的协议和核心技术:

应用层协议 :

传输层协议 :

网络层协议 :

网络接口层 :

在这篇文章的最后,我想聊聊:“为什么网络要分层?”。

说到分层,我们先从我们平时使用框架开发一个后台程序来说,我们往往会按照每一层做不同的事情的原则将系统分为三层(复杂的系统分层会更多):

复杂的系统需要分层,因为每一层都需要专注于一类事情。网络分层的原因也是一样,每一层只专注于做一类事情。

好了,再来说回:“为什么网络要分层?”。我觉得主要有 3 方面的原因:

我想到了计算机世界非常非常有名的一句话,这里分享一下:

计算机科学领域的任何问题都可以通过增加一个间接的中间层来解决,计算机整个体系从上到下都是按照严格的层次结构设计的。